区分“模型”和“应用”是对AI最大的误解 原创

作者|高飞

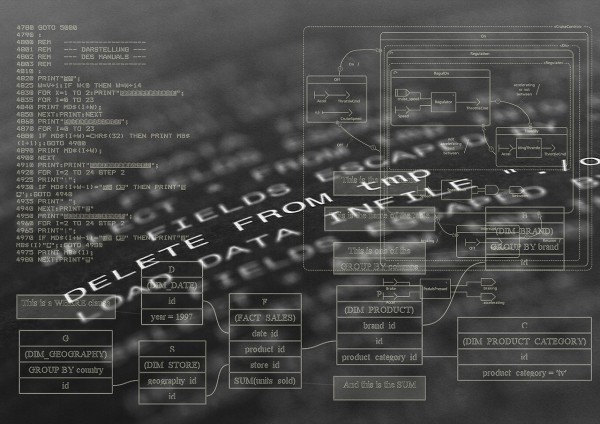

多数人仍然习惯用传统的“两层思维”生态架构来思考大模型:系统基座在下面,面向用户的应用在上面,二者泾渭分明。

历史上看,这种二分法是对的:

1. DOS 操作系统面世时,没有可执行的 “.com” 或 “.exe” 程序,用户根本无从交互;

2. Windows 问世时,也没有人会拿一个操作系统单独“空跑”。哪怕是当年经典的“纸牌”和“扫雷”,也是微软为了让大众理解并熟悉图形界面,不得不自己编写的小应用;

3. iOS 让智能手机成为一种基础设施,但首批吸引用户使用的,还是纸飞机、拍照,甚至打电话这些关键应用;

4. 云计算概念提出来后,人们谈论的都是基于云的 SaaS 和各种网站,用不了多久就变成“这家公司用 AWS 跑后台”这样的陈述。云计算本身并没有变成一个直接面向大众的入口。

但是,AI 之所以是一场技术革命,就意味着它会颠覆我们已有的常识。我认为,两层架构在这个时代已经失效。

举个例子:OpenAI 的 ChatGPT 从一开始发布时,就既是一个模型,又是一个面向大众的消费级应用。

你不需要再去下载任何“子程序”才能让 ChatGPT 跑起来;只需要在对话框输入文字(提示工程,Prompt Engineering),它就能执行推理或生成内容。它甚至创造了最快达到 1 亿月活用户的新纪录。这是一个毫无争议的应用。

但它同时也是一种模型,OpenAI提供了 API 调用,让无数应用可以基于它构建。

当我们说 “DeepSeek” 时,既可能指一种在 LMarena、AIME 榜单上排名靠前的前沿推理模型,也可以指一款曾登顶中美等多个国家 iOS 应用商店的 App。

所以,下次再有人问:“我们该投大语言模型还是应用层?”也许可以告诉他,这不是一个非此即彼的问题。在这个领域里,模型就是应用,应用也就是模型。

如果你在做模型,你的用户并不需要了解多少编译、链接或 SDK 之类的东西,就能够通过自然语言提示来使用它。

反过来,如果你在做 AI 应用,其实最终还是在向用户交付一项“大模型”能力,无论你使用的是提示工程、强化学习、工作流、Agent,还是别的“套壳”手段,底层都还是那台贯通一切的“大脑”。

模型与应用的边界正在塌陷,用户甚至不知道,或者并不在意自己是在“跑模型”还是在“用程序”。

但是,除了投资规模,做应用也并不比做基座模型廉价,因为在这个时代,切换一个模型底座并不比换辆车开更难。几乎你使用的所有 AI 应用,都提供了在后台切换模型的设置选项。

你能在云计算时代想象这些吗?一个网站提供了切换不同云主机访问?还记得适配安卓、iOS 等不同系统、不同尺寸的手机有多难吗?

只不过,应用开发者还是需要一点戒备。你的产品最好不要在“智能演化”的延长线上。就像山姆·奥特曼(Sam Altman)所说:如果基座模型变得更好,你的应用也应该同步变得更好,而不是被彻底替代、不再被需要。

好文章,需要你的鼓励

超越能源使用:数据中心可持续运营策略

随着AI广泛应用推动数据中心建设热潮,运营商面临可持续发展挑战。2024年底美国已建成或批准1240个数据中心,能耗激增引发争议。除能源问题外,服务器和GPU更新换代产生的电子废物同样严重。通过采用模块化可修复系统、AI驱动资产跟踪、标准化数据清理技术以及与认证ITAD合作伙伴合作,数据中心可实现循环经济模式,在确保数据安全的同时减少环境影响。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

超大规模云数据中心是数字经济的支柱,2026年将继续保持核心地位。AWS、微软、谷歌、Meta、甲骨文和阿里巴巴等主要运营商正积极扩张以满足AI和云服务需求激增,预计2026年资本支出将超过6000亿美元。然而增长受到电力供应、设备交付和当地阻力制约。截至2025年末,全球运营中的超大规模数据中心达1297个,总容量预计在12个季度内翻倍。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

针对D-Link路由器严重远程代码执行漏洞的持续攻击活动

联想Qira AI助手跨设备工作,摩托罗拉AI别针展新机

Deno 2.6新增dx工具运行NPM和JSR二进制文件

西门子CES 2026发布多项技术,加速工业AI革命

Littelfuse推出适用于电动汽车电池、电机和安全系统的汽车级电流传感器

CES 2026 | 机器人开发的“ChatGPT时刻”已到 老黄定调“物理AI”的路线图

超越能源使用:数据中心可持续运营策略

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手