支持任意分辨率图像的MLLM!定位识别超强!Apple提出Ferret-v2!

数源AI 最新论文解读系列

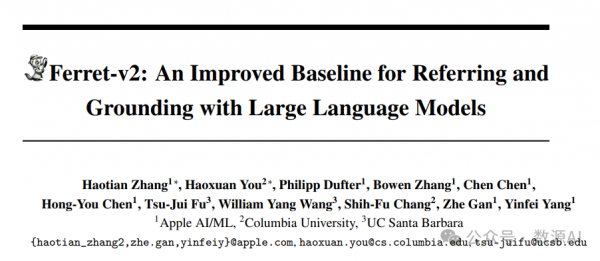

论文名:Ferret-v2: An Improved Baseline for Referring and Grounding with Large Language Models

论文链接:https://arxiv.org/pdf/2404.07973.pdf

引言

多模态大型语言模型(Multimodal Large Language Models,MLLMs)在人工智能 的最新进展中扮演着关键角色,作为通用全能助手开发的基础元素。然而,这些方法依赖 于粗粒度的图像级对齐,缺乏对细节的理解(如区域描述和推理)。为此,一些工作将定位能力融入对话,解锁了指称能力,即允许用户以对 象或区域作为输入,模型以包含边界框坐标的空间坐标作为响应。这种进步使MLLMs能够 执行需要详细视觉理解的任务,标志着该领域取得了显著进展。

简介

虽然Ferret无缝地将区域理解融入大型语言模型(LLM),增强了其指代和 定位能力,但它也存在局限性:受限于预训练固定的视觉编码器,且在更 广泛的任务上表现不佳。本工作中,我们推出了Ferret-v2,这是对Ferret的 重大升级,具有三大设计亮点:(1) 任意分辨率的定位和指代:一种灵活的 方法,能够轻松处理更高分辨率的图像,提升模型处理和理解图像细节的 能力。(2) 多层次视觉编码:通过整合DINOv2编码器,模型能够学习更全 面且多样的全局和精细视觉信息的底层上下文。(3) 三阶段训练范式:除了 图像-描述对的对齐,我们还提出在最终指令调优前增加一个高分辨率密集对齐的阶段。实验表明,由于高分辨率扩展和精细视觉处理,Ferret-v2在对Ferret和其他最先进的方法上实现了显著的提升。

方法与模型

我们首先在第3.1节回顾Ferret的设计原则(Ferret设计原理), 并在第3.2节探讨高分辨率 缩放的深入研究。 接着, 在第3.3节, 我们将探讨模型架构的改进, 包括在任意分辨率下实现语义绑定和参照 (多分辨率绑定与参照), 以及多粒度的视觉编码。 最后, 我们在第3.4节介绍一种增强的训练方法, 旨在提升模型对全局和局部元素对齐的精确性(全局与局部对齐的训练优化)。

1

A Revisit of Ferret

近期,模型的融合((Zhang et al., 2023b; Chen et al., 2023b; Peng et al., 2023; Lai et al., 2023; Zhao et al., 2023; You et al., 2023))和与视觉感知相关的任务受到了越来越多的关注。Ferret ((You et al., 2023))在自然图像的多样形状和细节级别上的空间指代和定位能力上,区别于 其他多模态语言模型。它通过开发混合区域表示来处理不同类型的区域,如点、框或自由 形态,每个区域由离散坐标令牌、连续区域特征(如果可用)以及区域名称的组合来标识。

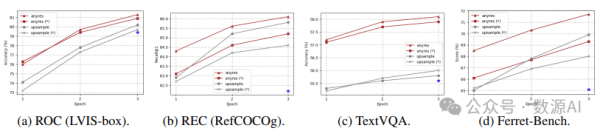

图 2: "直接上采样"和"任意分辨率"方法在ROC、 REC、 TextVQA和Ferret-Bench上的性能。

坐标被标准化到0到999的范围内,点用[x, y]表示,形状用[xmin, ymin, xmax, ymax]表示。连续区域特征由一个空间感知的视觉采样器提取,该采样器对区域特征进行采样和聚合。最终,一个区域表示为"“?region_name? ?coordinates? ?continuous_fea?”,例如提问"这个区域[100, 50, 200, 300]的?continuous_fea?是什么?"为了实现定位,Ferret会在文本响应中紧随对应区域/名 词生成框坐标,如"图中有只狗[100, 150, 300, 200]。" Ferret使用预训练的视觉编码器(CLIP-ViT-L/14)(Radford et al., 2021)对图像进行编码,并将图像特征作为额外的令牌与文本输入(以及混合区域表示,如果存在)一起输入到解码 器语言模型(Vicuna,(Zheng et al., 2023))中。训练分为图像-描述对对齐和指令微调两个阶 段,通过下一个词预测损失进行更新。 尽管Ferret表现出灵活性和卓越性能,但其预训练编码器固定的分辨率限制了它充分利用增 强的区域指代和定位精度的能力。为此,我们首先探索最有效的高分辨率扩展方法。随后, 我们推出了Ferret-v2,这是Ferret系列的大幅扩展,旨在研究更广泛和包容的多模态学习框架。

2

Analysis of Higher Resolution Scaling

为了深入分析,我们进行了一系列控制实验,使用不同的高分辨率缩放方法,即"直接上采 样"和"任意分辨率"(Liu et al., 2024)。整体架构和训练过程遵循Ferret(You et al., 2023)的设 计,但对线性层进行了简单的修改,改为两层多层感知器(MLP)。此外,为了使模型更好 地处理简短答案并执行更多基准测试,我们遵循LLA VA 1.5(Liu et al., 2023b)的做法,向 现有的GRIT(You et al., 2023)添加了VQA(Antol et al., 2015)和OCR的任务导向数据集。我 们选择四个代表性的任务:ROC(LVIS:框)、REC(RefCOCOg)、TextVQA和Ferret-Bench, 全面评估训练模型的能力。

直接上采样 vs. 任意分辨率。 为了实验的统一性,我们标准化目标分辨率为4482,将两 种方法的视觉编码器的预训练分辨率(336)进行上采样,确保输入到LLMs的图像令牌相 同。在"直接上采样"中,应用了位置嵌入插值,并在微调阶段调整CLIP编码器到这个新分辨 率。对于"任意分辨率",我们预定义了一组分辨率,支持最多六个网格3。对于给定的图像, 我们首先选择最佳分辨率,优先考虑尽可能接近原始图像的宽高比和大小,同时最小化分 辨率浪费,然后将图像调整到最优分辨率并将其分割成这些网格。所有图像块由CLIP编码 器单独编码,其特征作为图像令牌输入到LLMs。我们使用冻结和不冻结编码器配置训练模 型。

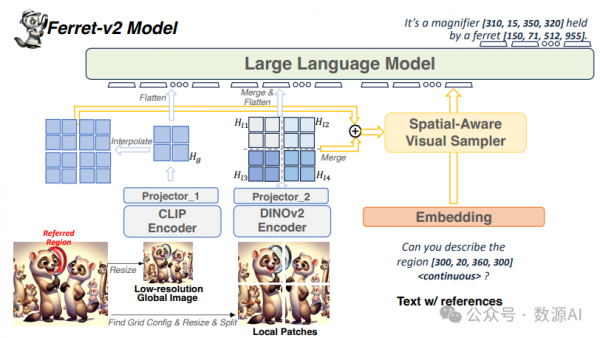

图 3: 提出的 Ferret-v2 模型架构概述。

如图2所示,我们的对比分析显示,"任意分辨率"方法在所有任务上都显示出显著的改进, 且优于"直接上采样"方法。另一个有趣的观察是,在"任意分辨率"中,更新视觉编码器始终 会带来提升,而在"直接上采样"中,冻结视觉编码器有时甚至更好(如TextVQA的结果所 示)。对于这些发现的原因,我们推测"直接上采样"迫使ViT适应更高的分辨率,导致令牌 长度显著偏离其预训练数据。然而,微调数据的规模通常远小于视觉编码器的预训练数据 (1.3M vs. 400M在我们的设置中),这干扰了其预训练知识。相反,"任意分辨率"将高分辨 率图像切割成小块,视觉编码器处理局部区域的方式与预训练过程中的令牌长度相似。总 的来说,"任意分辨率"被证明是一种更优的策略,它在利用高分辨率图像和保留有价值的预 训练知识之间找到了平衡,以实现有效的扩展。

3

Model Architecture

多尺度视觉编码。 在探讨了“任意分辨率”缩放方法后,一个自然的问题出现了:全局低 分辨率图像 Ig 与局部分割图像块 之间存在粒度差异。具体来说,全局图像 Ig 虽然能看到整个场景,但分辨率较低,而每个局部区域 Ili 只能看到场景的一部分,但细 节精确。

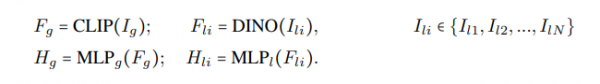

为解决这个问题,我们选择使用不同的视觉编码器来处理这两种类型的图像。具体来说,我 们使用 CLIP (Radford et al., 2021) 对全局图像进行编码,使用 DINOv2 (Oquab et al., 2023) 对 局部分割的图像块进行编码。这样做的动机源于它们预训练范式的差异。CLIP中使用的图 像-文本对比目标使得模型能够从描述中捕捉图像级别的语义,但可能忽视了丰富的像素级 细节,因为引导描述中的细粒度信息有限。DINOv2 通过图像级别和像素级别自监督目标的 训练,能够捕捉到更关于局部物体如形状或纹理的详细信息,因此具有精细感知能力。此 外,我们为双视觉编码器配备了单独的多层感知器投影器,旨在区分并学习全局和精细视 觉信息的多样化上下文:

图 4: 模型训练范式。模型采用"粗到细"(coarse-to-fine)的方式进行训练。‘snowflake‘表示 该模块被冻结。

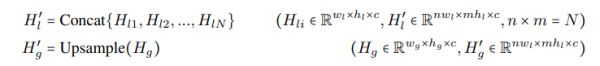

接着,将局部区域特征图按照原始排列合并成一个大的特征图,然后展平为图像特征序列。 全局图像的特征图也展平。这两个序列连接起来,作为视觉“令牌”输入到大型语言模型 (LLM)中。

多分辨率引用处理 Ferret中引入的混合区域表示在处理点、框、涂鸦等各种类型的引用 时表现出有效性与灵活性。其核心在于连续区域特征的提取,这由空间感知视觉采样器完 成。然而,直接将全局图像特征输入视觉采样器可能不足以识别高分辨率图像中的小目标。 鉴于我们之前关于视觉粒度差异的发现,我们进一步提出结合全局语义和局部细节的优势, 以实现更精确的引用。具体来说,获取全局图像Hg和局部区域特征的编 码特征后,我们首先按照它们原有的空间布局将局部区域特征图合并成一个大的特征图, 同时通过插值将全局图像特征图上采样,以匹配合并特征图的大小。

接着,我们通过逐通道相加的方式融合处理后的特征图:Ha = H′ l + H′ g,从而得到一个具 有强语义和局部感知的高分辨率特征图。Ha被输入到一个空间感知的视觉采样器(You et al. (2023))中,以提取连续区域特征。然后,我们将连续特征与离散坐标结合,形成混合区域 表示,以便引用图像中的任何区域,如图3所示。

任意分辨率定位。 通过结合全局图像和局部子区域的视觉嵌入,我们的模型能够更有效 地揭示高分辨率的视觉细节,并弥合语义鸿沟。无需特殊适应,我们的框架与Ferret中的定 位设计无缝对接;因此,同样地,我们通过直观的数值表示来划定输出坐标区域,并利用大 型语言模型作为解读内在关联的主要机制。

4

Training Paradigm

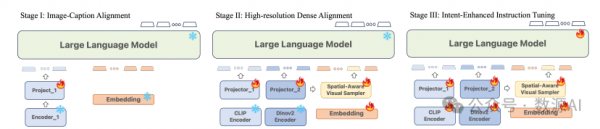

第一阶段:图像-描述对齐。在微调前进行特征对齐是一种广泛采用的方法,以提高训练效 率。我们采用此策略将预训练的CLIP编码器与语言模型(LLM)连接,使用了140万张图像文本对,这些对由 Chen et al. (2023c)转换为指令跟随数据。图像编码器和LLM参数保持冻 结,只有投影器可训练。在这些无引用的图像-文本对中,视觉采样器不参与第一阶段的训 练。

阶段 II:高分辨率密集对齐。 尽管先前的图像-标题对齐在粗粒度语义上有效地连接了视 觉和语言模型,但在图像-标题对齐与指令调优阶段之间仍然存在严重差距。许多下游任务, 如指代、定位、OCR等,需要对图像的更精确和全面的空间感知,而不仅仅是粗粒度语义。 为了解决上述问题,我们提出了一种针对高分辨率密集对齐的预训练阶段。具体来说,这 个阶段不是将整个图像与全局标题对齐,而是将图像中的每个可能的局部物体与详细语义对齐。相应地,设计了两种任务和输入数据:(1) 密集指代:给定图像,输入问题逐个引用 所有物体的区域,并询问它们的类别;模型需要输出相应的预测类别。例如:"问题:请对以 下位置的物体进行分类。1:?region_1?,2:?region_2?,... 答案:这些类别的物体是:1:猫, 2:狗,..."。(2) 密集检测:给定图像,输入问题要求定位所有物体。为了减少随机性并融 入空间意识,我们让答案按照一定的顺序列出物体,如从上到下、从左到右的扫描顺序。例 如:"问题:请按照扫描顺序在图像中定位可见的物体。答案:物体是:1:猫?coordinate_1?, 2:狗?coordinate_2?,..."。为了确保对细粒度语义的高效学习,我们从密集标注的物体数据 集LVIS (Gupta et al., 2019)中收集数据。平均而言,每个样本包含大约10个物体位置,而在 指令调优阶段,指代和定位数据集每样本通常只提及一个或两个物体位置。

在模型方面,我们采用预训练的DINOv2作为局部区域的视觉编码器,以及与Sec. 3.3中所述 的CLIP编码器一起处理全局图像。CLIP编码器后的投影器继承自图像-标题对齐阶段,我们 进一步添加了一个独立的投影器,其权重初始化自CLIP的投影器以保证稳定性。然后,我 们冻结两个视觉编码器和语言模型,仅在这个对齐阶段更新两个投影器和视觉采样器,使 用下一个词预测损失进行训练。

阶段 III:意图增强的指令调优。 经过第二阶段的预训练后,模型具备了对图像的全面全 局理解能力,同时具备了使用自由文本和灵活引用的区域来识别和描述感兴趣物体的能力。 我们的目标是增强模型对用户指令的遵从性,同时保持其高分辨率的视觉感知能力。为此, 我们使编码器、投影器、区域采样器和语言模型本身变得可训练。在训练过程中,我们使 用GRIT数据集(You et al., 2023),并结合LLaVA 1.5 (Liu et al., 2023b)中的VQA (Antol et al., 2015)和OCR (Singh et al., 2019; Sidorov et al., 2020)任务特定数据集。此外,我们发现 了两个有助于提高性能的额外策略:(i) 数据统一:为了帮助模型从基于纯文本的全局理解 无缝过渡到利用混合表示的区域理解,我们使用开放词汇物体检测器GLIPv2 (Zhang et al., 2022a)在VQA数据集中定位可定位的名词,使用公开的OCR模型(Kuang et al., 2021)在OCR数 据集中获取文本边界框。(ii) 任务泛化:为了减少需要指代和定位能力的任务与不需要这些 能力的任务之间的模糊性,我们采用了与LLaVA 1.5类似的方法,即在提示后面添加"包括每 个提及物体的坐标。",以进一步明确任务要求。

实验与结果

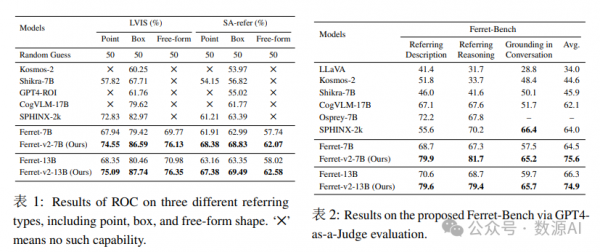

Ferret-v2在理解引用查询方面的提升体现在它能准确地解析图像中指定区域的 语义。这主要通过指代对象分类(ROC)任务来评估,模型需要识别查询中提到的图像区域 中的对象。起初,我们像Ferret一样,使用LVIS数据集的验证集,该数据集包含超过1000个 物体类别,大部分是“领域内”图像。为了进一步展示Ferret-v2在引用较小物体方面的能力 提升,我们使用SA-1B (Kirillov et al., 2023)的部分图像和AS-human (Wang et al., 2023b)的 人类注释编译了一个“野外”评估集,其中包含高分辨率图像、开放词汇对象和精确掩码。 我们总共手动验证了700多个野外物体的高质量样本,称为SA-refer。如表 1所示,Ferretv2在LVIS上显著优于先前的模型,并设立了Ferret之前未能完全实现的新基准,这主要归功 于高分辨率的扩展。尽管SPHINX也使用高分辨率输入图像,但在SA-refer的更具挑战性的 任务上,Ferret-v2仍然胜出,表明了我们特殊设计对任何分辨率指代查询的优势。

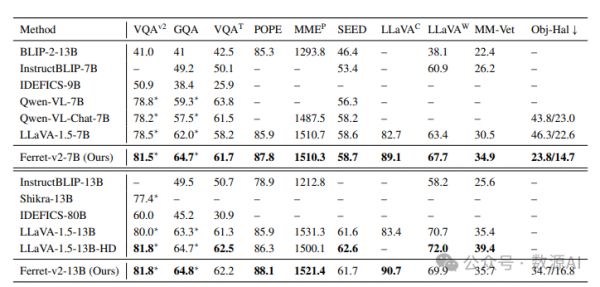

与当前最先进的方法(SoTA)在10个基准上的比较

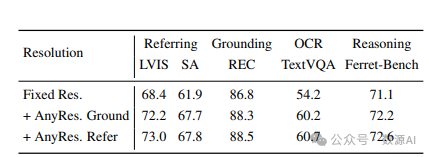

Ablation study on any resolution grounding and referring.

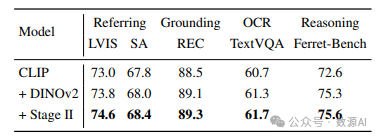

Ablation study on the effectiveness of the multi-granularity visual encoding and Stage II Pretraining

好文章,需要你的鼓励