我们花了1000亿美金,却离AGI越来越远了?

01

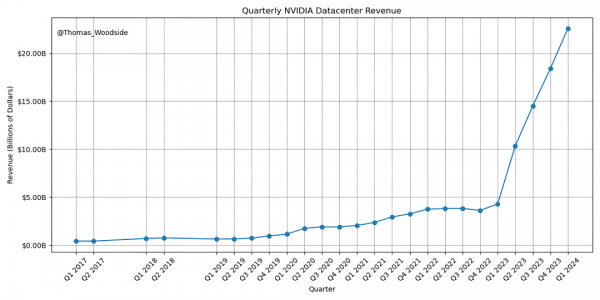

在AI界,对于如何进一步推动AI的发展,存在两种主要观点。第一种观点认为,计算能力是AI进步的唯一瓶颈。这群人相信,只要我们不断增加计算资源的投入,就能不断提升AI的性能,甚至最终实现AGI(通用人工智能)。简单来说,就是有钱能使AI推磨。就像建造一座高楼大厦,只要有足够的钢筋水泥(计算能力),楼一定可以盖得越来越高。

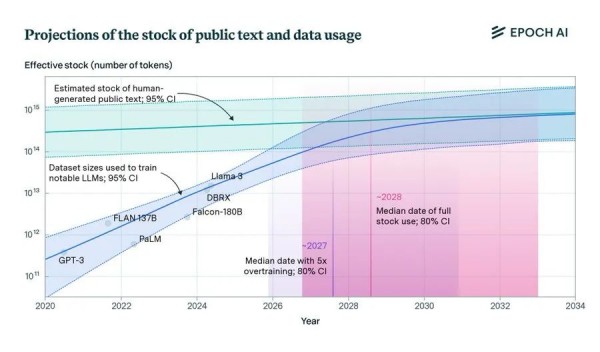

然而,另一种观点却认为,数据才是关键。他们认为我们正面临一个“数据墙”的瓶颈,无论我们拥有多少计算能力,如果没有足够的数据,AI的进展都会放缓。数据墙的存在让人们意识到,仅靠增加计算能力,已经不能带来显著的性能提升。我们必须同时扩展数据量,才能看到更好的结果。

那么,数据墙到底是什么呢?其实,数据墙就像是我们在玩一个游戏,不管你多厉害,如果没有新的关卡和资源,你就会停滞不前。AI也是一样,再多的计算能力,如果没有足够的新数据来训练,效果也会大打折扣。

02

突破数据墙的可能方法

面对数据墙,业界提出了几种潜在的解决方案,希望能够突破这个瓶颈:

首先是高端专家数据。这些数据比普通互联网数据更有价值,就像有经验的老师给你指点迷津,效率自然高很多。高端专家数据通常来自于专业领域的权威和前沿研究,能提供深度和广度兼备的信息。

其次是强化学习(RL)环境。在这种环境下,AI可以通过模拟和自我学习,不断生成新的数据。这类似于AI在一个虚拟世界中自我修炼,积累经验。例如,在一个虚拟驾驶环境中,AI可以无限次地模拟驾驶场景,从而不断优化自己的驾驶技能。

最后是合成数据。这是一种通过算法生成的数据,能够弥补实际数据的不足。就像电影中的特效,虽然是虚拟的,但看起来同样真实。合成数据可以模拟各种复杂场景和条件,帮助AI模型进行全面训练。

这些方法看起来很有前途,但能否真正突破数据墙仍是未知数。有些专家认为,数据墙只是暂时的技术障碍,可以通过工程设计来解决;另一些人则担心这会导致AI发展的长期停滞。我们可以把数据墙看作是马拉松比赛中的“极点”,有人认为熬过去就行,有人则认为可能跑不完。

分散的资源与未来的不确定性

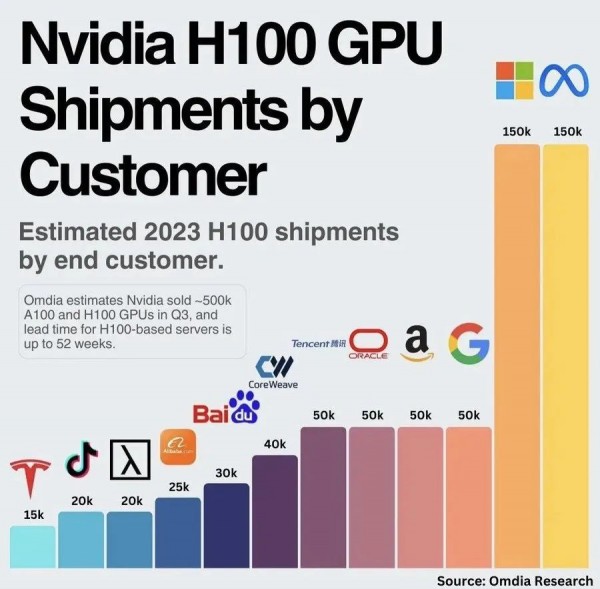

除了数据和计算能力的挑战,还有一个实际问题是:资源的分配。1000亿美元的GPU投入其实是分散在多个实验室中。像谷歌、OpenAI、Meta、Anthropic等大型实验室,各自占有的资源都不超过总供应量的10-20%。

这意味着,即使某个实验室投入巨资,也很难在短时间内看到单个模型上的巨大突破。这就像是几支足球队分散训练,每支队伍的资源有限,难以形成绝对的优势。

未来的进展或许还依赖于新的算法突破,能够超越当前的缩放定律范式。这也意味着,我们可能需要更大规模的投资,比如5000亿美元,才能真正看到AI的显著进步。

写在最后的话

AI的未来充满了不确定性,计算和数据的挑战依然存在。尽管如此,人工智能毫无疑问将继续改变我们的生活,成为人类历史上最伟大的项目之一。

你怎么看待这些挑战和未来的AI发展?欢迎在评论区分享你的观点,并转发这篇文章,让更多人一起探讨AI的未来吧!

好文章,需要你的鼓励

让自动驾驶AI学会“聚焦重点“,速度提升7倍却更加安全

来自北京大学多媒体信息处理国家重点实验室和小鹏汽车的研究团队发布了一项重要研究成果,提出了一种名为FastDriveVLA的创新框架,让自动驾驶AI能够像人类司机一样,学会在纷繁复杂的道路场景中快速识别并聚焦于真正重要的视觉信息。

清华团队让机器学会“透视眼“:用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

TechCrunch年度创业战场大赛从数千份申请中筛选出200强,其中20强进入决赛角逐10万美元大奖。本次消费科技和教育科技领域共有26家公司入选,涵盖无障碍出行、AI视频制作、服装租赁、护肤推荐、纹身预约等创新应用,以及AI语言学习、个性化数学教育、职场沟通培训等教育科技解决方案,展现了科技创新在日常生活和教育领域的广泛应用前景。

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。