一颗192核的Arm服务器CPU

2024 年初,我们当前一代云原生处理器系列看起来是这样的,AMD EPYC Bergamo 和 Ampere Altra Max 有两个 128 核选项。

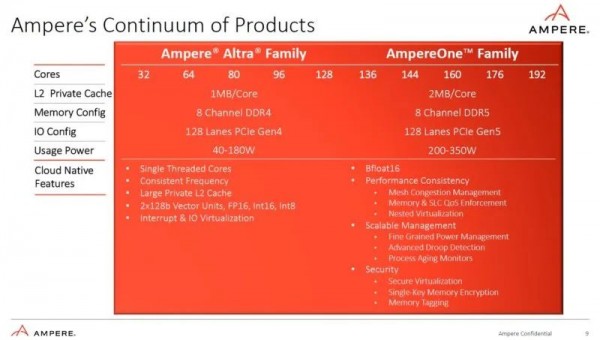

今年早些时候,我们发布了“云原生高效计算是 2024 年及以后的发展方向”的文章。我们在那里预览了 Ampere AmpereOne CPU,但我们还没有在静态演示之外看到它。AmpereOne 是一件大事。

首先,它是 Ampere 的定制核心,而不是像 Altra 系列那样的授权 Neoverse 核心。AmpereOne 上还有一些重要的新功能,例如嵌套虚拟化等,而这些功能在 Altra/Altra Max 系列上根本没有。最后,该平台采用 DDR5 和 PCIe Gen5,更加现代化。

到 2024 年初,我们当前一代云原生处理器系列看起来是这样的,AMD EPYC Bergamo 和 Ampere Altra Max 有两个 128 核选项。

现在我们可以将其视为当前一代云原生处理器。我们添加了 AMD EPYC Siena,因为有人可能会说,作为 Zen 4c CPU 并且专为低功耗单插槽应用而设计,尽管只能扩展到 64 个内核,但它可能适合许多用例。我们仍然拥有 AMD EPYC 9754 Bergamo 部件,因为 Turin-Dense 要到第四季度才会推出。我们现在拥有 AmpereOne 处理器以及 Intel Xeon 6700E Sierra Forest 系列。

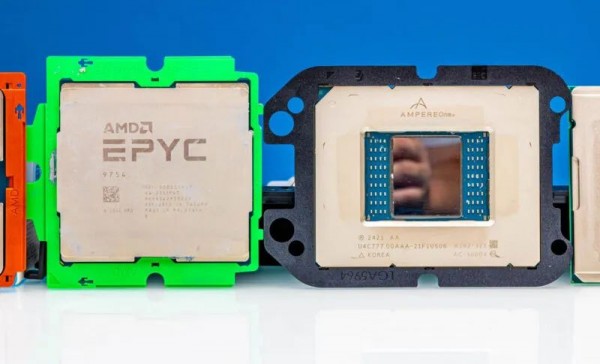

凭借 192 个基于 Arm 的定制核心,我们可以看出 AmpereOne 的规模与 AMD EPYC SP5 处理器相当,并且比 SP3 和 SP6 CPU 大得多。与 AMD 的 SP6 平台相比,Ampere 的引脚数更接近 SP5 平台。

Ampere 的 CPU 周围还有一个载体导向框架。这有助于芯片完美地装入 LGA5964 插槽,我们将在下一页展示这一点。

虽然许多人会将其与当前的 Intel Xeon 6700E 系列(如Intel Xeon 6780E)进行比较,但目前这些比较有点奇怪。Ampere 有 192 个内核,在 SPECrate2017_int_base 上的性能与 Ampere 大致相同,但使用了 144 个内核。Ampere 部件的价格仅为其标价的一半左右。在功率方面,Ampere 具有更高的 TDP,但实际使用功率略有不同。

鉴于我们知道这是英特尔的小型 Xeon 6 解决方案,而不是该公司即将推出的 288 核 Sierra Forest,那么英特尔芯片真的是 AmpereOne 的竞争对手吗?也许吧。基准测试仍在运行,但对于那些认为没有竞争的人来说,现在采取这种立场是愚蠢的。

我们将在完整的评论中更深入地讨论这个问题,但现在,让我们来谈谈许多人可能想知道的问题:AmpereOne 封装是怎么回事?

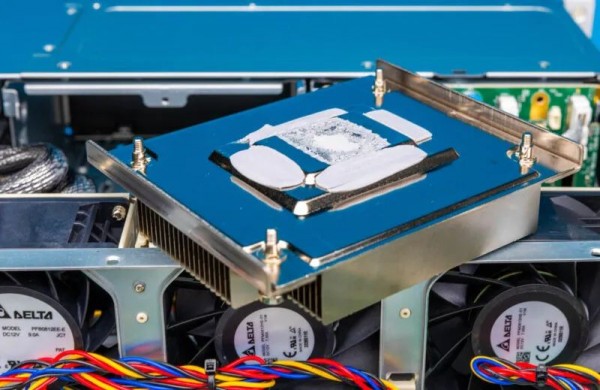

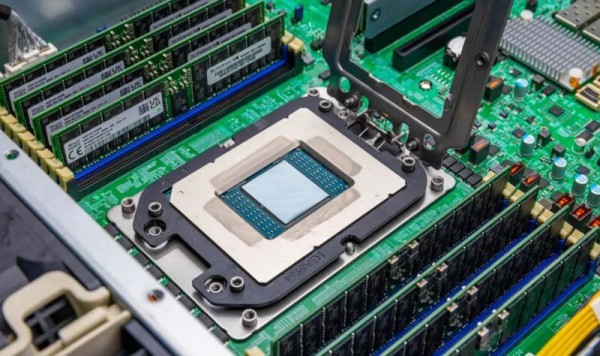

当我们将散热器从 Supermicro 测试系统上拆下来时,我们看到了这样的景象。在上面的照片中,你可以看到我在主计算芯片的反射下拍照。该芯片实际上是用于计算核心的。

查看我们拆下散热器时拍摄的照片,可以更清楚地了解发生了什么。主计算芯片没有传统的散热器。侧面的内存 I/O 芯片以及 PCIe I/O 芯片均使用围绕主计算芯片的散热器。

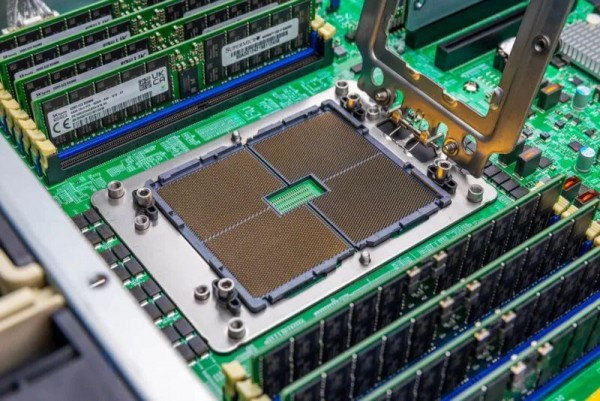

因此,我们的散热器有四块导热膏和三个不同的高度(两块用于接触 CPU)。这里没有统一的应用。在没有散热器的情况下涂抹导热膏和冷却器总是有点可怕,正如我们在 2018 年安装 NVIDIA P100 时学到的那样。这远没有 CoWoS 安装那么可怕,但没有一个大的统一的散热器仍然有点可怕。有趣的是,AmpereOne A192-32X 的 TDP 为 400W,而 NVIDIA P100 SXM2 模块的 TDP 只有 300W。现代低功耗云原生 CPU 现在处于 2018 年 NVIDIA V100 32GB GPU 的范围内,这是一个有趣的想法。

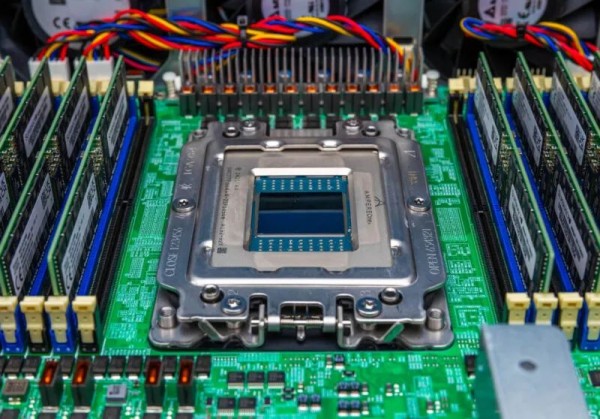

接下来,我们将花点时间看看 AmpereOne 的socket,因为很多人可能想知道它是如何安装的。

在我们拆下 1U 散热器并擦掉导热膏后,我们可以看到这一点。如果你环顾散热器下方的边缘,你可以看到 PCIe 和内存 I/O 芯片。我们没有拆下散热器,因为我们需要系统工作,而且我不想告诉 Ampere 的人我们拆开了 CPU 样品来看看下面是什么。

这是另一个角度,我们可以看到 LGA5964 sokcet。该socket通过六个 T20 螺钉固定。

一旦这些被释放,我们就可以看到载体的用途。黑色载体使用四个导针将芯片定位在插槽中。虽然芯片很大,但安装并不难,除了安装导热膏和散热器有点吓人。与安装 Altra Max 相比,该插槽是一个巨大的升级,它既不使用像 AMD CPU(或旧 HP/HPE Intel Xeons)这样的载体,也不使用像现代 Intel Xeons 这样的基于冷却器的载体解决方案。这感觉更像 AMD EPYC,但明显不同。

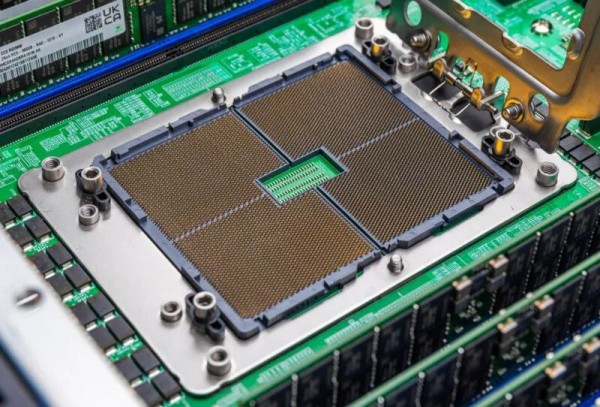

至于socket,这里是 LGA5964 针脚阵列。

这是近距离拍摄的照片。右上方固定框架上的金色实际上是摄影棚灯光从针阵列反射出来的。

当然,拍完照片后,就该看看系统是否还能正常工作,或者我是否要与安培进行一次不愉快的谈话。

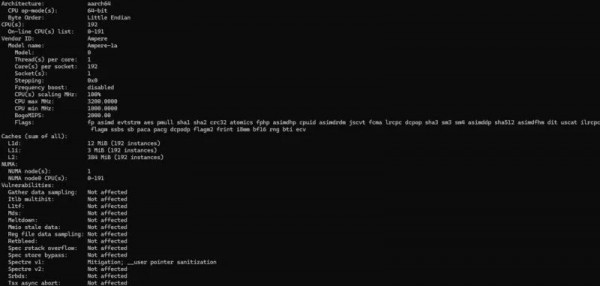

幸运的是,如今,与 2016 年我们首次尝试Cavium ThunderX Ubuntu 安装时没有出现问题不同。令人惊讶的是,在 Ubuntu 16.04 之前的版本中,Arm 服务器 CPU 运行起来非常困难,而在 Ubuntu 16.04 之后,一切都可以运行,但您仍在编译许多基本工具,而今天,尤其是在云堆栈(例如 Web 服务器)上,运行起来实际上与 x86 端相同。

由于我们为了拍照而拆下散热器,因此我们进行了 12 小时的压力测试以确保没有损坏任何东西。

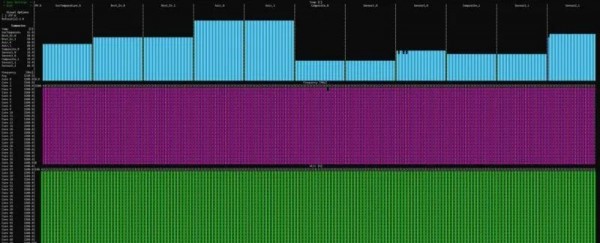

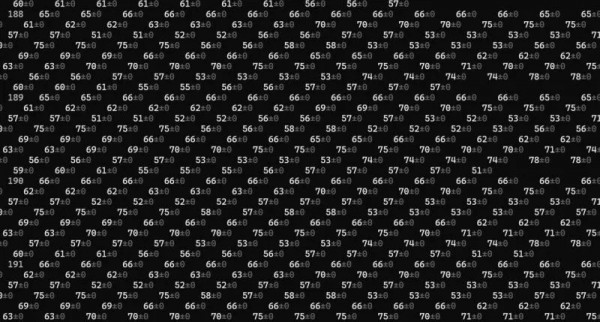

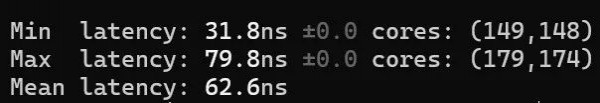

快速安装 Rust(同样简单)并且我们开始测试 192 核阵列中的核心到核心延迟。

结果实际上相当不错。我们将在完整评论中提供颜色图表,但以下是我们看到的情况:

在本篇文章发布前几分钟,系统刚刚完成压力测试。今天,它将进入主测试机架设置,并开始基准测试运行,因此您可能很快就会看到一些结果,例如这个有趣的结果,它比我们的 NVIDIA GH200 结果略高(未添加到公共数据集,但更接近 75K)。

总的来说,从去年 5 月第一次亲眼看到 AmpereOne到拆开一个系统并在实验室中运行它,这真是太棒了。与2020 年首次使用最初的 Ampere Altra时相比,我们现在拥有的所谓“云原生”处理器的格局截然不同。急于提供更低的每核功率但更多的核是现实,我们现在拥有 AMD、Ampere/Arm 和 Intel 版本。

希望这篇文章能让您快速、有趣地了解 AmpereOne A192-32X CPU、LGA5964 插槽以及这些 CPU 的冷却工作原理。

https://www.servethehome.com/this-is-ampere-ampereone-a192-32x-a-192-core-arm-server-cpu-arm/2/

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

联想此次推出的推理加速引擎(Inference Acceleration Engine),是联想携手清华大学无问芯穹团队联合打造的本地AI加速解决方案。这款引擎将预装在联想年底发布的新一代AI PC产品线中,目标是让端侧推理性能直接看齐云端大模型水平。

香港中文大学等顶尖院校联合研究发现,当前最先进的AI视频生成技术已能制作出连顶级检测系统都无法识别的假视频。研究团队开发了Video Reality Test平台,测试结果显示最强生成模型Veo3.1-Fast的假视频仅有12.54%被识别,而最强检测系统Gemini 2.5-Pro准确率仅56%,远低于人类专家的81.25%。研究还发现检测系统过度依赖水印等表面特征,音频信息能提升检测准确性,但技术发展已对信息真实性判断带来严峻挑战。

Meta超级智能实验室推出的SAM 3D模型,通过创新的"模型在环"数据标注流程和多阶段训练策略,成功实现从单张图像重建完整3D物体的能力。该研究打破了3D领域的数据壁垒,在真实世界场景中展现出远超现有方法的性能,为机器人、AR/VR、游戏制作等应用开启新可能。

Google DeepMind团队提出了革命性的"扩散预览"模式,通过ConsistencySolver技术实现AI图像生成的"预览+精修"工作流程。该技术能在5-10步内生成高质量预览图像,与传统40步完整生成保持高度一致性,用户体验测试显示总体时间节省近50%,大大提高了创作效率和创意探索的自由度。