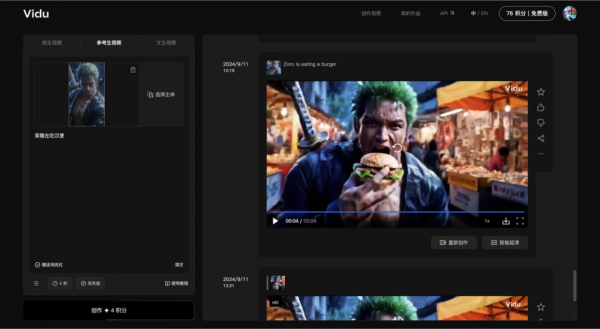

国产AI视频重大突破!角色一致性,Vidu率先做到了

一觉起来,AI视频又双叕要变天了

之前一直困扰各位创作者的“人物一致性问题”,突然迎来了转机。

话不多说,我们先看效果

“一致性”要重点解决的,就是AI生成影视里的IP问题。

“毕竟没有观众想看自己喜欢的电影主角频频换脸吧”

而这一旦被解决,AI创作短剧、电影、绘本、广告等等等等方面的应用都将会有质的飞跃。

比如这里一个广告片的例子

可能上传的商品图片背景、角度都和要做的广告片不相干,但却能生成一些你想要的“高级”效果。

之前想生成同一人物在不同场景的分镜,通常会先用AI绘画的垫图(通常用Midjourney或者sd),或者局部重绘等方法先生成满意的画面,再通过另外的AI视频软件生成动态视频。

操作麻烦不说,保不齐垫图出来不像,还得加一层AI换脸。。。

而现在,只需上传一张参考图就搞定了,何不快哉!

官方的视频合集上面看了,这里我放点自己实测的效果。

先来个索大试试,我用Midjourney生成了个3D版的,有喜欢的朋友可以后台私信多送你几张。

提示词:索隆吃汉堡

“这标志性绿藻头、胸口上的疤痕、佩刀...”

还原的有点到位!

就是这画质堪忧,Vidu啥时候给提升下。

最近正好在看咒术回战,索性再来个五条悟,也不知道后面复活了没,这次专门找了个2D动漫版的看看效果。

提示词:五条悟在看书

这画风,有一说一确实匹配的让我有些喜出望外,不过同样有点小瑕疵,动作连贯性有待进一步加强,另外,旁边这位女士是...

难道直接预测了五条老师的女友?

不过以上对于一致性问题来说都小问题,等待官方下一版本的优化了,你也可以立即在官网免费体验:https://www.vidu.studio/

日本的网友也玩得飞起,果然一上来就是小姐姐

依稀记得半年前AI生成视频另一大Bug“4秒动态PPT效果,运动幅度太小”是咱国产的可灵AI率先开放给大家使用的,这次,是生数科技的Vidu。

而“角色一致性”这一功能,除了同样是我们国内的AI视频生成产品Pixverse有尝试,在Runway和其他软件还暂未看到。

乔老爷子曾经说过:“创新区分领袖和跟随者。”

也许之前,在AI生成视频方面,我们国内的AI厂家普遍都在扮演跟随者的角色。但这一次,不论是可灵AI、Pixverse 的大胆创新,还是Vidu的技术突破,国内的AI技术正在从追赶者转型为引领者,在国际舞台占有重要地位。

不但首发即开放给全球用户体验使用,更是在不断创新,探索AI视频领域的未来走向。

我们曾经在追随,但现在,我们正在引领新的变革。

好了,今天就聊到这里。如果你觉得这篇文章有帮助,记得点赞、收藏、分享给朋友们哦!咱们下次见啦!

附:

Vidu官网:https://www.vidu.studio/

可灵AI官网:https://klingai.kuaishou.com/

Pixverse官网:https://pixverse.ai/

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。