英特尔具身智能大小脑融合方案发布:构建具身智能落地新范式

在今日举办的2025英特尔具身智能解决方案推介会上,英特尔正式发布其具身智能大小脑融合方案(下称具身智能方案)。该方案基于英特尔® 酷睿™ Ultra处理器的强大算力,以及全新的具身智能软件开发套件和AI加速框架打造。凭借创新性地模块化设计,其不仅能够兼顾操作精度和智能泛化能力,而且以卓越的性价比满足不同领域需求,为具身智能的规模化、场景化应用落地夯实基础。

英特尔市场营销集团副总裁、中国区OEM & ODM销售事业部总经理郭威表示:“以人形机器人为代表的具身智能行业正迎来前所未有的发展热潮,然而,系统架构的非一致性、解决方案的泛化能力不足、场景适配的复杂性等挑战,正在制约其大规模商业化的进程。基于此,英特尔携手生态伙伴,通过大小脑融合的方式,打造更高效、更智能的解决方案,以基础通用大模型与硬件技术的协同突破,以及开放生态所带来的加速效应,推动具身智能向实践应用场景的迈进。”

英特尔中国边缘计算事业部EIS高级总监 李岩

本次英特尔发布的具身智能方案以大小脑融合为亮点,能够使感知、交互、任务规划和运动控制在统一的系统中实现高效整合。而作为其中的算力中枢,英特尔® 酷睿™ Ultra处理器通过CPU 、集成的英特尔锐炫™ GPU 与 NPU 协同运行,以高性能异构算力和高精度实时性能,支持具身智能的多样化负载稳定运行,同时也大幅提升具身智能系统的整体效率和响应能力。其中,通过CPU 可以支持具身智能方案进行复杂的运动控制,集成的英特尔锐炫™ GPU用于具身智能处理环境感知、任务识别、任务规划、大语言模型(LLM)、视觉语言模型(VLM)和端到端模型等复杂任务,NPU 则承载语音识别、实时视觉处理、传感器数据分析等需长时间运行的 AI 任务。

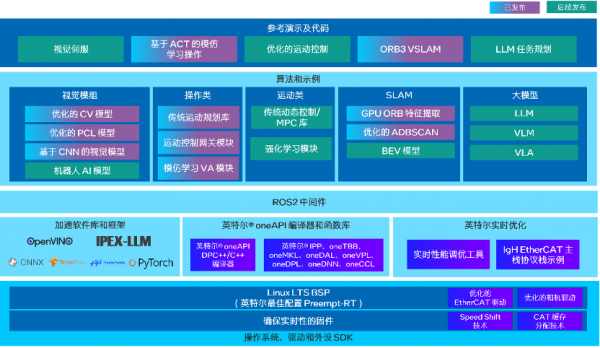

对具身智能解决方案而言,硬件是基础,而软件优化则是提升整体性能和用户体验不可忽视的一环。基于此,英特尔亦推出具身智能软件开发套件,通过包括OpenVINO™ 工具套件、英特尔® oneAPI 工具包、Intel® Extension for PyTorch-LLM(IPEX)、英特尔® 工业边缘控制平台(ECI)、基于开源机器人操作系统的库、中间件和示例应用程序,使代码实现一次开发多平台部署,缩短评估和开发时间,加快客户应用程序的部署以及算法和应用的运行。此外,英特尔亦提供跨平台 AI 模型优化工具以及端到端流程加速方案,以简化方案搭建过程,加快产品上市。

英特尔® 具身智能软件开发套件

在持续推动具身智能软硬件创新的同时,英特尔亦携手本地生态伙伴展开深度合作,探索从技术研发到场景落地的全链路协同模式,构建起协同共进的产业生态格局,为行业发展注入强劲动力。其中,信步科技推出的具身智能硬件开发平台HB03,搭载英特尔® 酷睿™ Ultra 200系列处理器和英特尔锐炫™ B570显卡,能够提供强大且灵活的算力,并实现极强的控制实时性。信步HB03平台通过紧凑结构、扩展接口与工业级可靠性设计,为具身智能“大小脑”融合构建了有力的硬件支撑。同时,浙江人形机器人创新中心也基于英特尔® 酷睿™处理器,打造出“领航者2号NAVIAI”人形机器人,实现了可泛化高精准视觉伺服、多行为联合学习的长序列行为规划、视力融合的操作行为学习等技术突破,能够使其在工业场景中执行复杂任务,也可以在服务场景中完成人机交互和辅助等任务,助力机器人智能化的深度演进,并推动其向更高层次的智慧形态发展。

在具身智能产业迎来“井喷前夜”之时,英特尔具身智能方案凭借大小脑融合架构的创新,带来功耗、成本、算力的平衡,成为构建具身智能系统的理想选择。未来,英特尔也将持续深化技术创新,与生态伙伴拓展其在医疗、教育、养老等关键领域的应用场景,共建开放、协同的具身智能生态体系,使具身智能真正赋能千行百业,为社会的高效运转与可持续发展提供助力。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车

对话伟景智能董霄剑:走一条不同于VLA的路,让人形机器人落地商用

第二届中国人形机器人与具身智能产业大会在京举办,十大典型落地场景发布

傅利叶发布首款开源人形机器人 Fourier N1, 加速行业生态共建

1.9倍性能提升!英特尔至强6在MLPerf基准测试中表现卓越

你敢要它就有!至强6新品治好选择困难症

英特尔李映:我们要如何寻找AI杀手级应用

“码”上出发,“芯”创未来 2025英特尔人工智能创新应用大赛正式启动

英特尔任命陈立武(Lip-Bu Tan)为首席执行官

Google 新型机器人 AI 能够折叠精致的折纸,并能安全关闭拉链袋

成本打到6万以下,手把手教你用4路锐炫显卡+至强W跑DeepSeek