国内唯一,阿里千问斩获NeurIPS 2025最佳论文奖

11月27日,人工智能领域顶级会议NeurIPS 2025公布了论文奖,阿里通义千问团队在注意力机制上的研究成果从全球5524篇论文中脱颖而出,被评为最佳论文,是唯一获得该奖项的中国团队。该论文首次在业内揭秘了注意力门控对大模型性能和训练的影响,据悉,该研究成果已应用于Qwen3-Next模型,并显著提升模型的性能与鲁棒性。

阿里通义千问研究成果被评为NeurIPS 2025最佳论文

门控是大模型应用最广泛的技术之一,它可以作为模型的“智能降噪耳机”,帮助模型过滤无效信息从而提升模型性能。近年来,AlphaFold2、Forgetting Transformer等学术界和工业界模型开始探索将门控和注意力机制结合,但都对门控在注意力机制中有效的原因缺乏探索,也没有大规模实践的经验。

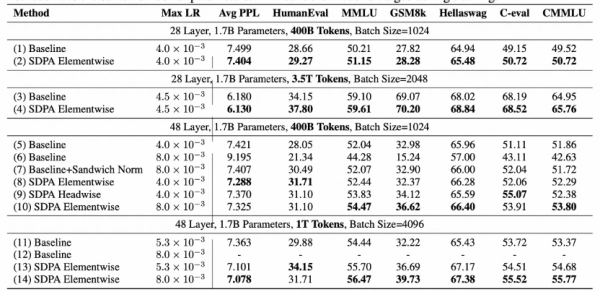

此次,通义千问团队通过在1.7B稠密模型(Dense)与15B混合专家模型(MoE)上训练超过 3.5 万亿 token,并对比 30 余组控制实验,首次清晰揭秘了其背后的原理,并展现了在注意力中使用门控形式最有效的方式及扩展成功实践。

注意力头是注意力机制中的基本计算单元。实验结果显示,对各注意力头的输出进行门控,是提升模型性能最有效的方式。使用该方式,在引入额外1%参数、计算开销增加低于2%的情况下,可以实现0.2以上的困惑度下降、MMLU基准评测2个点的提升。研究还发现,该技术还能在更大规模的模型训练上实现更好的性能。

使用论文方法,在引入额外1%参数、计算开销增加低于2%的情况下,可以实现0.2以上的困惑度下降、MMLU基准评测2个点的提升

更深入的分析发现,注意力门控还解决了大模型长期存在的两大问题:注意力池(Attention Sink),即少量特殊token计算中产生很大的输出值、占据很高的注意力分数;巨量激活(Massive Activation),即模型激活中出现大于中位数数千倍的离群值。上述两个现象都容易在BF16等低精度训练中引发数值误差,影响训练稳定与低精度部署。该研究显示,门控注意力将首token的注意力占比从 46.7%降至4.8%,同时将最大激活值从1053降至94。

目前,该技术方案、实验模型及产品级模型均已开源。NeurIPS评审委员会表示:“我们认为该方法将被广泛采用,这项工作将极大推动社区对大语言模型中注意力机制的理解。”

通义千问团队表示:“对门控机制、模型机制等的深入理解,不仅为大语言模型架构设计提供了新思路,也为构建更稳定、更高效、更可控的大模型奠定了基础。”

据悉,目前阿里千问已开源300多款模型,涵盖全模态、全尺寸,全球下载量突破7亿次,衍生模型超过18万个,位居全球第一。

好文章,需要你的鼓励

超越能源使用:数据中心可持续运营策略

随着AI广泛应用推动数据中心建设热潮,运营商面临可持续发展挑战。2024年底美国已建成或批准1240个数据中心,能耗激增引发争议。除能源问题外,服务器和GPU更新换代产生的电子废物同样严重。通过采用模块化可修复系统、AI驱动资产跟踪、标准化数据清理技术以及与认证ITAD合作伙伴合作,数据中心可实现循环经济模式,在确保数据安全的同时减少环境影响。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

超大规模云数据中心是数字经济的支柱,2026年将继续保持核心地位。AWS、微软、谷歌、Meta、甲骨文和阿里巴巴等主要运营商正积极扩张以满足AI和云服务需求激增,预计2026年资本支出将超过6000亿美元。然而增长受到电力供应、设备交付和当地阻力制约。截至2025年末,全球运营中的超大规模数据中心达1297个,总容量预计在12个季度内翻倍。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

Littelfuse推出适用于电动汽车电池、电机和安全系统的汽车级电流传感器

CES 2026 | 机器人开发的“ChatGPT时刻”已到 老黄定调“物理AI”的路线图

超越能源使用:数据中心可持续运营策略

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手

机器海龟游向环保使命:仿生技术守护珊瑚礁

CES 2026最酷笔记本电脑:可拆卸设计成为新趋势

AMD 在 CES 2026 发布新款锐龙处理器、Ryzen AI 及 AMD ROCm,全面扩展其在客户端、图形和软件领域的 AI 领先地位

AMD发布Instinct GPU新品挑战英伟达数据中心霸主地位