Meta研究人员做出AI新尝试:机器人无需地图或训练实现自主导航

Meta Platforms公司人工智能部门日前表示,他们正在教AI模型如何在少量训练数据支持下学会在物理世界中行走,目前已经取得了快速进展。

这项研究能够显著缩短AI模型获得视觉导航能力的时间。以前,实现这类目标要需要利用大量数据集配合重复“强化学习”才能实现。

Meta AI研究人员表示,这项关于AI视觉导航的探索将给虚拟世界带来重大影响。而项目的基本思路并不复杂:帮助AI像人类那样,单纯通过观察和探索实现在物理空间导航。

Meta AI部门解释道,“比如,如果要让AR眼镜指引我们找到钥匙,就必须想办法帮助AI理解陌生的、不断变化的环境布局。毕竟这是非常细化的小需求,不可能永远依赖于极占算力资源的高精度预置地图。人类不需要了解咖啡桌的确切位置或长度就能不产生任何碰撞、轻松绕着桌角走动。”

为此,Meta决定将精力集中在“具身AI”身上,即通过3D模拟中的交互机制训练AI系统。在这一领域,Meta表示已经建立起一套值得期待的“点目标导航模型”,无需任何地图或GPS传感器即可在新环境中导航。

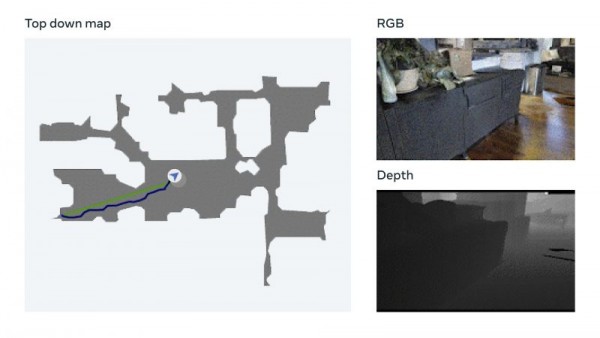

该模型使用一种名为视觉测量的技术,允许AI根据视觉输入跟踪自身当前位置。Meta表示,这项数据增强技术能够快速训练出有效的神经模型,且无需人工数据注释。Meta还提到,他们已经在自家Habitat 2.0具身AI训练平台(利用Realistic PointNav基准任务运行虚拟空间模拟)上完成了测试,成功率达到94%。

Meta方面解释道,“虽然我们的方法还没有完全解决数据集中的所有场景,但这项研究已经初步证明,现实环境的导航能力不一定需要显式映射来实现。”

为了在不依赖地图的情况下进一步完善AI导航训练,Meta建立了一套名为Habitat-Web的训练数据集,其中包含10万多种由人类演示的不同对象-目标导航方法。通过运行在网络浏览器上的Habitat模拟器就能顺利接入Amazon.com的Mechanical Turk服务,用户能够以远程方式安全操作虚拟机器人。Meta表示,由此产生的数据将作为训练素材,帮助AI代理获得“最先进的结果”。扫视房间了解整体空间特点、检查角落是否有障碍物等,都是值得AI向人类学习的高效对象搜索行为。

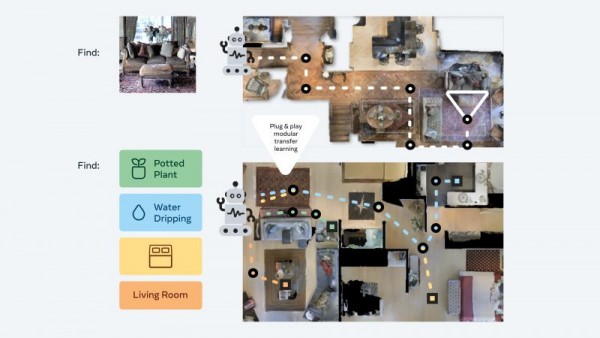

此外,Meta AI团队还开发出所谓“即插即用”模块化方法,可以通过一套独特的“零样本体验学习框架”帮助机器人在多种语义导航任务和目标模式中实现泛化。通过这种方式,AI代理在缺少资源密集型地图和训练的前提下仍可获得基本导航技能,无需额外调整即可在3D环境中执行不同任务。

Meta公司解释道,这些代理在训练中会不断搜索图像目标。它们会收到一张在环境中随机位置拍摄的照片,然后通过自主导航尝试找到拍摄点位。Meta研究人员们表示,“我们的方法将训练数据削减至1/12.5,成功率则比最新的迁移学习技术还高出14%。”

Constellation Research公司分析师Holger Mueller在采访中表示,Meta的这项最新进展有望在其元宇宙发展计划中发挥关键作用。他认为,如果未来虚拟世界能够成为常态,那AI必须有能力理解这个新空间,而且理解的成本还不能太高。

Mueller补充道,“AI理解物理世界的能力需要由基于软件的方法获得扩展。Meta目前走的就是这条路,而且在具身AI方面取得了进步,开发出无需训练即可自主理解周边环境的软件。我很期待看到这方面成果在实践层面的早期应用。”

这些现实用例可能已经离我们不远了。Meta公司表示,下一步计划就是把这些成果从导航推进到移动操作,开发出能够执行特定任务的AI代理(比如识别出钱包并将其交还给主人)。

好文章,需要你的鼓励

Cyera获得4亿美元融资专攻AI数据安全,估值达90亿美元

人工智能和数据安全公司Cyera宣布完成4亿美元后期融资,估值达90亿美元。此轮F轮融资由贝莱德领投,距离上次融资仅6个月。随着95%的美国企业使用生成式AI,AI应用快速普及带来新的安全挑战。Cyera将数据安全态势管理、数据丢失防护和身份管理整合为单一平台,今年推出AI Guardian扩展AI安全功能。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

SAP推出全新AI功能助力零售业数字化转型

SAP在2026年全国零售联盟大展上发布了一系列新的人工智能功能,将规划、运营、履约和商务更紧密地集成到其零售软件组合中。这些更新旨在帮助零售商管理日益复杂的运营,应对客户参与向AI驱动发现和自动化决策的转变。新功能涵盖数据分析、商品销售、促销、客户参与和订单管理等领域,大部分功能计划在2026年上半年推出。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SAP推出全新AI功能助力零售业数字化转型

Gmail推出个性化AI收件箱与智能搜索等多项新功能

CISA警告HPE OneView和微软Office漏洞正被活跃利用

谷歌削减Android开源代码发布频率至每年两次

高通CES 2026:扩展IE-IoT产品组合推进边缘AI发展

恩智浦发布S32N7处理器系列,加速AI驱动汽车发展

n8n自动化平台严重漏洞可让攻击者完全控制服务器

微软将在Copilot中直接集成购买按钮功能

Snowflake收购Observe拓展AI驱动监控能力

丰田升级SUV产品线,RAV4新增信息娱乐系统

可信开源软件现状报告:AI重塑技术栈基线

思科修复ISE安全漏洞,公开概念验证代码已发布