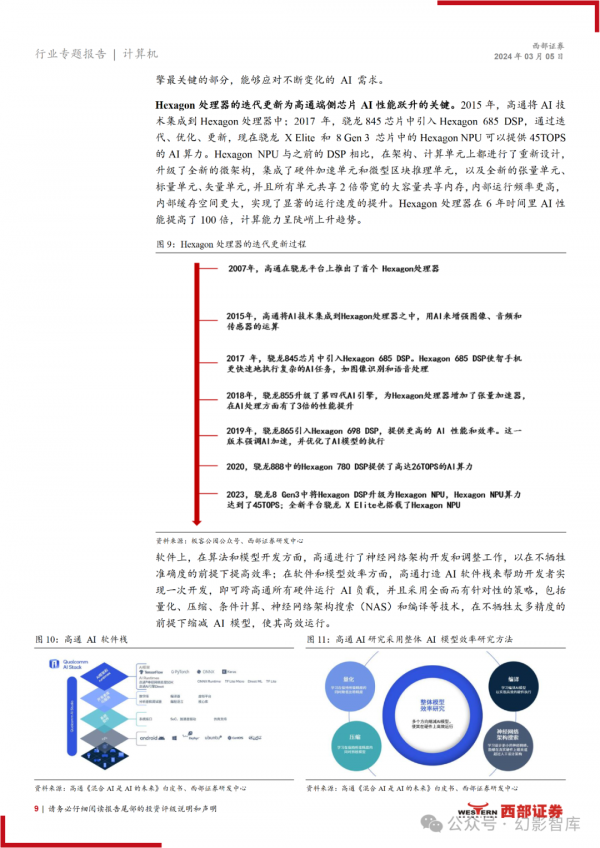

AI终端智能:人工智能AI的新革命

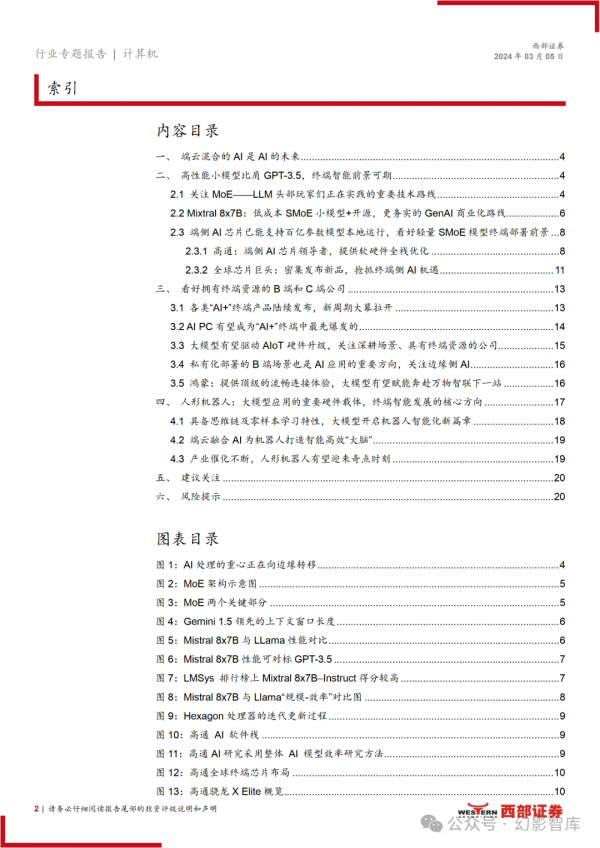

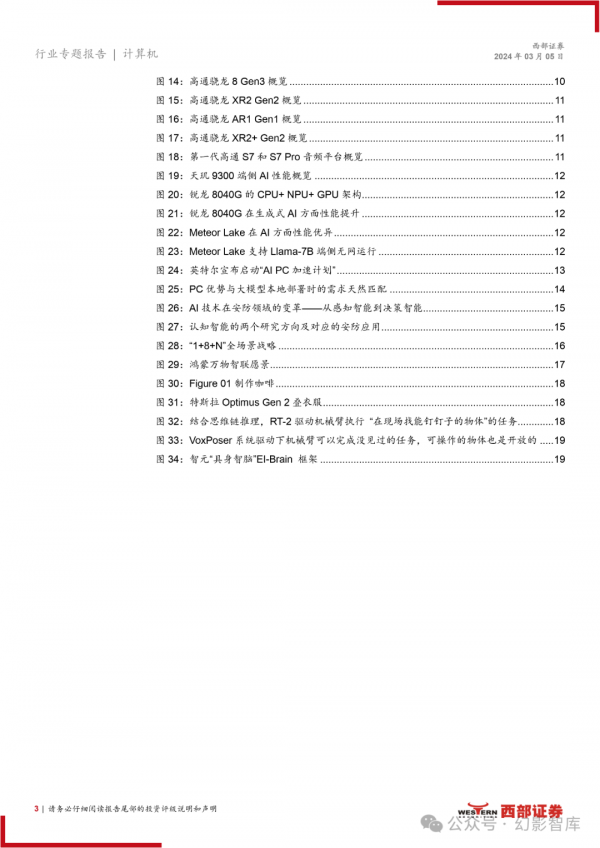

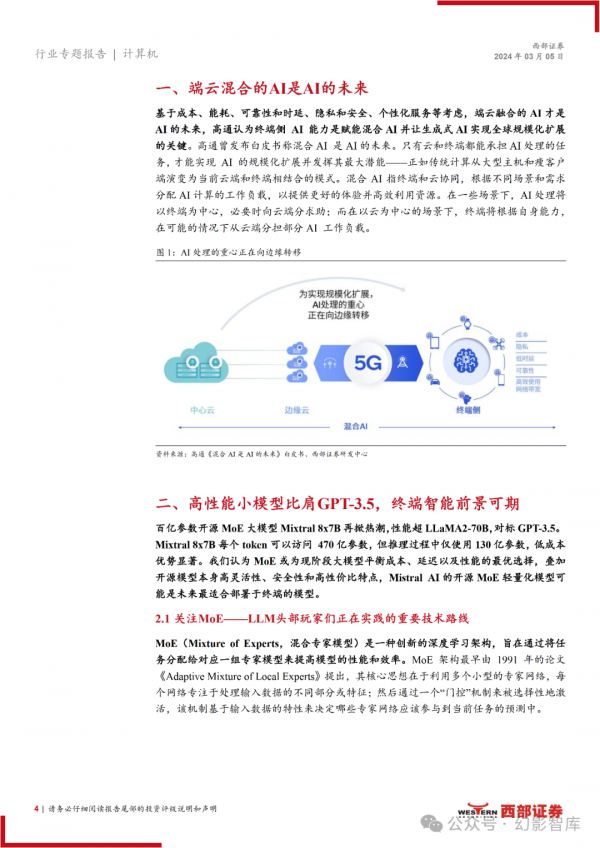

基于成本、能耗、可靠性和时延、隐私、个性化服务等考虑,端云混合的 AI 才是 AI 的未来,高通认为终端 AI 能力是赋能混合 AI 并让生成式 AI 实现全 球规模化扩展的关键。

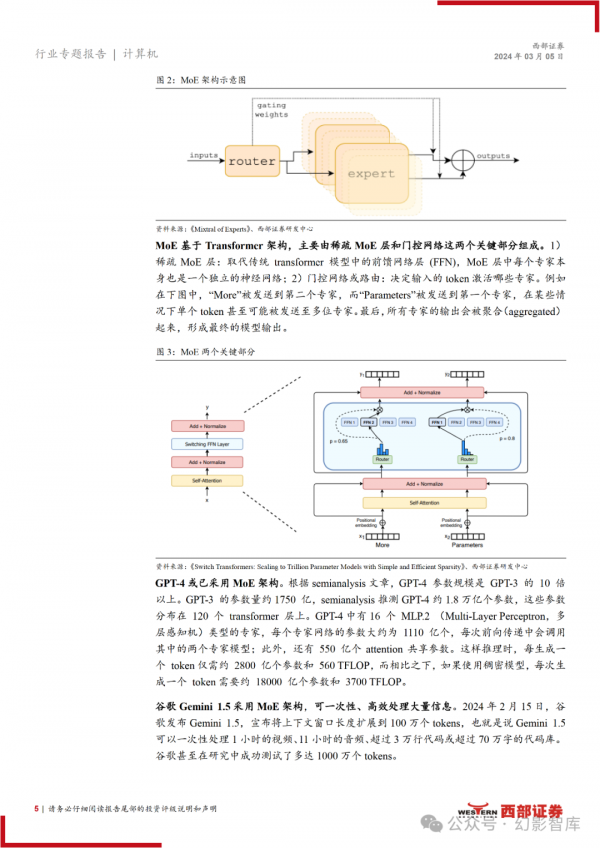

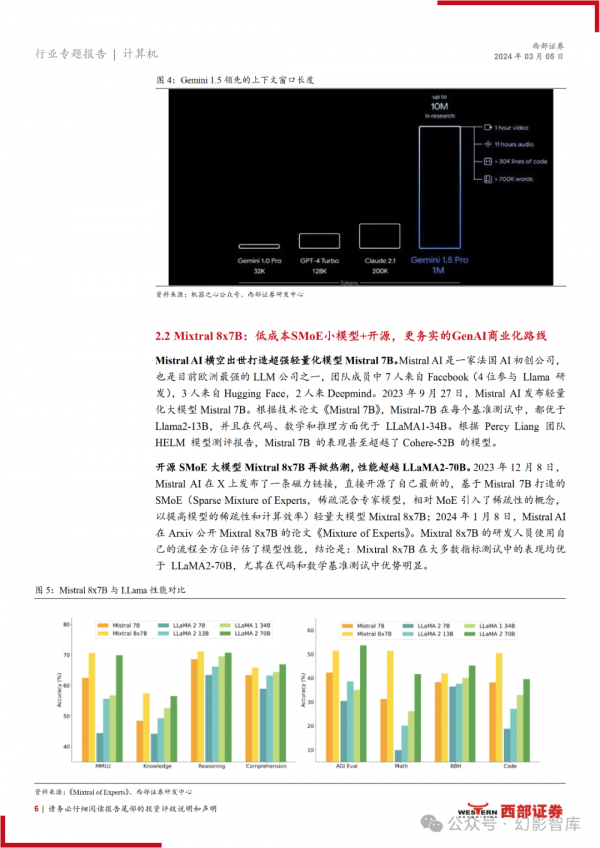

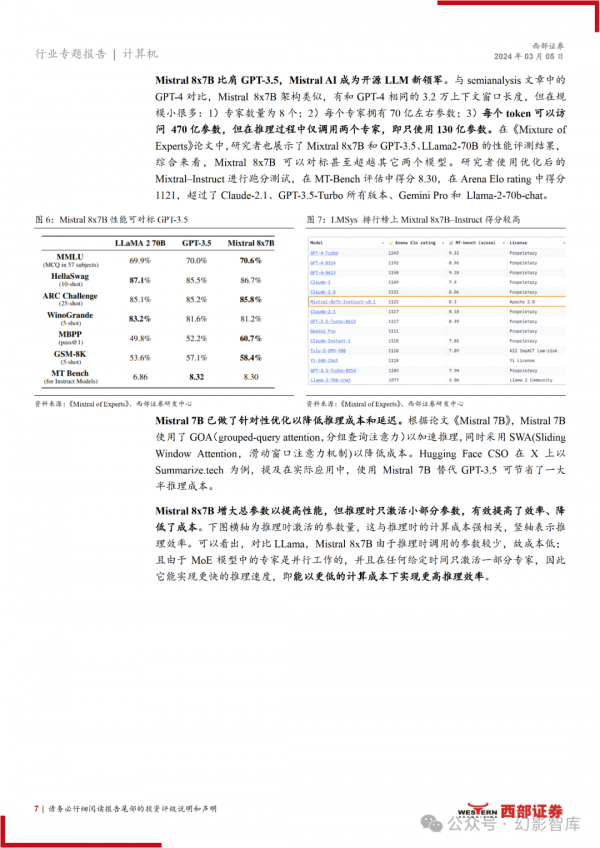

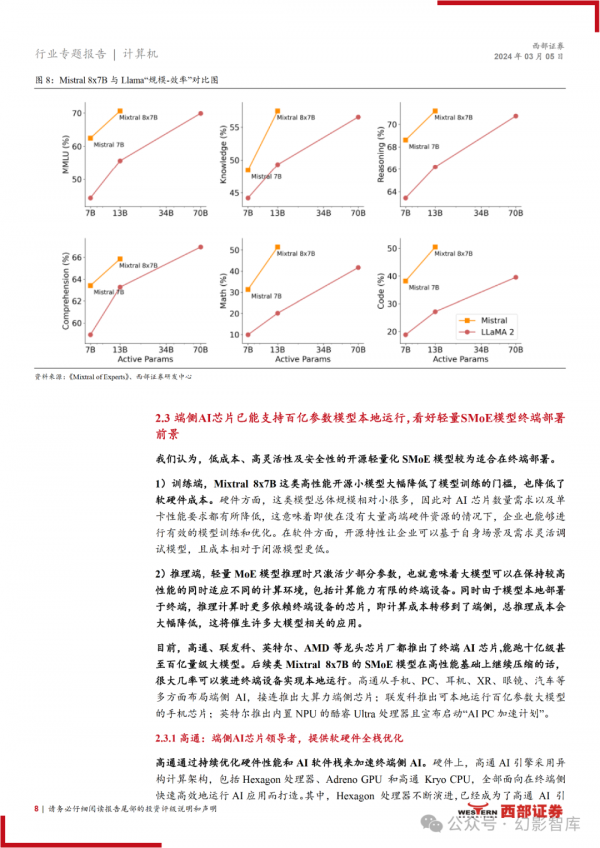

百亿参数开源 MoE 大模型 Mixtral 8x7B 再掀热潮,性能超 LLaMA2-70B,对 标 GPT-3.5。MoE(混合专家模型)通过将任务分配给对应的一组专家模型来 提高模型的性能和效率。Mixtral 8x7B 的专家数量为 8 个,总参数量为 470 亿, 但在推理过程中仅调用两个专家即只调用 130 亿参数。

我们认为 MoE 或为现阶段大模型平衡成本、延迟以及性能的最优选择,叠加 开源模型本身高灵活性、安全性和高性价比特点,Mistral AI 的开源 MoE 轻量 化模型可能是未来最适合部署于终端的模型。

目前,高通、联发科、英特尔、 AMD 等龙头芯片厂商都推出了终端 AI 芯片,能跑十亿甚至百亿量级大模型。后 续类 Mixtral 8x7B 的 SMoE 模型在高性能基础上继续压缩的话,很大几率可以 装进终端设备实现本地运行。

SMoE 轻量模型大幅降低了训练的门槛和成本, 且由于在推理时只激活少部分参数,保持较高性能的同时能适应不同的计算环 境,包括计算能力有限的终端,降低推理成本且将催生更多大模型相关应用。

2024 年有望成为终端智能元年,看好拥有终端资源、深耕场景、掌握行业 knowhow、积累了海量数据的 B 端和 C 端公司。

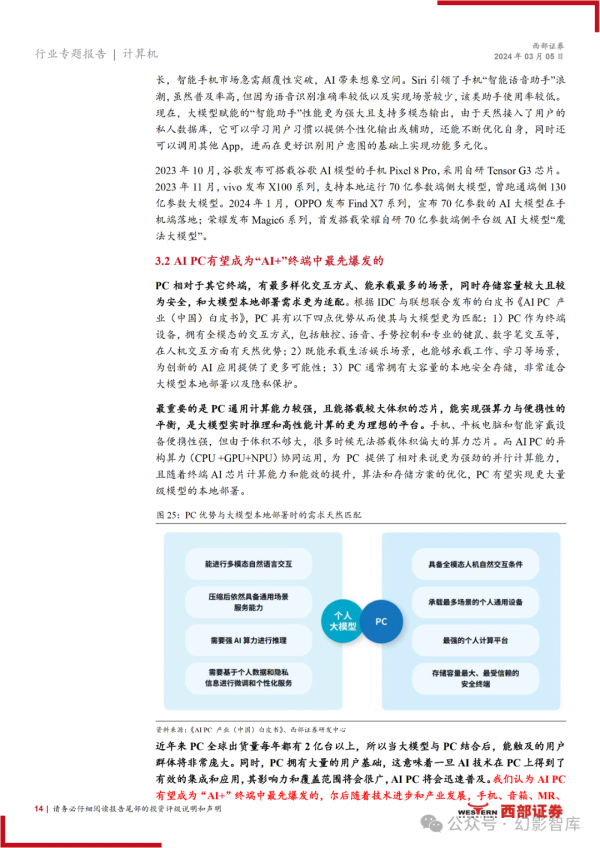

1)未来每台终端都将是 AI 终端,包括 AI PC、AI 手机、AI MR 等,这将带来全新的用户体验。

2)AI PC 有望成为“AI+”终端中最先爆发的。英特尔预计全球今年将交付 4000 万台 AI PC,明年将交付 6000 万台,预估 2025 年底 AI PC 在全球 PC 市场中占比将超 过 20%;微软 AI PC 预计于今年亮相。

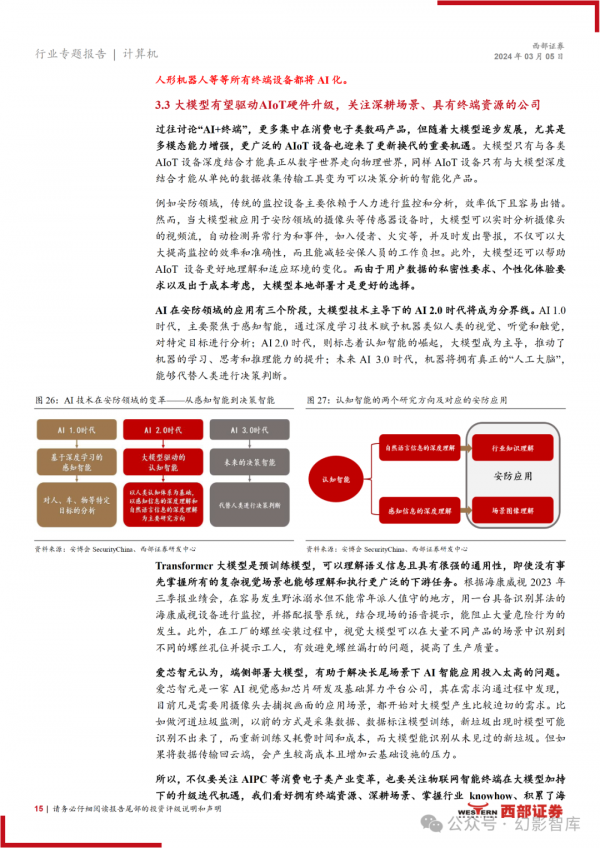

3)随着大模型逐步发展,尤其是多模态 能力增强,更广泛的 AIoT 设备也迎来了更新换代的重要机遇。

4)B 端私有化 部署也是 AI 应用的重要方向,关注边缘侧 AI。

5)鸿蒙:提供顶级流畅连接体 验,大模型有望赋能奔赴万物智联下一站。

人形机器人是大模型应用的重要硬件载体,也是终端智能发展的核心方向。

1) 人形机器人是目前具身智能最好的形态,因为它们有着与人相似的外观设计, 能更好地适应周围的环境和基础设施。2)端云混合的“大脑”让机器人既能处理 复杂和高强度的计算任务,又能实时进行信息处理和分析。

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。