600GB显存才能拉起来的Grok-1不太惊艳!马斯克大模型企业xAI开源Grok-1,截止目前全球参数规模最大的MoE大模型!

此前,马斯克在推特上宣布要开源旗下大模型公司开发的Grok-1大语言模型。一周后的现在,这个模型Grok-1正式宣布以Apache2.0开源协议开源,本文将针对Grok-1的技术部分进行介绍。

Grok-1简介

Grok-1的表现

Grok-1的推理资源要求

Grok-1总结

Grok-1简介

Grok-1是马斯克旗下大模型企业xAI的首个大语言模型商业产品。但他们最早训练的大模型是Grok-0,Grok-0是一个330亿参数的规模较小的模型,它用了Llama2-70B一半的硬件资源就达到了Llama2-70B的水平。因此,xAI研发人员很有信心,继续开发了Grok-1。

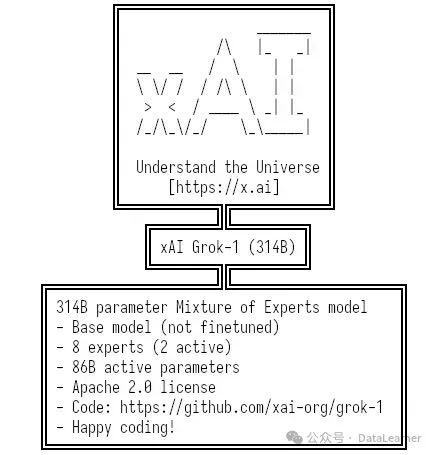

Grok-1最早在2023年11月初公开,随后在X平台上使用。此次开源后,Grok-1成为了目前开源大模型中参数最高的一个(除去此前反响平平的1.6万亿的谷歌大模型)。而更重要的是,这也是一个混合专家架构的模型,类似Mixtral 8×7B MoE模型(参考:https://www.datalearner.com/ai-models/pretrained-models/Mistral-7B-MoE )。具体来说,Grok-1模型参数如下:

| Grok-1模型架构参数项 | Grok-1模型参数结果 |

|---|---|

| 架构 | 混合专家模型 |

| 参数总数 | 3140亿 |

| 专家数 | 8个 |

| 每个专家参数数量 | 430亿 |

| 每次推理激活的参数数量 | 860亿 |

| 开源协议 | Apache 2.0 |

| 词汇表数量 | 131072 |

| 上下文长度 | 25万字符 |

不过,需要注意的是,Grok-1的训练是在xAI团队自己搭建的平台上,基于JAX等先进的基础设施。本次开源的只有Grok-1的推理代码,不包含训练代码!

Grok-1的表现

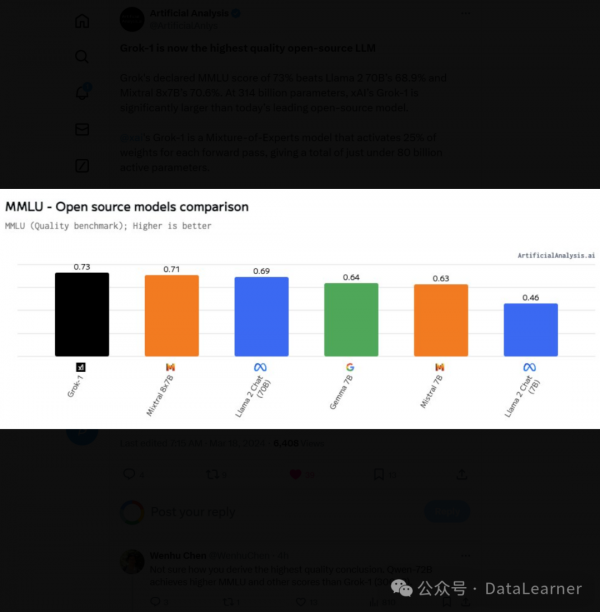

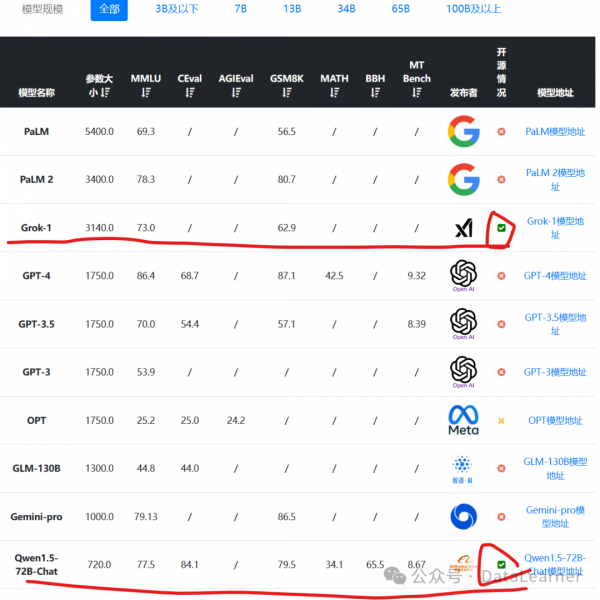

首先,根据11月份透露的数据,Grok-1模型在各项评测结果中表现不错,但并不算突出。其MMLU得分73分,应该说得分超过了GPT-3.5,但是不如Qwen-72B。而数学推理(GSM8K)方面表现更差,不如60亿参数规模的ChatGLM3-6B。要知道,Grok-1的模型总参数是3140亿,每次激活860亿,这个水平相比较而言应该说不令人满意。

上述数据是按照参数大小排序,可以看到这是目前开源中参数规模最高的大模型了。排第二的开源模型是阿里巴巴的720亿参数规模的Qwen-72B。具体数据参考:https://www.datalearner.com/ai-models/llm-evaluation

Grok-1的推理资源要求

从上面的分析可以看到,Grok-1是一个不错的模型,但是与同类相比劣势比较明显。主要就是在于它资源消耗更大,但是没有获得相应的收益。以它和Mixtral 8×7B MoE模型对比(二者都是混合专家模型):

| 对比内容 | Grok-1 | Mixtral 8×7B MoE |

|---|---|---|

| 总参数 | 3140亿 | 456亿 |

| 专家数量 | 8 | 8 |

| 每个专家参数 | 430亿 | 60亿 |

| 每次激活参数数量 | 860亿 | 120 亿 |

| 半精度模型运行最低显存 | 628GB | 92GB |

| 每次推理速度接近的模型参数 | 860亿参数模型 | 120亿参数模型 |

| 理解综合能力(MMLU) | 73 | 71 |

| 数学推理能力(GSM8K) | 62.9 | 74.4 |

从上述简单对比可以看到,Grok-1用了远比Mixtral 8×7B MoE模型更多的资源,结果就是MMLU评测略高,而数学推理还不如Mixtral 8×7B MoE。

Grok-1总结

尽管Grok-1已经开源。但是也些关键信息并没有透露。首先,xAI宣称他们是基于一套高效的基础设施进行训练的。这套高效的基础设施架构并未透露。另外,就tokenizer来说,Grok-1包含了13万个tokens,远超Llama系列。而且tokenizer中出来特殊的”[PAD]”、”[BOS]”、”[EOS]”、”[UNK]”外,还有此前大家没见过的”<|controlX|>”token,这里的X是1-20,它的作用并不清楚。联想到Grok-1本身作为基础模型,有super prompt、新闻等特殊能力,这部分是不是可能会影响也不知道。原因就是Grok-1的训练代码没有公布。

关于Grok-1的SuperPrompt等能力介绍参考此前的内容:https://www.datalearner.com/blog/1051699114783001

不管怎么说,Grok-1里面还是有新的东西的。至少从主流开源模型的效果看,Grok-1虽然还可以,但不够惊艳。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。