极智项目 | 基于Pytorch+UNet实现医学图像分割算法 支持算法训练+预测

医学图像分割技术是借助先进的计算机视觉算法,针对医学影像数据进行智能识别与精确剪裁的核心手段,在医学诊断、治疗设计以及深入的图像分析等方面扮演着至关重要的作用。医学图像分割算法融合了众多方法论,从传统的基于阈值、区域生长、分裂合并、边缘检测等原理出发,逐步发展至包含区域相似性分析的水平集、区域竞争等高级算法,再到当今前沿的机器学习和深度学习技术,诸如 U-Net、全卷积网络 (FCN)、Mask R-CNN、DeepLab 等深度学习模型的广泛应用,极大地提升了分割的精度与效率。

这个项目使用主流的深度学习框架 Pytorch + UNet来实现,项目的特点是支持训练、分割算法特别轻量化、能够一键执行训练+预测,能够适应分割结构复杂的医学图像。项目提供完整的代码,包括训练 + 预测代码、一键执行脚本、训练好的分割模型权重 (当然也支持自己训练)、项目三方依赖库 (requirements.txt)、训练标注图片、待检测的测试图片、检测后的效果图等。

在拿到项目代码后,进行开发环境的配置,老习惯用 Anaconda3 管理 py 环境,如下,

# 安装 Anaconda3,过程略 ~# 创建conda py环境conda create -n aipro_py39 python=3.9# 激活conda py环境conda activate aipro_py39

然后自行安装 pytorch,然后直接运行 run.sh一键执行脚本即可进行三方依赖安装 + 执行训练 + 执行推理测试。run.sh 的内容很简单,如下:

# 安装三方依赖pip install -r requirements.txt# 执行训练 + 执行推理python main.py

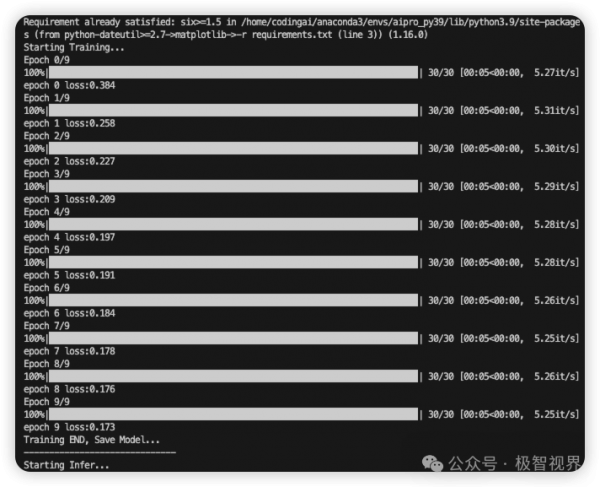

执行训练过程如下:

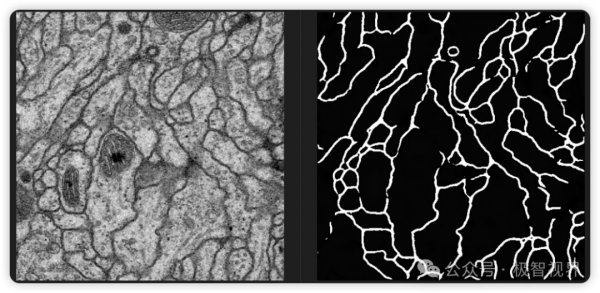

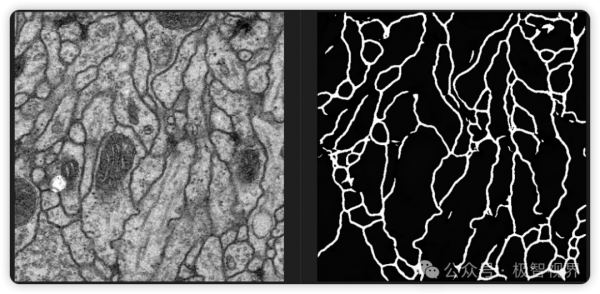

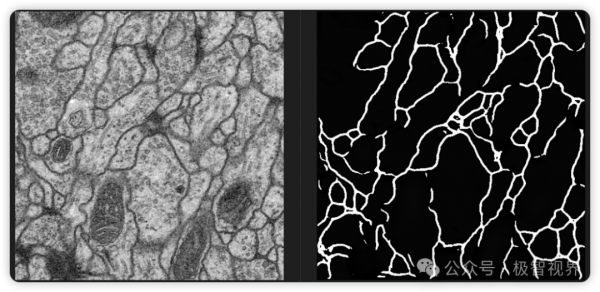

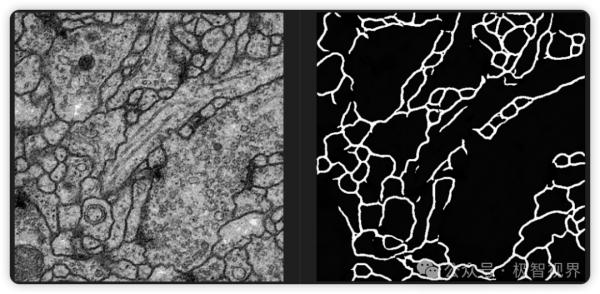

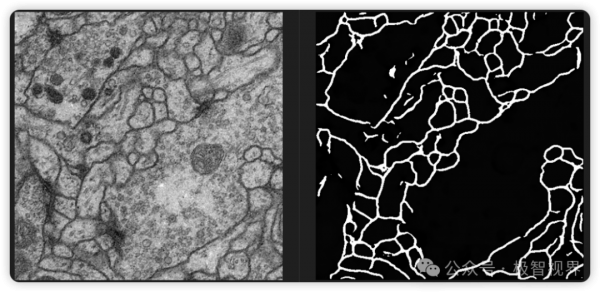

预测结果保存在 res 文件夹下,下面展示医学图像分割效果,分割结果以 mask 二值图的形式展示,部分分割结果如下 (左边为原图,右边为分割图),可以看到即使是边界不太清楚的结构也是可以分割的比较清楚,且项目在增加 + 丰富训练数据集后,分割效果会进一步提升。

来源:极智视界

好文章,需要你的鼓励

几分钟完成3D渲染?HP ZBook Fury G1i 移动工作站让AI设计流程真正落地了

还在为渲染一个3D模型等上几小时吗?还在纠结移动办公就得牺牲性能吗?当AI遇上专业工作站,传统设计流程的游戏规则正在被改写。

伊斯法罕大学研究团队揭秘:AI教育应用如何在数字化教学时代赢得用户青睐

伊斯法罕大学研究团队通过分析Google Play商店21款AI教育应用的用户评论,发现作业辅导类应用获得超80%正面评价,而语言学习和管理系统类应用表现较差。用户赞赏AI工具的快速响应和个性化指导,但抱怨收费过高、准确性不稳定等问题。研究建议开发者关注自适应个性化,政策制定者建立相关规范,未来发展方向为混合AI-人类模型。

OpenAI或从亚马逊获得超100亿美元融资

据报道,OpenAI正与亚马逊洽谈至少100亿美元的融资。亚马逊此前已是Anthropic的最大投资者,并为其建设了110亿美元的数据中心园区。若融资达成,OpenAI将采用AWS的Trainium系列AI芯片。Trainium3采用三纳米工艺,配备八核心和32MB SRAM内存。AWS可将数千台服务器连接成拥有百万芯片的集群。报道未透露具体估值,但OpenAI最近一次二次出售估值已达5000亿美元。

伊利诺伊大学香槟分校团队揭秘:如何在数据海洋中精准找到“最对胃口“的训练素材

这项由伊利诺伊大学香槟分校等四所院校联合完成的研究,提出了名为DaSH的层次化数据选择方法。该方法突破了传统数据选择只关注单个样本的局限,通过建模数据的天然层次结构,实现了更智能高效的数据集选择。在两个公开基准测试中,DaSH相比现有方法提升了高达26.2%的准确率,同时大幅减少了所需的探索步数。