人形机器人行业深度:中美共振,人形机器人产业奇点到来

AI 赋能机器人及 Optimus 进展成为双主线。

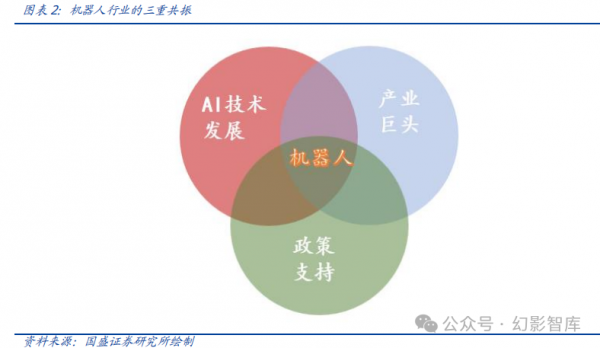

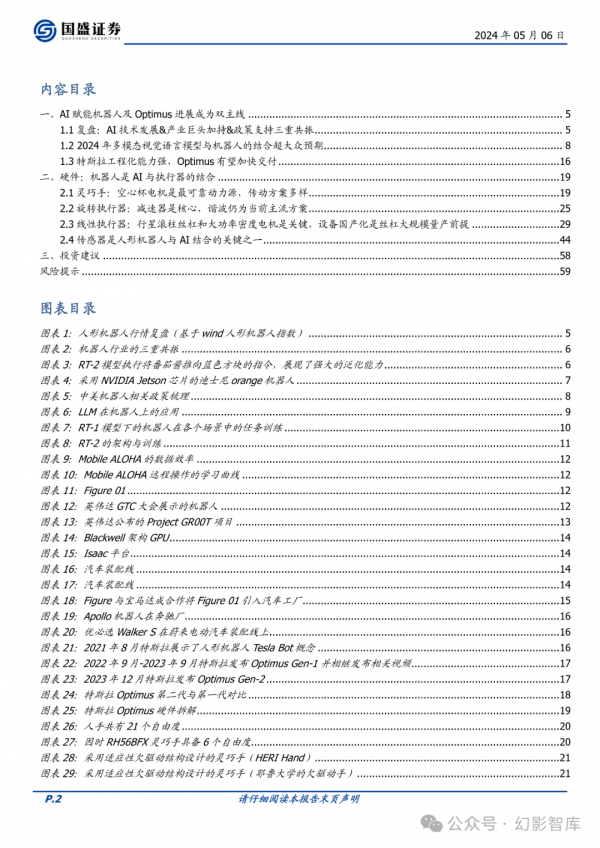

人形机器人产业趋势的共 识在多轮行情中逐渐形成,呈现 AI 技术发展+产业巨头加持+政策支持的 三重共振,AI 赋能机器人及特斯拉 Optimus 进展也成为板块的双主线。 多模态视觉语言模型与机器人的结合超大众预期。2023 年 12 月特斯拉发 布 Optimus Gen-2 的视频,相比于第一代 Optimus 人形机器人,第二代 Optimus 增加六维力传感器、触觉传感器,进步明显,速度快 30%、重量 减轻 10kg。

机器人加速国内传感器行业发展,国内传感器厂商为机器人蓄力。

机器人 了解周围环境需要广泛的信息,传感器是重要的“中介”,是机器人软硬 件结合关键步骤之一,人形机器人需要的传感器种类众多,包括但不限于 触觉/力/扭矩/视觉/惯性等传感器,传感器技术涉及物理、电子、材料学 等多种学科融合,存在极高的技术壁垒,因此过去在传感器市场中占据一 席之地的更多是国外厂商。行至今日,国内众多优秀的传感器公司如雨后 春笋般出现,如发布多维触觉传感器的帕西尼、具备全方位 3D 视觉产业 链技术的奥比中光、具备玻璃微熔拉压力传感器技术的安培龙等,国内传 感器厂商有望在人形机器人浪潮中充分受益。

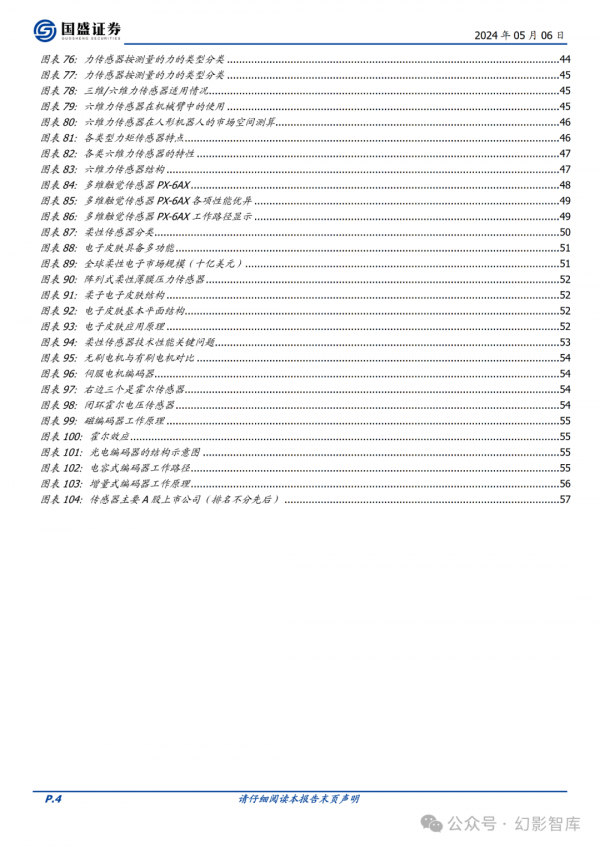

机器人行业已呈现 AI 发展&产业巨头&政策支撑三重共振特性,在产业起点积蓄 力量。多模态大语言模型的出现,代表人形机器人“大脑”层面难题取得突破。同时 2022 年以来产业巨头陆续入局,中、美等国政策支持也相继推出,在三重共振下,人形机器 人有望形成类似于汽车、智能手机的全球性产业链。

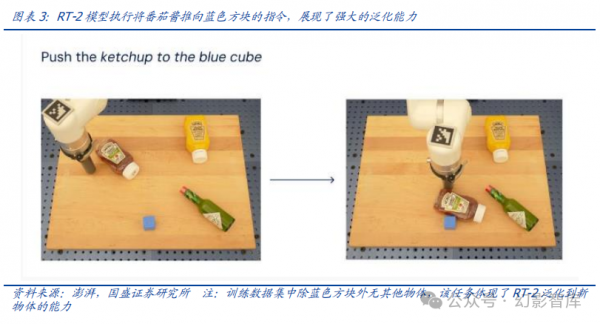

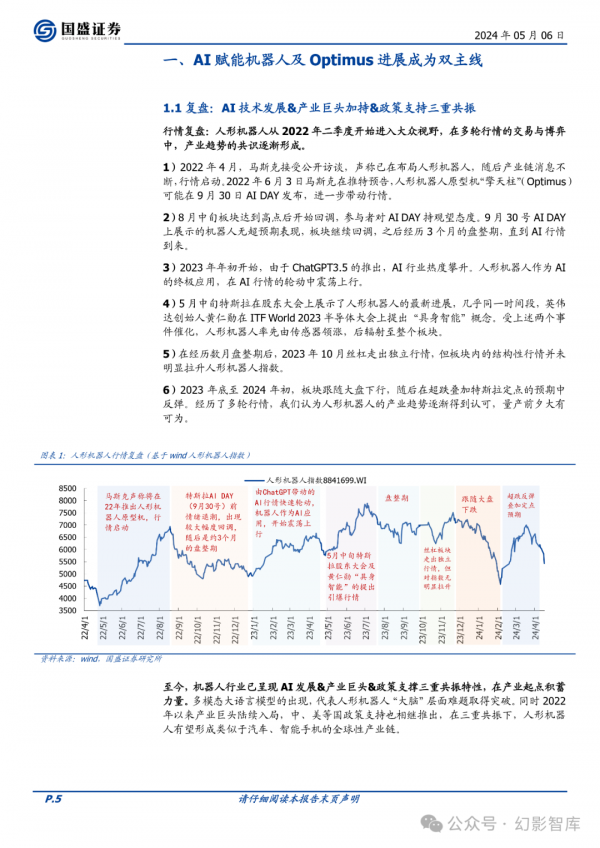

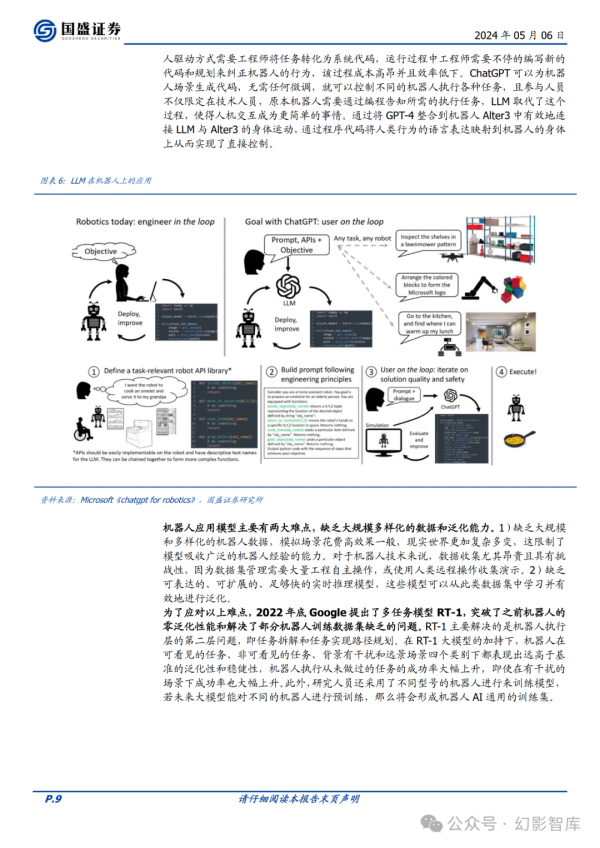

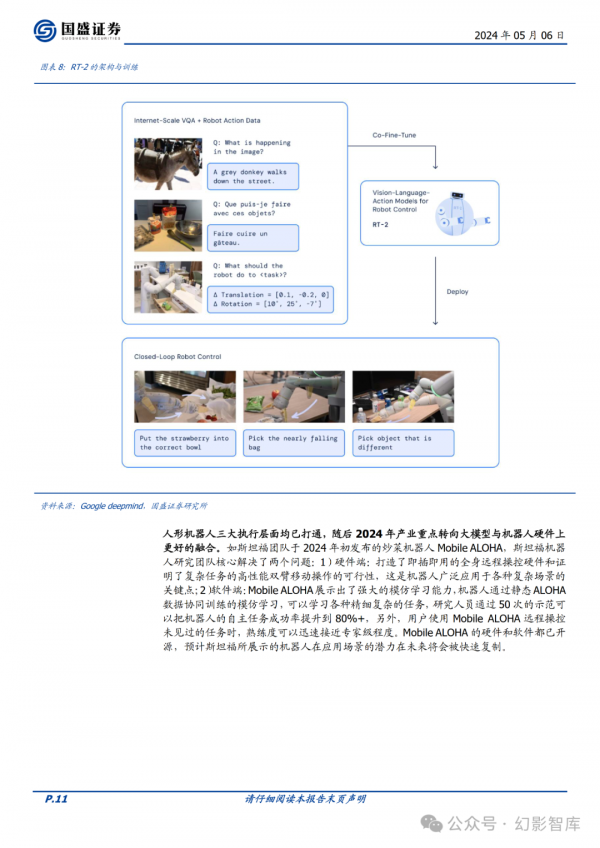

第一:AI 技术发展。通用人工智能大模型是实现“具身智能”的关键一环,近年人工智 能快速发展,机器人装上“大脑”成为可能。机器人的大脑需要解决解理、决策、执行 三个层面的问题,以 ChatGPT3.5 为代表多模态大语言模型解决了机器人理解人类语言 和外部世界的问题;谷歌 RT-1 模型以图片序列、自然语言指令作为输入,是一种视觉- 语言模型(VLMs),展现了较强的泛化能力和鲁棒性,主要解决了前两个层面的问题;而 谷歌 RT-2 模型则是基于视觉-语言-动作模型(VLA)的端到端模型,加入了动作模态, 提高了机器人的泛化能力、涌现能力和策略的完成率。RT-2 已经足够具身化,将机器人 执行层的感知、任务拆解、硬件驱动实现了 AI 化。

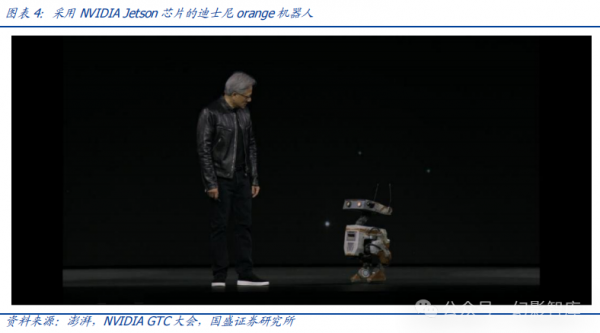

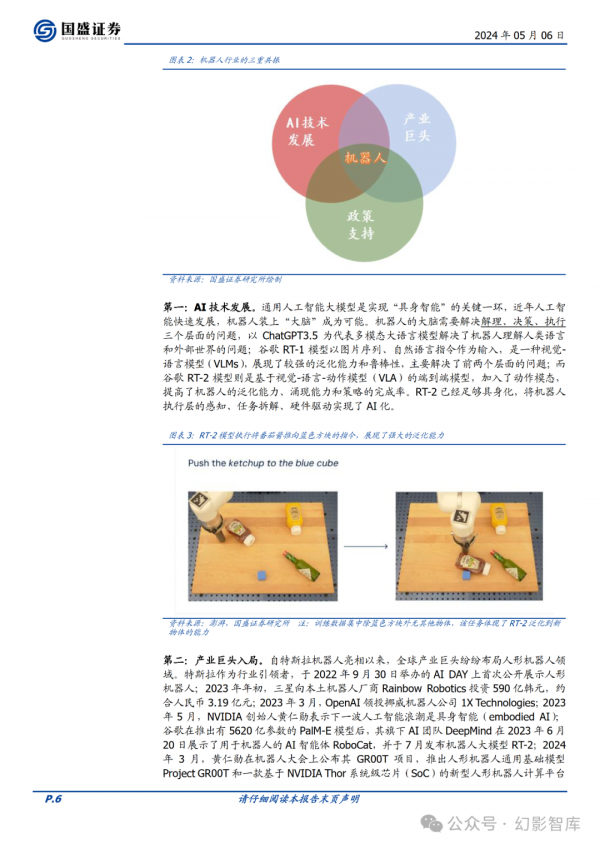

第二:产业巨头入局。自特斯拉机器人亮相以来,全球产业巨头纷纷布局人形机器人领 域。特斯拉作为行业引领者,于 2022 年 9 月 30 日举办的 AI DAY 上首次公开展示人形 机器人;2023 年年初,三星向本土机器人厂商 Rainbow Robotics 投资 590 亿韩元,约 合人民币 3.19 亿元;2023 年 3 月,OpenAI 领投挪威机器人公司 1X Technologies;2023 年 5 月,NVIDIA 创始人黄仁勋表示下一波人工智能浪潮是具身智能(embodied AI); 谷歌在推出有 5620 亿参数的 PalM-E 模型后,其旗下 AI 团队 DeepMind 在 2023 年 6 月 20 日展示了用于机器人的 AI 智能体 RoboCat,并于 7 月发布机器人大模型 RT-2;2024 年 3 月,黄仁勋在机器人大会上公布其 GR00T 项目,推出人形机器人通用基础模型 Project GR00T 和一款基于 NVIDIA Thor 系统级芯片(SoC)的新型人形机器人计算平台 Jetson Thor。

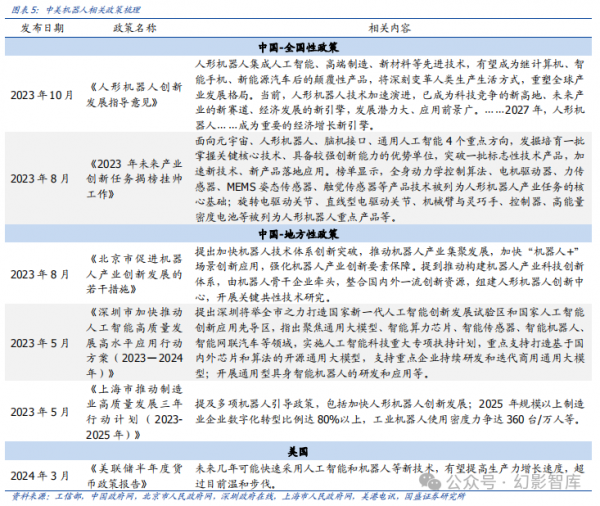

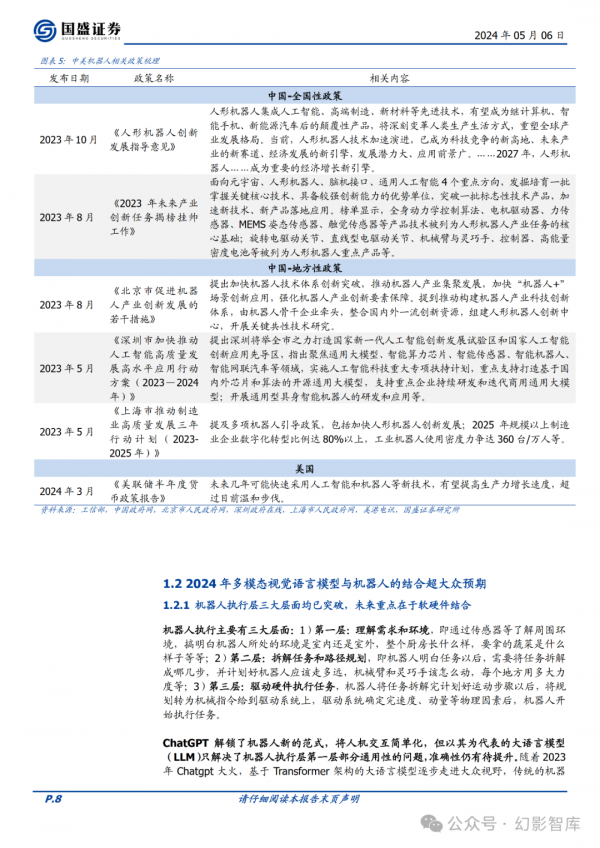

第三:政策支持,中美共振。2022 年以来国内人形机器人相关政策频出,北京、上海、 深圳等地都出台了推动产业发展的地方性政策。2023 年 10 月,工信部印发《人形机器 人创新发展指导意见》,将人形机器人提升到与计算机、智能手机、新能源汽车同等的战 略高度,并表示人形机器人有望在 2027 年成为经济增长的新引擎。美国方面,2024 年 3 月,美联储半年度货币政策提出,未来几年美国可能快速采用人工智能和机器人等新 技术,有望提高生产力增长速度。

好文章,需要你的鼓励

更高负载、更快建设:2026年数据中心六大趋势

随着人工智能和高性能计算持续推动需求增长,数据中心设计正以同样惊人的速度演进。曾经的高密度机架已成为标准配置,冷却系统在数月而非数年内完成重新设计,项目在各地区的规模和复杂性不断提升。全球工程设计咨询公司Black & White Engineering指出,液冷成为标准配置、极端机架密度管理、工业化规模交付、电网约束下的电力创新、AI驱动运营设计以及可持续性成为核心设计原则,将成为2026年塑造数据中心设计、建设和运营的六大关键趋势。

让任何视频都能“讲述“自己的故事:ByteDance研究团队如何用轨迹场重新定义4D视频理解

这项由ByteDance Seed、香港科技大学等机构联合完成的研究提出了"轨迹场"这一创新的4D视频表示方法。研究团队开发的Trace Anything系统能够在单次前向传递中为视频中的每个像素预测连续的三维轨迹,无需光流估计或迭代优化。通过构建大规模合成数据平台和精心设计的训练方案,该方法在轨迹估计基准上实现了最先进性能,同时推理速度比竞争方法快10倍以上,并展现了运动预测、时空融合等多种涌现能力。

Snowflake数据库更新引发全球大规模服务中断

Snowflake本周推送的一次更新导致全球范围内的"重大故障",用户长达13小时无法查询数据、文件导入失败并收到错误信息。初步调查显示,最新版本引入了不向后兼容的数据库架构更新,导致版本不匹配错误。此次故障影响了全球23个区域中的10个,包括美国、欧洲和亚洲多个数据中心。这是Snowflake一周内第二次发生事故。

伊斯法罕大学研究团队揭秘:AI教育应用如何在数字化教学时代赢得用户青睐

伊斯法罕大学研究团队通过分析Google Play商店21款AI教育应用的用户评论,发现作业辅导类应用获得超80%正面评价,而语言学习和管理系统类应用表现较差。用户赞赏AI工具的快速响应和个性化指导,但抱怨收费过高、准确性不稳定等问题。研究建议开发者关注自适应个性化,政策制定者建立相关规范,未来发展方向为混合AI-人类模型。