阿里云周靖人:发布通义千问2.5,坚持做开源大模型 原创

2023年4月,通义千问正式面世,阿里的大模型征程就此进入大众视野。

在过去一年里,阿里云通义千问对内经历了多次产品升级和迭代,对外经历了百模大战和持续开源。

时隔一年后,5月9日,阿里云在北京召开AI智领者峰会,大会上,阿里云CTO周靖人正式发布了通义千问2.5版本,与此同时,“通义千问APP”正式更名为“通义APP”。

在这一年,全球不需要大量基础大模型成为共识,有竞争力的基础大模型开始收敛到10家以内,对于阿里云来说,如何围绕基础大模型和开源大模型打造出更完善的生态就成了一个关键问题。

总结过去一年发展历程,周靖人在大会上指出,“从2022年9月发布通义系列模型以来,如今我们的API日调用量已经过亿。”

在这个过程中,阿里云通义系列大模型已经服务了包括新浪微博、中国一汽、完美世界、蓝凌科技在内的9万家企业用户。

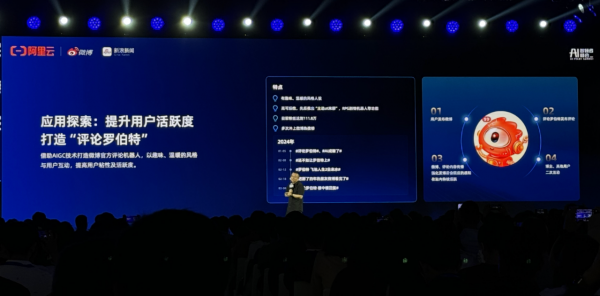

其中,作为阿里云通义千问最早的用户,微博目前已经将大模型技术应用到了AI评论、AI明星陪聊、虚拟角色帐号、星座大模型、信息流广告创意生成等场景,据微博COO、新浪移动CEO王巍透露,借助AIGC技术,微博打造了官方评论机器人“评论罗伯特”。

如今,“评论罗伯特”拥有超百万粉丝,已经成了百万粉丝博主。

作为刚刚因电动汽车发布爆红全网的小米,同样是阿里云通义大模型的用户。

据悉,小米的人工智能助手小爱同学基于阿里云通义大模型在强化其在图片生成、图片理解等方面的多模态AI生成能力,并在小米汽车、音箱、手机等多类硬件产品中落地应用。

小米集团小爱总经理王刚指出,“通过使用大模型技术,小爱同学活跃用户次日留存率提升了10%,中长尾问答类问题的回答满意度从30%-40%提升到了80%。”

大会上,阿里云正式对外发布了通义千问2.5,全新的通义千问2.5在各方面性能上进行了一系列升级:

在文档处理能力方面,通义千问2.5单次可处理多达1000万字的长文档,可以同时解析100份不同格式的文档;

在音视频理解能力方面,通义千问2.5可以精准高效地进行音视频文件的识别理解、摘要总结、多语言翻译,可同时上传处理50个音视频文件;

在智能编码能力方面,通义千问2.5集成了通义灵码,可以帮助用户随时随地在手机上写代码、读代码、学习编程技能。

发布会现场,周靖人还将通义千问2.5与自家的通义千问2.1版本和GPT-4 Turbo进行了性能对比。

从大会上的对比数据可以看到,相较此前的通义千问2.1版本,通义千问2.5的理解能力、逻辑推理、指令遵循、代码能力分别提升了9%、16%、19%、10%;而在OpenCompass的测评结果中,通义千问2.5的得分也已经追平GPT-4 Turbo。

在这次大会上,阿里云还对通义大模型进行了品牌升级,“通义千问APP”正式更名为“通义APP”,通义APP集成通义大模型全栈能力,并免费为所有用户提供服务。

作为开源大模型的坚实拥趸,自2023年8月以来,阿里云陆续开源了十数款模型,据官方公布数据显示,目前通义开源模型下载量已经超过了700万。

也是在这场发布会上,阿里云官方表示,通义千问最新开源的1100亿参数模型在多个基准测评收获最佳成绩,超越Meta的Llama-3-70。

据悉,目前阿里云通义系列模型参数规模横跨5亿到1100亿,小尺寸模型有0.5B、1.8B、4B、7B、14B参数规模,可用于手机、PC等端侧设备部署;大尺寸模型有72B、110B参数规模,能支持企业、科研级应用。

此外,阿里云还开源了视觉理解模型Qwen-VL、音频理解模型Qwen-Audio、代码模型CodeQwen1.5-7B、混合专家模型Qwen1.5-MoE。

此外,作为阿里云构建的模型开源社区——魔搭(ModelScope)已经拥有模型数量超过4500个,用户规模超过500万。

周靖人在大会上表示,“今天我们可以很自豪地讲,阿里云是全球唯一一家既在持续做(大)模型开发,又做大量(大)模型开源的公司。”

好文章,需要你的鼓励

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

人工智能安全公司Cyata发现LangChain核心库存在严重漏洞"LangGrinch",CVE编号为2025-68664,CVSS评分达9.3分。该漏洞可导致攻击者窃取敏感机密信息,甚至可能升级为远程代码执行。LangChain核心库下载量约8.47亿次,是AI智能体生态系统的基础组件。漏洞源于序列化和反序列化注入问题,可通过提示注入触发。目前补丁已发布,建议立即更新至1.2.5或0.3.81版本。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车

从软件定义汽车到AI驱动质控:Testin云测助力车机测试数智化价值落地

无需Linux即可运行自由开源软件

超越 SEO:AI 引擎优化如何改变在线可见性格局

新Mac必装应用:五款提升工作效率的神器推荐

DXC蒲公英计划:为神经多样性IT专业人士赋能