大模型场景下智算平台的设计与优化实践

-

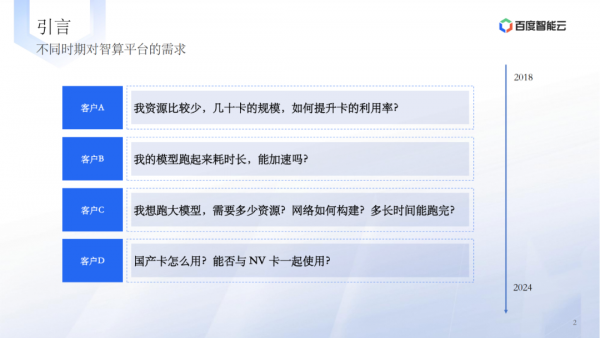

小模型与大模型的区别主要体现在训练时长、成本和工程问题上。 -

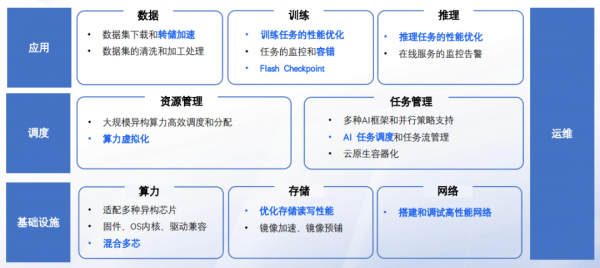

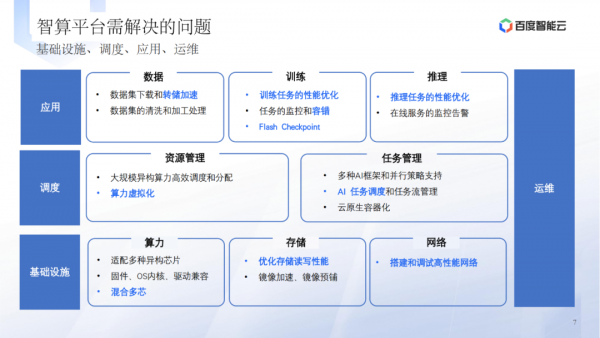

大模型时代的智算平台需要解决基础设施、调度、应用和运维等方面的问题。 -

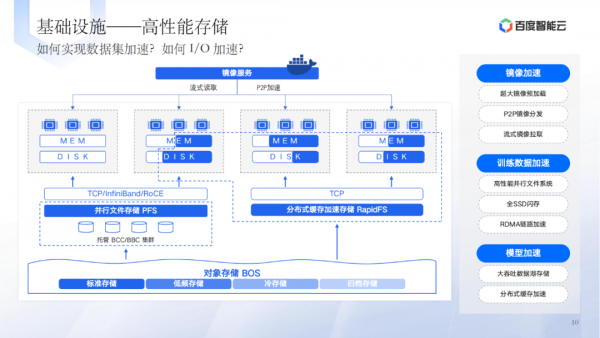

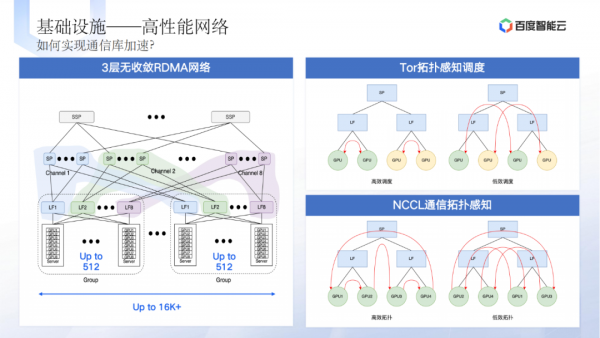

新的要求包括适配多种异构芯片、优化存储读写性能、高性能网络搭建等。

-

基础设施层面的问题包括适配多种异构芯片、固件和驱动兼容性等。 -

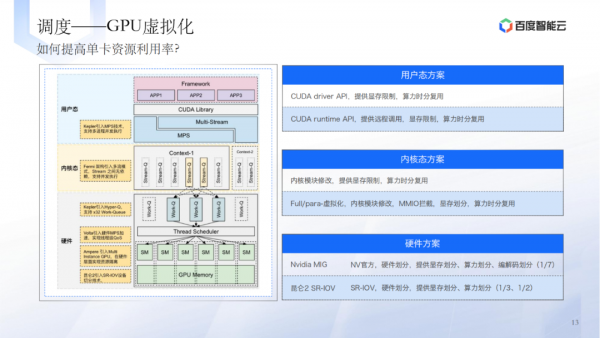

调度层的挑战涉及大规模异构算力的高效调度和分配。 -

应用层的需求包括训练和推理加速、训练容错等。 -

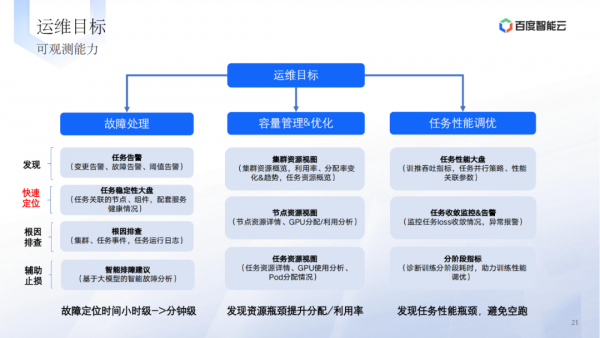

运维方面的目标是提高故障处理能力和容量管理效率。

-

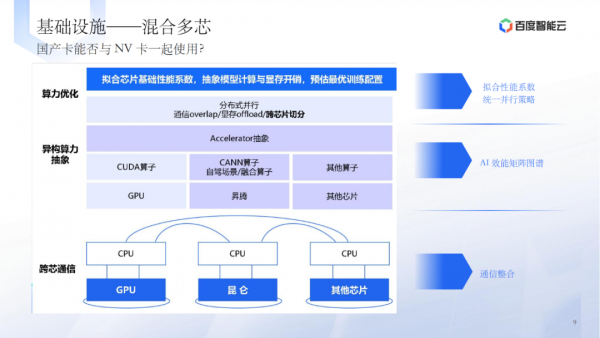

在基础设施层,讨论了国产卡与NV卡的兼容性、混合多芯的使用、高性能存储方案等。 -

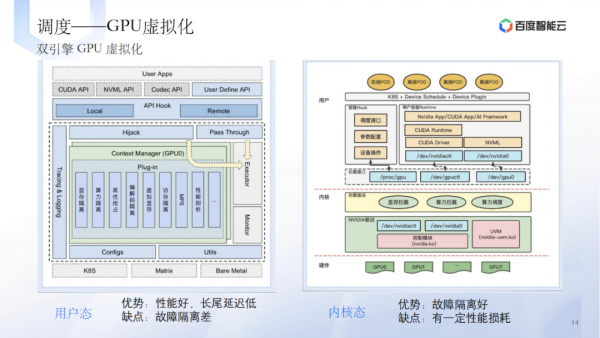

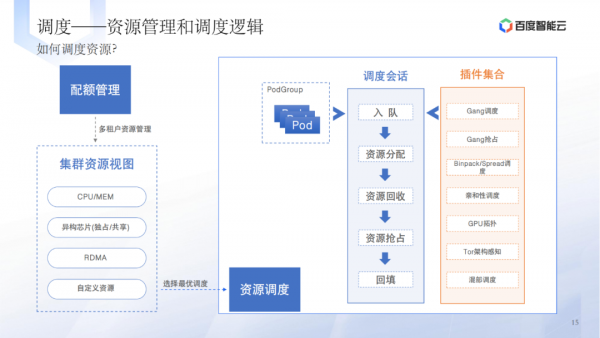

调度层的技术实践包括提高单卡资源利用率、GPU虚拟化、资源管理和调度逻辑等。 -

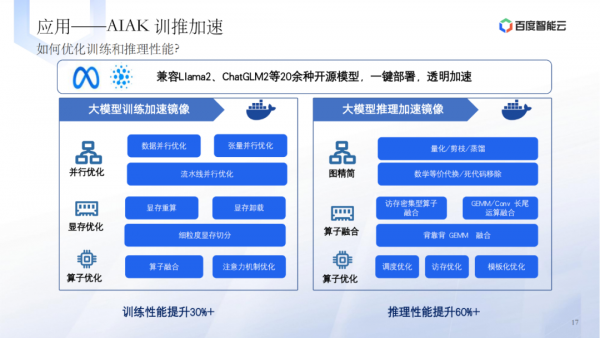

应用层的技术实践涉及AIAK训推加速、训练容错、Flash Checkpoint等。 -

运维方面的实践包括故障处理、容量管理、任务性能调优等。

-

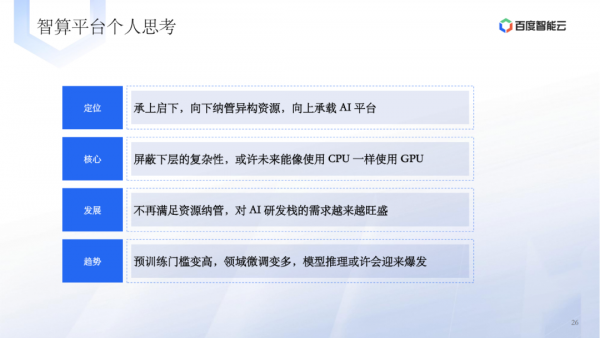

智算平台的发展应致力于简化下层复杂性,使GPU的使用更加便捷。 -

应定位于连接异构资源和承载AI平台的关键角色。 -

发展趋势显示预训练难度增加,领域微调多样化,模型推理可能迎来新的增长。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。