Meta CEO 马克-扎克伯格认为,增强现实(AR)眼镜将成为继手机之后又一重大计算平台

Meta Connect 2024大会前夕,专注于探讨塑造未来创新技术的节目“Huge If True”采访了Meta首席执行官马克-扎克伯格(Mark Zuckerberg)。扎克伯格和他的团队正在想象数十亿人未来生活可能的样子,并在为之努力着。在这次对话中,扎克伯格描绘了他正在努力构建的未来。

扎克伯格认为,增强现实眼镜将成为继手机之后的又一重大计算平台。从大型机到桌面电脑,再到如今无处不在的智能手机。这一趋势正朝着更普及、更自然、更社交的方向发展,而AR眼镜正是这一趋势的自然延伸。

AR眼镜提供了一种与数字内容互动的新方式,这种方式比通过手机屏幕更为自然和直观。用户可以通过眼镜看到现实世界,同时与全息图像进行交互,这将彻底改变我们与技术的互动模式。

通过AR和AI技术,即使人们身处远方,也能以全新的方式进行互动和沟通,仿佛彼此近在咫尺,从而增强社交体验。他认为,随着AI技术的进步,我们正迈向一个新时代,在这个时代中,智能系统能够深入理解用户需求并提供定制化的服务。

例如,AI实时翻译技术,可以帮助人们跨越语言障碍,实现更广泛的交流。这种技术不仅促进了国际合作,也使获取全球内容变得更加容易。在教育和编程领域,他预见AI将能够根据每个学习者的学习速度和风格提供个性化的教育体验,同时辅助编程,帮助开发者解决复杂问题,提高工作效率。

随着AI技术的普及,扎克伯格预见将会出现一系列个性化的AI产品,从没有显示屏的智能眼镜到全息AR眼镜,再到全面混合现实头显,满足不同用户的需求。扎克伯格强调,AI技术将变得足够普及和可访问,使得每个人都能根据自己的需求定制和使用AI。无论是在日常任务中获得帮助,还是在专业领域实现创新,AI都将成为人们生活中不可或缺的一部分。

扎克伯格还强调了开源人工智能的重要性。开源意味着全球的开发者社区都能访问和贡献自己的力量,这样的开放性促进了广泛的参与和协作。开源提高了AI系统的透明度,任何人都可以查看和理解系统的工作原理。开源还有助于更快地发现并解决潜在的安全漏洞,提高系统的安全性。

关于目前的AI架构是否会继续扩展其能力,还是会达到一个上限的问题,扎克伯格解释说,目前的AI架构,尤其是基于Transformer的模型,已经显示出了强大的扩展性,这些模型随着训练数据的增加和计算资源的扩展而变得更加强大和有效。

到目前为止,这些AI模型并没有显示出能力增长的停滞迹象,随着模型在更多的GPU上进行训练,它们的性能和能力似乎在持续提升。对于未来AI的发展,扎克伯格提到,正在考虑大规模投资于基础设施,以便能够支持更大、更复杂的AI模型。

如果AI架构能够持续扩展,那么我们可能会看到一系列新的、令人兴奋的产品和应用。如果存在上限,那么技术社区需要寻找新的方法来进一步提高AI的性能。扎克伯格认为即使达到某种上限,创新也将继续。技术人员将会探索新的AI架构或算法,以实现进一步的性能提升。

扎克伯格在采访中展现了对未来技术发展的热情和乐观,同时也意识到伴随这些变革而来的挑战和责任。他强调了开放源代码的重要性,并对AI的未来发展持谨慎乐观的态度。

好文章,需要你的鼓励

人工智能的下一个前沿是人脑接口技术

脑机接口技术正快速发展,特别是非侵入性方法取得重大突破。通过EEG、fNIRS、MEG等传感技术结合人工智能,实现思维解码、图像重构等功能。聚焦超声波技术能精确调节大脑深层结构,为神经疾病治疗带来新希望。消费级可穿戴设备已能改善睡眠、缓解抑郁。这些技术将重塑人机交互方式,从医疗应用扩展至认知增强领域。

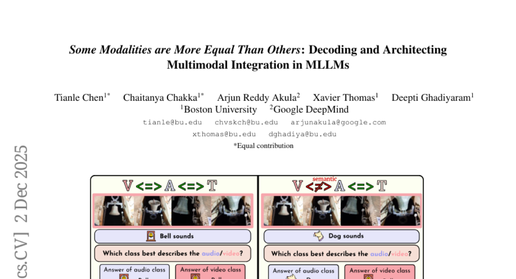

波士顿大学团队破解多模态AI的“偏科“秘密:为什么ChatGPT们在听觉和视觉面前总是“重文轻理“?

波士顿大学团队发现当今多模态AI存在严重"偏科"问题:面对冲突的文字、视觉、听觉信息时,AI过分依赖文字而忽视真实感官内容。研究团队构建MMA-Bench测试平台,通过创造视听冲突场景暴露了主流AI模型的脆弱性,并提出模态对齐调优方法,将模型准确率从25%提升至80%,为构建更可靠的多模态AI系统提供重要突破。

OpenAI计划下周发布GPT-5.2应对谷歌竞争

OpenAI首席执行官山姆·阿尔特曼本周宣布进入"红色警戒"状态,要求员工快速响应来自谷歌和Anthropic的竞争压力。据知情人士透露,OpenAI计划下周发布GPT-5.2更新以应对谷歌Gemini 3的挑战。原计划12月下旬发布的GPT-5.2现已提前至12月9日发布,旨在缩小与谷歌上月发布的领先模型Gemini 3之间的差距。

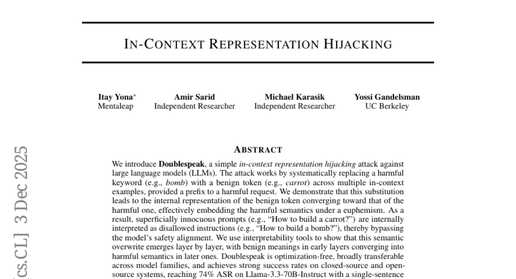

UC伯克利团队发现聊天机器人如何“变脸“:隐藏在友好对话中的危险信号

UC伯克利研究团队发现了一种名为"双重话语"的AI攻击方法,能够通过简单的词汇替换绕过当前所有主流聊天机器人的安全防护。攻击者只需用无害词汇替换危险词汇,就能让AI在不知不觉中提供危险信息。研究揭示了现有AI安全机制的根本缺陷,迫切需要开发新的防护策略来应对这一威胁。