人工智能要到达的AGI是什么样的?“人工智能教母”李飞飞也表示不知道

当地时间10月3日,在Credo AI负责任的 AI 领导力峰会上,李飞飞分享了如何保护社会免受高级AI模型的潜在威胁以及为什么她认为她创办的World Labs将改变一切,在访谈中,当被问及她对“人工智能奇点”的看法时,李飞飞困惑的表示不知道这些词是什么意思,她甚至也不知道“AGI”是什么意思。

“我来自人工智能学术界,接受的是更严谨、更循证的教育,所以我真的不知道这些词是什么意思。"“坦率地说,我甚至不知道 AGI 是什么意思。就像人们说的,当你看到它的时候你就知道它是什么,我想我还没有看到它。事实上,我并没有花太多时间去思考这些词,因为我觉得还有很多更重要的事情要做......”

当“人工智能教母”都不知道“AGI”是什么意思的时候,其他人的话语权可能更低。李飞飞在2006年启动的ImageNet项目,包含超过1500万张经过标注的图片,覆盖22000个不同类别。该项目直接推动了深度学习技术的崛起。

她曾是斯坦福大学的教授,并在谷歌云担任首席科学家。此外,她还是斯坦福大学以人为本人工智能研究院的院长。由她在今年4月份新创立的World Labs公司,在9月中旬最新一轮的融资中获得了2.3亿美元,短短半年的时间估值已达到10亿美元。

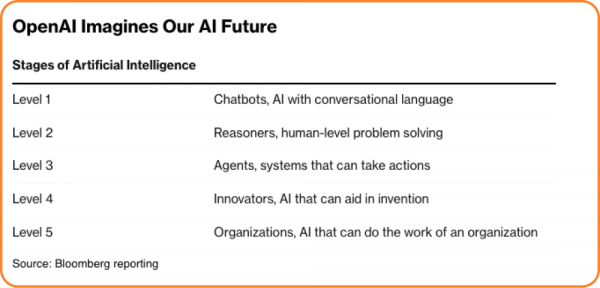

OpenAI的首席执行官Sam Altman曾尝试定义AGI,将AGI描述为“相当于你可以雇佣的中等水平的人类同事”。与此同时,OpenAI的章程将AGI定义为“在大多数经济价值工作上超越人类的高自主系统”。为了衡量进展,OpenAI设定了五个内部级别:第一级是聊天机器人(比如ChatGPT),然后是推理者(OpenAI o1),智能体(接下来是这个),创新者(可以帮助发明创新),以及最后一个级别,组织者(可以完成整个组织工作的AI)。

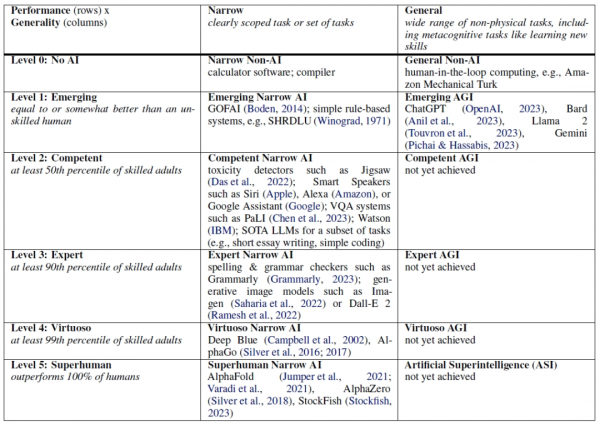

针对此问题,谷歌在2023年11月的一份论文中,专门对AGI进行了定义。这篇论文的名称是“Position: Levels of AGI for Operationalizing Progress on the Path to AGI”(立场:在通往通用人工智能之路上实现进展的AGI层次)。

在论文中,谷歌表示:通用人工智能(AGI)是计算机研究中一个重要且有时具有争议性的概念,用来描述至少在大多数任务上与人类能力相当甚至更强的AI系统。机器学习(ML)模型快速发展,AGI已经从纯粹的哲学讨论转变为一个具有现实意义的议题。一些专家认为,最新一代的大语言模型已经出现了AGI的“火花”;一些人预测AI将在大约十年内广泛超越人类;甚至有人声称当前的LLMs已经是AGI。

为了更好地理解和衡量AGI的进展,谷歌的研究人员提出了一个新的层次化的框架,将AGI的性能、通用性和自主性分为不同的层次。这个框架基于六个原则,包括关注能力而非过程、关注通用性和性能、关注认知和元认知任务、关注潜力而非部署、关注生态效度,以及关注通往AGI的道路本身。

通用人工智能(AGI)的六个层次:从Level 0的无AI状态,到Level 1的新兴AGI,表现出基本的智能任务执行能力。Level 2的胜任AGI能在多种任务上达到人类平均水平。Level 3的专家AGI则能以专家水平执行任务。Level 4的杰出AGI在多数任务上超越专家,而Level 5的超人AGI则在广泛任务上超越人类极限。这个层次结构揭示了AI发展的逐步进步和潜在风险。

在AGI的层次之上,研究者们还提出了ASI(Artificial Superintelligence)的概念,ASI通常指的是在智能方面超越人类的AI,不仅在某个特定领域,而是在广泛的认知任务上超越。ASI能够进行自我改进和自我增强,有可能发展出人类难以理解的复杂思维模式。ASI更多是一个理论概念,目前还未有实际存在的系统。

这些概念和不同的层次让我们了解到人工智能到达的不同阶段,不过,AGI到底是什么样的,可能我们也需要真的“看到它”才能搞清楚。

好文章,需要你的鼓励

Windows正在成为AI智能体的操作系统

微软在Ignite 2025大会上预览了Windows的重要更新,显示出操作系统向支持AI智能体的根本性转变。新增功能包括原生支持模型上下文协议(MCP)、智能体连接器注册表、明确的权限管控模型,以及独立的智能体工作空间。这些更新建立了OS级别的身份验证、授权和审计机制,让智能体能够安全地执行文件操作和系统设置等任务,同时保持可控性和可追溯性。

EPFL研究团队创造“错误循环利用“技术:让AI视频生成突破时长限制,实现无限时长创作

瑞士洛桑联邦理工学院研究团队开发出"稳定视频无限"技术,通过创新的"错误循环利用"方法解决了AI视频生成长度限制问题。该技术让AI在训练时主动学习处理各种错误,从而能够生成任意长度的高质量视频内容,支持复杂场景转换和多模态控制,为内容创作、教育和娱乐行业带来revolutionary变革。

macOS Tahoe 26.2支持Mac集群组建AI超级计算机

苹果即将发布的macOS Tahoe 26.2系统将支持通过雷雳5连接多台Mac设备,构建低延迟AI超算集群。该功能支持Mac Studio、M4 Pro Mac mini和MacBook Pro等设备。四台Mac Studio可高效运行万亿参数的Kimi-K2-Thinking模型,功耗不到500瓦,比传统GPU集群低10倍。此外,MLX项目将获得M5芯片神经加速器的完整访问权限。

华为诺亚实验室:让AI像人类一样从数据中学到“好“与“坏“的智能训练新方法

华为诺亚实验室等机构联合提出了一种创新的AI训练方法,通过双层优化框架让AI从数据中自动学习评价标准。该方法结合了传统最大似然估计和强化学习的优势,在表格分类和模型驱动强化学习任务中展现出更好的收敛性和泛化能力,为解决强化学习中缺乏明确奖励信号的问题提供了新思路。