AI芯片算力基础及关键参数

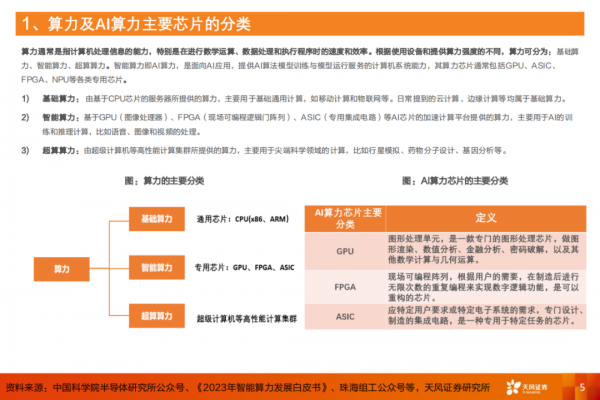

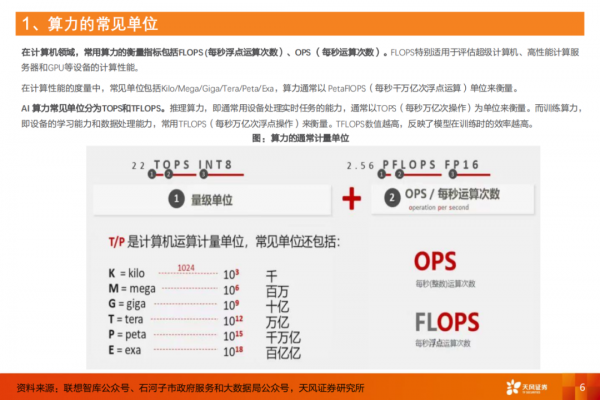

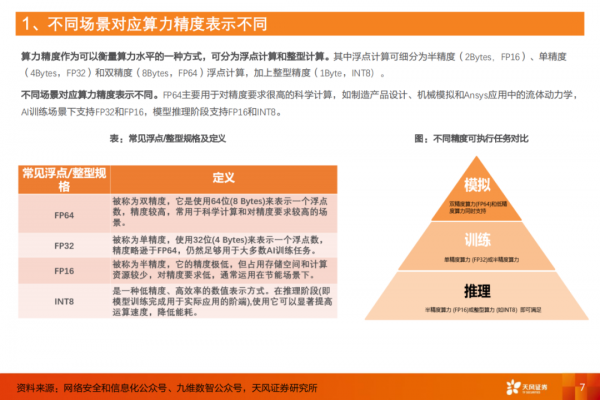

AI芯片的基础关键参数”,算力是衡量计算机处理信息能力的重要指标,其中AI算力专注于AI应用,常见单位为TOPS和TFLOPS,通过GPU、ASIC、FPGA等专用芯片提供算法模型训练和推理。算力精度作为衡量算力水平的一种方式,其中FP16、FP32应用于模型训练,FP16、INT8应用于模型推理。

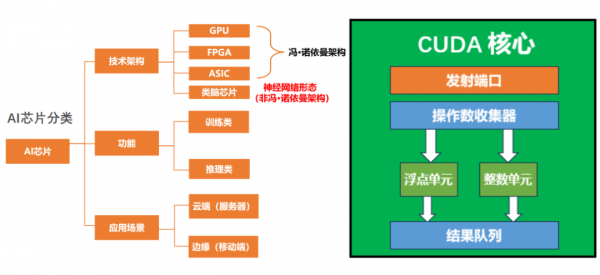

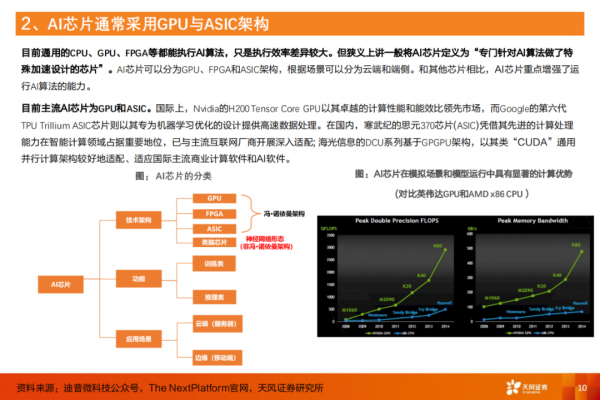

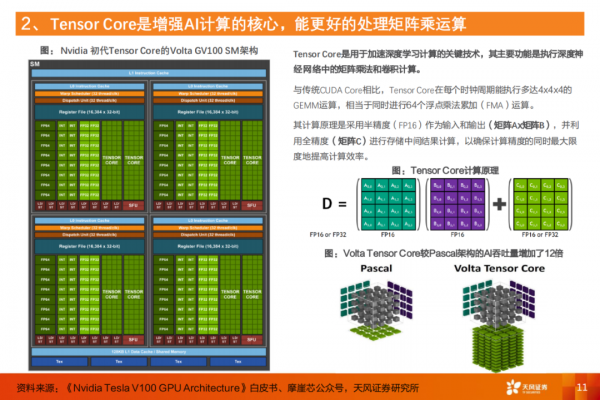

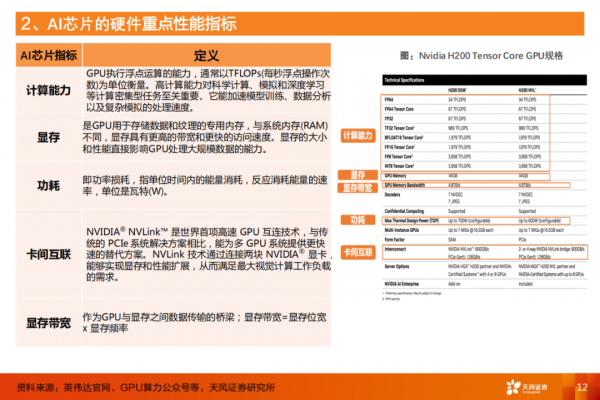

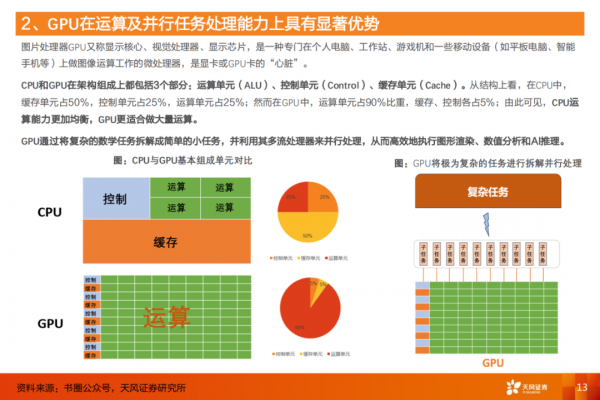

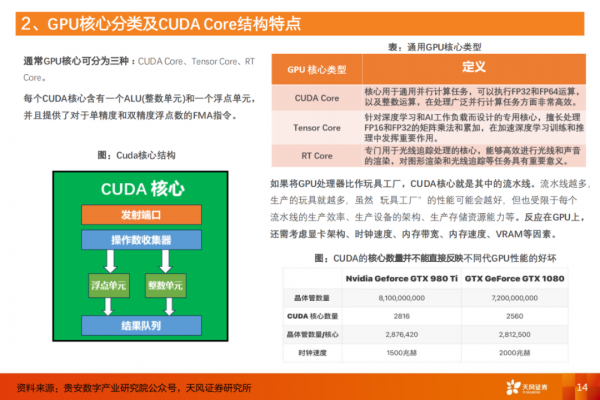

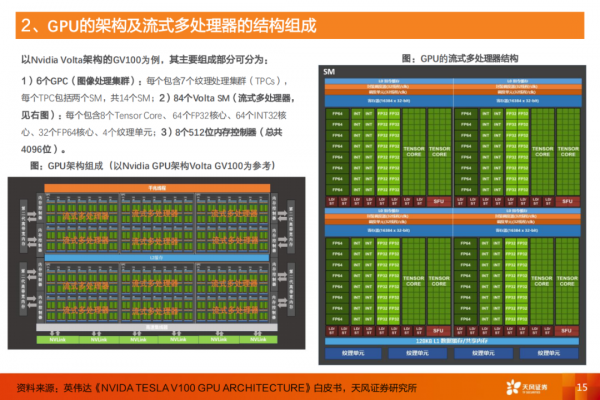

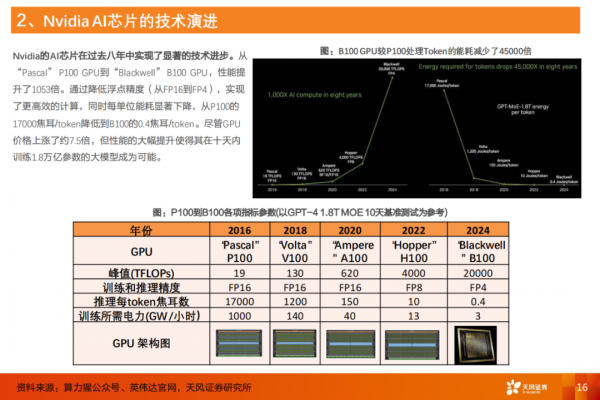

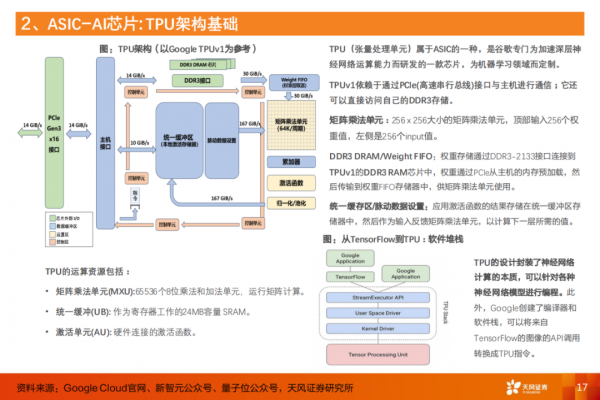

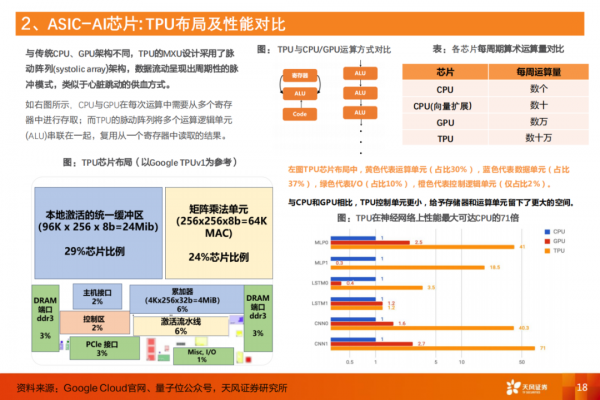

AI芯片通常采用GPU和ASIC架构。GPU因其在运算和并行任务处理上的优势成为AI计算中的关键组件,它的算力和显存、带宽决定了GPU的运算能力。GPU的核心可分为CudaCore、Tensor Core等;Tensor Core是增强AI计算的核心,相较于并行计算表现卓越的Cuda Core,它更专注于深度学习领域,通过优化矩阵运算来加速AI深度学习的训练和推理任务,其中Nvidia Volta Tensor Core架构较Pascal架构(Cuda Core) 的AI吞吐量增加了12倍。此外,TPU作为ASIC的一种专为机器学习设计的AI芯片,相比于CPU、GPU,其在机器学习任务中的高能效脱颖而出,其中TPU v1在神经网络性能上最大可达同时期CPU的71倍、GPU的2.7倍。

好文章,需要你的鼓励

伊斯法罕大学研究团队揭秘:AI教育应用如何在数字化教学时代赢得用户青睐

伊斯法罕大学研究团队通过分析Google Play商店21款AI教育应用的用户评论,发现作业辅导类应用获得超80%正面评价,而语言学习和管理系统类应用表现较差。用户赞赏AI工具的快速响应和个性化指导,但抱怨收费过高、准确性不稳定等问题。研究建议开发者关注自适应个性化,政策制定者建立相关规范,未来发展方向为混合AI-人类模型。

Google发布Gemini 3 Flash并将其设为默认模型

谷歌发布基于Gemini 3的快速低成本模型Flash,并将其设为Gemini应用和AI搜索的默认模型。新模型在多项基准测试中表现优异,在MMMU-Pro多模态推理测试中得分81.2%超越所有竞品。该模型已向全球用户开放,并通过Vertex AI和API向企业及开发者提供服务。定价为每百万输入token 0.5美元,输出token 3美元,速度比2.5 Pro快三倍且更节省token用量。

伊利诺伊大学香槟分校团队揭秘:如何在数据海洋中精准找到“最对胃口“的训练素材

这项由伊利诺伊大学香槟分校等四所院校联合完成的研究,提出了名为DaSH的层次化数据选择方法。该方法突破了传统数据选择只关注单个样本的局限,通过建模数据的天然层次结构,实现了更智能高效的数据集选择。在两个公开基准测试中,DaSH相比现有方法提升了高达26.2%的准确率,同时大幅减少了所需的探索步数。