伊利亚·苏茨克沃尔:预训练时代即将终结,接下来是能推理且有自我意识的“超级智能”

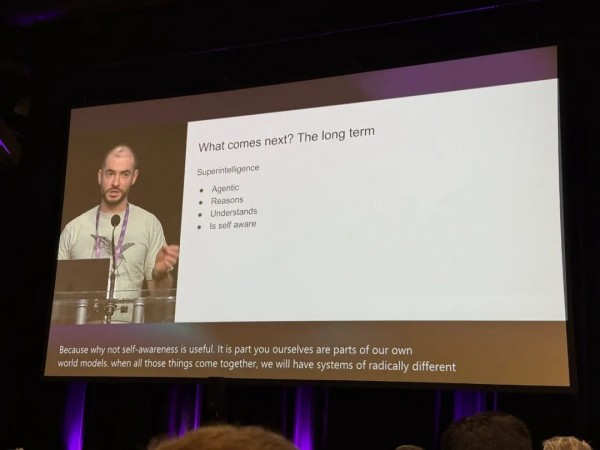

伊利亚·苏茨克沃尔(Ilya Sutskever)在加拿大温哥华举行的NeurIPS 2024大会上发表了题为“神经网络的序列到序列学习:十年之变”的演讲。在演讲中,伊利亚表示,“我们所知道的预训练将终结",接下来将是超级智能:具备智能体性质、能推理、能理解且有自我意识。

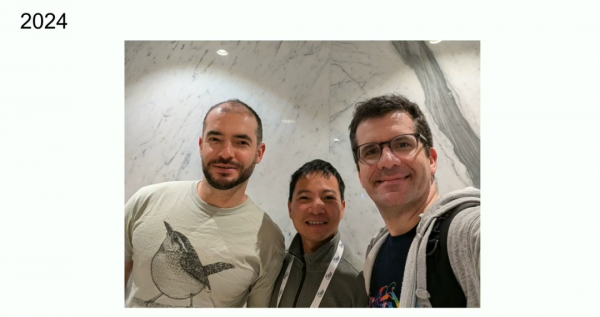

伊利亚因2014年与Oriol Vinyals、Quoc Le共同撰写的“神经网络的序列到序列学习”论文,获得了NeurIPS 2024时间检验奖。该论文引入的编码器-解码器架构,使用多层长短期记忆网络(LSTM)将输入序列映射到固定维度的向量,再从向量解码目标序列,极大地拓展了自然语言处理的边界,为序列到序列的任务提供了一种高效的方法,是自然语言处理及机器学习领域的重要基石。

在演讲中,伊利亚详细介绍了过去十年在人工智能领域的研究工作。早期的工作中,他们致力于训练基于文本的自回归模型。当时,深度学习领域流传着一种假说:如果拥有一个庞大的神经网络,尤其是多层结构的神经网络,那么它就具备在瞬间完成人类所做之事的能力。这种能力涵盖了多个方面,无论是复杂的语言理解、逻辑推理,还是各种信息处理任务,都可以在瞬间被大型神经网络所执行。

自回归模型在当时是一项创新性的技术探索,其核心原理在于,如果模型能够精准地预测下一个词,那么它就有能力把握后续整个序列的正确分布。这一理念突破了以往对于模型预测能力的认知局限,为模型在语言处理等任务上提供了新的思路和方法。在实际应用方面,他们将这一模型应用于翻译任务,通过模型对语言序列的准确把握,实现了高效、精准的翻译效果。

回顾早期的技术手段,他们采用了LSDM以及预用并行化(pipelining)技术。虽然在如今的技术视角下,pipelining技术并非最佳选择,但在当时的技术条件下,它却发挥了重要作用。通过使用8个GPU,他们成功实现了3.5倍的加速,这在当时极大地提高了模型的训练和运行效率,为研究工作的推进提供了有力支持。

早期研究得出的结论对于后续人工智能的发展产生了深远影响。当时的研究发现,当数据集规模足够大,并且神经网络足够庞大时,成功几乎成为一种必然结果。这一结论为后续的研究工作奠定了重要基础,直接推动了预训练时代的到来。在预训练时代,GPT系列模型等得以蓬勃发展,这些模型不断拓展了人工智能在自然语言处理等领域的能力边界,使得人工智能在处理复杂任务时能够更加智能、高效,从而在各个领域得到广泛应用。

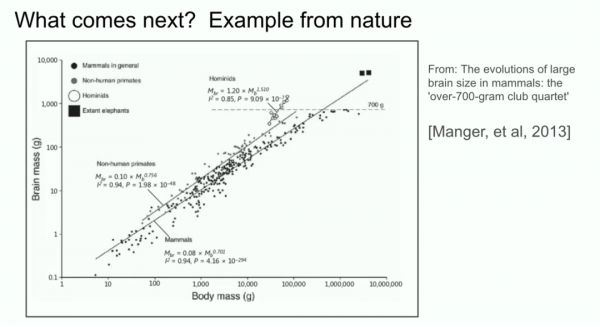

计算能力在不断地飞速提升,但是数据的来源主要依赖于互联网,相对单一且有限。互联网虽然蕴含着丰富的信息,但从本质上来说,它是一个相对封闭的体系,我们目前仅能从这一个互联网获取数据。随着时间的推移,互联网上的数据增长速度逐渐放缓,已经趋近于峰值状态,可用于训练模型的新数据越来越少。一旦数据增长停滞,预训练模型的进一步优化和发展将受到极大的制约,预训练时代也可能因此走向终结。

面对这一挑战,研究人员开始积极探索不同的发展方向。其中,“代理”概念备受关注,有望赋予模型更高级的智能和自主性,使其能够像智能体一样在复杂环境中进行决策和行动。合成数据也是一个重要的研究方向,通过人工合成数据的方式来补充有限的真实数据,为模型训练提供更多的素材。推理时计算则聚焦于优化模型在推理阶段的计算过程,提高效率和准确性,OpenAI的o1模型就是在这方面的一个尝试,它展示了人们在探索预训练后发展方向上的努力和创新。这些探索方向都为人工智能的未来发展提供了新的思路,有望突破当前预训练时代面临的数据瓶颈,推动人工智能技术迈向新的阶段。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。