Kimi 发布视觉思考模型 k1

关于「Kimi 视觉思考版」这一强化学习下的新势力选手:可以完整呈现推理思维链CoT,让用户不只看到答题结果,也能完整看到模型思索答案的全过程。

再概括下 k1 视觉思考模型的训练过程

1、训练阶段划分:本质上还是预训练及基于预训练模型后的强化学习后训练,这两个阶段

2、基础模型特点

- 重点优化字符识别能力

- 在多个基准测试集上取得卓越成绩:如OCRBench:903分(SOTA);

3、强化学习后训练 - 划重点:强化学习后训练在数据质量和学习效率方面做了进一步优化

4、科学测试集创新

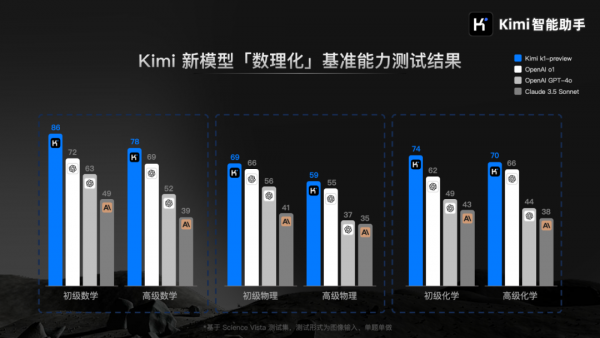

- 自主构建 Science Vista 测试集:覆盖不同难度的数理化图片题目;其分布与用户需求匹配

以下是Kimi官方的解数学题的demo:

除了数学能力,Kimi还展示了 k1 视觉思考模型解答经典物理电路题的例子:

看到这里,还留下了一个问题:

你认为Kimi的「视觉思考模型」,对哪个大模型对手产生的威胁最大呢?

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。