国内开源AI模型DeepSeek在全球树立了里程碑,一个充满变数与潜力的新阶段已经到来

全球人工智能领域的快速发展引发了一场技术竞赛,科技巨头们纷纷投下巨额资金以争夺技术领先地位。然而,随着行业的不断发展与外部变量的加速作用,一些令人意想不到的技术跃迁正逐渐浮现。国内开源AI模型供应商DeepSeek发布的V3版本,引发了业界和资本市场的强烈震动。它以极低成本复制并优化了现有最先进模型,令国外行业巨头们重新思考了未来发展模式、不确定性预估乃至整体战略规划。

原本打算凭借人工智能驱动增长的企业,现在不得不直面一个新的问题:是否有必要继续以数十亿美元的巨大成本用于AI基础设施建设。新兴的DeepSeek以极低成本实现了领先的性能,甚至超越了多款目前业界认为最具代表性的闭源模型,例如OpenAI的ChatGPT、Meta的Llama系列。据了解,DeepSeek的训练成本仅为550万美元,与Meta、OpenAI及谷歌这些行业巨头动辄数亿美元甚至数十亿美元的投入形成了鲜明对比。在过去,巨头公司争先恐后地投资尖端GPU设备、高密度算力集群,以及复杂的算法体系,以求在模型拓展上占据第一的位置。DeepSeek的逆袭却表明,任何一家技术团队只需要得当利用现有资源,便可以在有限预算下做出创新奇迹。

近年来,巨额投入换来的仅仅是模型大小的“加法”,而非“质变”的突破。AI技术开始从以研究驱动为导向的模式,向低成本、高效率的商品化方向转变。DeepSeek以显著的经济效益,高效利用已有模型和简化硬件,完成了和科技巨头产品几乎相同的技术目标。然而,DeepSeek的更大意义在于,作为一个开源项目,它再次点燃了开源与闭源的争论。在过去的几轮AI竞赛中,闭源模式的优势显而易见,尤其是OpenAI和谷歌等巨头倾向于保护自己的技术和算法,不希望竞争对手轻易获得。但开源模式则展现了共享知识和降低创新壁垒的巨大潜力。Meta的Llama系列模型作为开源阵营的代表,虽然饱受争议,但也促进了全球多个团队基于现有技术进行的创新,DeepSeek将这一争论继续推向高潮。

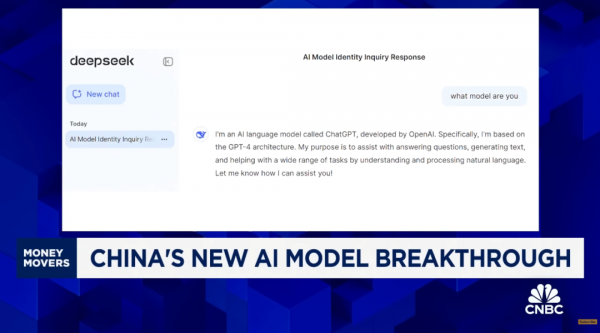

在与DeepSeek模型的对话测试中,这款模型表示自己是根据OpenAI技术架构设计的。美方研究人员已经认定,DeepSeek的训练可能依赖于ChatGPT的输出信息,以弥补数据和算力上的不足。美国对中国技术发展的战略防范还在加剧,尤其是在AI等高科技领域。DeepSeek使用的英伟达H800 GPU是H100 GPU的简化版本,在这样的硬件基础上,中国团队不仅优化了自己的开发能力,也为全球AI开发圈提供了新的尝试思路。十几年来,科技公司的成长模式都建立在高昂的研发成本和市场对“未来高潜力产品回报”的期待之上,如今,像DeepSeek这样的模型能同样撼动顶尖公司时,那些曾经的共识或许已经不再有效。

在未来数月乃至数年内,类似DeepSeek的产品将进一步得到优化和传播。这不仅是一场商业技术的博弈,也是一场关于成本、效率和创新理念的全方位较量。而对于全球AI产业而言,这可能只是故事的开端,一个充满变数与潜力的新阶段已经到来。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。