Dynamic GPU Fractions(动态 GPU 分配),知多少?

—01 —

如何理解动态 GPU 分配(Dynamic GPU Fractions)?

众所周知,随着人工智能技术的蓬勃发展,各行业对高性能计算资源的需求呈指数级增长,图形处理器(GPU)作为加速 AI 计算的关键硬件,其需求尤为突出。然而,如何在确保 AI 工作负载高性能运行的同时,最大限度地降低 GPU 资源的使用成本,仍然是业界面临的重要挑战。

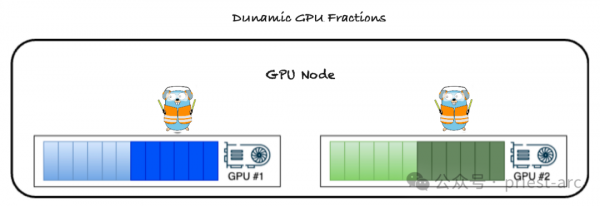

为了有效解决这一难题,业界推出了两项突破性的功能:动态 GPU 分配(Dynamic GPU Fractions) 和 节点级调度器(Node Level Scheduler),旨在从根本上优化 GPU 资源利用率,并显著提升 AI 工作负载的整体性能。

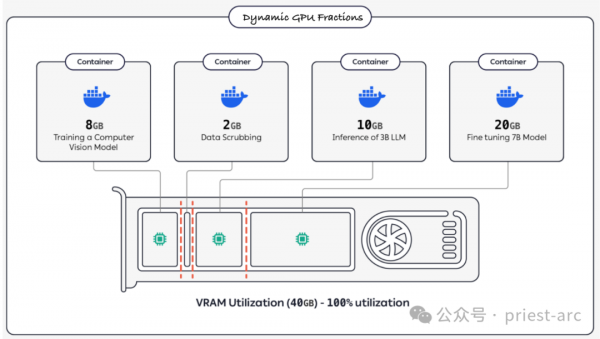

动态 GPU 分配代表了 GPU 资源管理理念的一次重大革新。传统的 GPU 资源管理方法通常采用静态分配模式,即每个工作负载在启动时被分配固定比例的 GPU 内存和计算能力。这种静态分配方式的弊端在于,当工作负载的实际 GPU 需求较低时,分配的资源将处于闲置状态,造成严重的资源浪费,导致整体 GPU 利用率低下。

动态 GPU 分配则彻底改变了这一现状。它允许 AI 工作负载根据其 瞬时 需求动态地请求 GPU 资源,从而实现了按需分配、弹性伸缩的资源管理模式。通常而言,动态 GPU 分配的核心机制是允许用户为每个工作负载指定两个关键参数:

1、GPU 分配比例(GPU Fraction): 即表示工作负载保证获得的最小 GPU 资源比例。

2、GPU 利用率上限(GPU Limit): 即表示工作负载 最多 可以使用的 GPU 资源比例。

打个比方,在我们实际的业务场景中,可能会依据业务需求需要为一个工作负载配置 0.25 的 GPU 分配比例,同时设置 0.80 的 GPU 利用率上限。那么,这意味着该工作负载将至少获得 25% 的 GPU 资源,以确保其基本运行需求得到满足。

同时,如果 GPU 资源有剩余,该工作负载还可以 动态地 扩展其资源使用量,最高可达 80%,从而充分利用可用的 GPU 算力,显著提升计算效率。这种弹性机制避免了资源闲置,最大程度地提高了 GPU 的整体利用率,并降低了运营成本。

—02 —

动态 GPU 分配(Dynamic GPU Fractions)特性解析

通常而言,动态 GPU 分配技术为用户带来了多方面的显著优势,不仅在资源管理上表现优异,同时也极大地提升了 AI 工作负载的性能和灵活性。以下为针对该技术的核心优势解析:

1、资源利用率最大化

动态 GPU 分配根据工作负载的实时需求动态调整 GPU 资源的分配,确保了资源的最优利用率。这种方式有效避免了 GPU 资源的浪费,大幅提升了整体计算效率。对于企业而言,这不仅能够显著降低 GPU 基础设施的运营成本,还能最大限度地提高投资回报率(ROI),实现资源的精细化管理和价值最大化。

2、加速执行与提升生产力

动态分配 GPU 资源使工作负载能够在需要时迅速获取所需资源,从而优化整体性能并减少任务执行中的延迟。这种方式显著缩短了 AI 应用与模型的执行时间,使得任务处理更加高效。同时,进一步提升了开发人员和数据科学团队的生产力,使其能够更专注于创新与问题解决,而非受限于资源瓶颈。

3、灵活性与可扩展性

借助按需动态请求 GPU 资源的能力,用户可以根据业务需求的变化快速调整计算资源。无论是突发的高性能需求还是长周期的大规模任务,动态 GPU 分配都能够轻松应对,为组织提供了高度的灵活性和可扩展性,使得 AI 项目可以在不牺牲性能的前提下无缝扩展,从而帮助企业更好地适应复杂多变的业务环境。

4、平滑切换 GPU 资源归属

动态 GPU 分配还支持灵活调整 GPU 资源的使用归属。例如,在确保笔记本(notebook)保持运行的前提下,可以将未使用的 GPU 从当前笔记本中释放出来,用于分配给其他更需要资源的任务。这样一来,用户不仅可以继续无缝使用交互式笔记本,还能够通过释放闲置资源为其他高优先级任务提供算力支持。这种资源调度的灵活性确保了用户体验的流畅性,同时极大地提升了 GPU 集群的整体利用效率。

动态 GPU 分配技术通过上述相关特性,为用户提供了全面的技术支持。在 AI 和高性能计算的快速发展中,这一创新性解决方案将帮助企业更高效地管理其计算资源,降低成本并加速创新步伐。无论是对单一用户还是整个组织而言,动态 GPU 分配都将成为释放 AI 潜能、推动业务成功的强大助力。

—03 —

动态 GPU 分配(Dynamic GPU Fractions)技术的一点见解

动态 GPU 分配(Dynamic GPU Fractions)技术正处于快速发展阶段,其未来发展趋势主要集中在以下几个方面,旨在进一步提升效率、灵活性和易用性,具体可参考如下所示:

1、更精细化的资源分配与调度

主要集中在以下2点,具体可参考:

一是“细粒度资源切分”层面:未来的动态分配技术将不仅仅局限于粗粒度的 GPU 划分,而是能够实现更细粒度的资源切分,例如更小比例的 GPU 算力、显存甚至更底层的计算单元(如 CUDA 核心)的分配。这将更好地满足不同规模和类型工作负载的需求,最大程度地减少资源浪费。

二是“智能化的调度策略”层面:结合人工智能和机器学习技术,开发更加智能化的调度策略,能够根据工作负载的实时特征(例如计算密集型、内存密集型等)和历史运行数据,动态预测资源需求并进行优化分配。例如,利用强化学习算法训练调度器,使其能够自适应地调整分配策略,以达到最佳的性能和资源利用率。

2、与云原生技术的深度融合

这里面,主要体现在Kubernetes 的原生支持层面。无论是原生的Kubernetes编排系统,还是 2 次改良的编排系统,亦或是各大厂商所拥有的商业编排系统,终归将动态 GPU 分配深度集成到 Kubernetes 等容器编排系统中,实现对 GPU 资源的统一管理和调度。从而将简化 GPU 资源的部署和管理,并提高容器化应用的可移植性和弹性。

例如,通过 Kubernetes 的扩展机制,实现基于 CRD(Custom Resource Definitions)的 GPU 资源描述和管理,并利用 Operator 模式自动化 GPU 资源的分配和回收。

3、支持异构计算环境:

基于不同的计算环境,扩展动态 GPU 分配技术,使其能够支持不同架构的 GPU 硬件(例如 NVIDIA、AMD、Intel 等),以及 CPU、FPGA 等其他加速器,实现异构计算环境下的统一资源管理和调度。这将为用户提供更大的灵活性和选择空间,并提高整体系统的性能和效率。

4、动态 GPU 分配技术的生态化

动态 GPU 分配(Dynamic GPU Fractions)技术的生态化建设是其走向成熟和广泛应用的关键。一个健康的生态系统能够促进技术创新、降低用户使用门槛、并加速市场普及。

随着人工智能(AI)和高性能计算(HPC)的快速发展,GPU 资源需求呈指数级增长,动态 GPU 分配(Dynamic GPU Fractions)技术凭借其灵活性和高效性,正在成为下一代 GPU 资源管理的重要方向。实现动态 GPU 分配技术的生态化,不仅需要技术本身的优化,还需要围绕其建立完整的协作环境和应用场景,以充分释放其潜能,为用户和开发者创造更大价值。

因此,从某种意义上而言,动态 GPU 分配技术的生态化发展,是推动 AI 计算资源高效管理的必然趋势。从与容器编排系统、AI 框架、可观测性工具的整合,到在多样化应用场景中的广泛应用,动态 GPU 分配正逐步成为 GPU 资源管理的核心解决方案。未来,随着技术的持续优化和生态的逐步完善,其在高性能计算领域的价值将愈发显著,为企业和开发者带来更多可能性和创新空间。

综上所述,动态 GPU 分配和节点级调度器的推出,不仅填补了现有 GPU 管理机制的空白,更为 GPU 资源的精细化管理和智能化调度提供了全新的解决方案。这些功能的实施,不仅能够帮助企业在提升 AI 工作负载性能的同时显著降低运营成本,还为未来的 GPU 技术演进和应用场景拓展奠定了坚实基础。

在当前 GPU 需求日益增长的背景下,这些创新技术将助力用户更加高效地利用有限的计算资源,从而在竞争日益激烈的人工智能时代中脱颖而出。通过这种开创性的资源调度方法,我们希望为业界树立新的技术标杆,推动高性能计算领域的持续发展和革新。

Happy Coding ~

Reference :

[1] https://clear.ml/docs/latest/docs/clearml_agent/clearml_agent_fractional_gpus/

[2] https://www.run.ai

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。