里通义开源音频生成模型,能模仿音效师为视频配音

7月1日消息,阿里通义实验室开源了旗下首个音频生成模型ThinkSound,该模型首次将CoT(Chain-of-Thought,思维链)应用到音频生成领域,让AI可以像专业音效师一样逐步思考,捕捉视觉细节,生成与画面同步的高保真音频。

目前,ThinkSound的代码和模型已在Github、HuggingFace、魔搭社区开源,开发者可免费下载和体验。

阿里开源音频生成模型ThinkSound

视频生成音频(V2A)技术是多媒体编辑和视频内容创作领域最重要的技术之一,但该技术的发展速度仍存在诸多技术挑战,例如业界现有的V2A技术仍缺乏对视觉对应声学细节的深入理解,导致生成的音频较为通用,甚至与关键视觉事件错位,难以满足专业创意场景中对时序和语义连贯性的严格要求。

为了解决现有视频转音频技术难以捕捉画面中动态细节和时序的难题,通义团队首次将思维链推理引入多模态大模型,可以模仿人类音效师的多阶段创作流程,实现对视觉事件与相应声音之间深度关联的精准建模,例如先分析视觉动态、再推断声学属性,最后按照时间顺序合成与环境相符的音效。不仅如此,该团队还构建了首个带思维链标注的音频数据集AudioCoT,该数据集融合了2531.8小时的多源异构数据,让模型在音频生成与编辑任务时做到“知其然、知其所以然”。

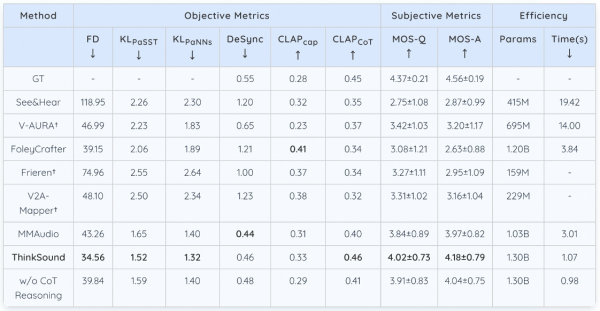

在开源的VGGSound测试集上,ThinkSound的核心指标相比MMAudio、V2A-Mappe、V-AURA等现有主流方法均实现了15%以上的提升。例如,在openl3空间中Fréchet 距离(FD)上,ThinkSound 相比 MMAudio的43.26 降至34.56(越低越好),接近真实音频分布的相似度提高了20%以上;在代表模型对声音事件类别和特征判别精准度的KLPaSST 和 KLPaNNs两项指标上分别取得了1.52和1.32的成绩,均为同类模型最佳。

在开源的VGGSound测试集上,ThinkSound多项核心指标位居第一

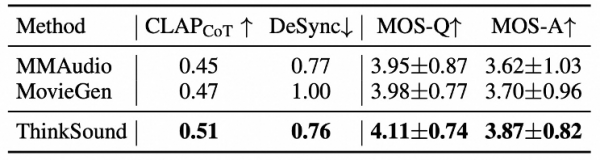

在MovieGen Audio Bench测试集上,ThinkSound的表现大幅领先Meta推出的音频生成模型Movie Gen Audio,展现了模型在影视音效、音频后期、游戏与虚拟现实音效生成等领域的应用潜力。

ThinkSound大幅领先Meta旗下Movie Gen Audio

目前,通义实验室已推出语音生成大模型 Cosyvoice、端到端音频多模态大模型MinMo等模型,全面覆盖语音合成、音频生成、音频理解等场景。

好文章,需要你的鼓励

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

谷歌Agent Development Kit(ADK)革新了AI应用开发模式,采用事件驱动的运行时架构,将代理、工具和持久化状态整合为统一应用。ADK以Runner为核心,通过事件循环处理用户请求、模型调用和外部工具执行。执行逻辑层管理LLM调用和工具回调,服务层提供会话、文件存储等持久化能力。这种架构支持多步推理、实时反馈和状态管理,为构建超越简单聊天界面的生产级AI应用提供了完整框架。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

苹果在iOS 26中推出全新游戏应用,为iPhone、iPad和Mac用户提供个性化的游戏中心。该应用包含五个主要版块:主页展示最近游戏和推荐内容,Arcade专区提供超过200款无广告游戏,好友功能显示Game Center动态并支持游戏挑战,资料库可浏览已安装游戏并提供筛选选项,搜索功能支持按类别浏览。iOS 26.2版本还增加了游戏手柄导航支持,为游戏玩家提供更便捷的操作体验。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

Sleepbuds制造商Ozlo如何构建睡眠数据平台

CES 2026推出AI伴侣机器人Emily

苹果2026年将发布四款新iPhone机型预览

AGI-Next峰会全记录解读:Kimi、Qwen、智谱、腾讯同台,2026年有新范式是共识,中国引领AI概率最低预测2成

Anthropic推出医疗健康功能助力患者理解病历记录

Google推出通用商务协议,推动智能体购物自动化

核电初创公司携小型反应堆回归,面临重大挑战

谷歌针对部分医疗查询移除AI概览功能

Motional采用AI优先策略重启无人驾驶出租车计划

新年存储升级:三星SSD优惠最高减免100美元