Unsloth微调Llama3-8B,提速44.35%,节省42.58%显存,最少仅需7.75GB显存

01

前言

本文主要介绍Unsloth,它可以显著提升大模型的训练速度,减少显存占用,我们将其整合到Firefly训练框架中,实现对Llama3、Llama2、Mistral、Gemma、Zephyr等模型训练的「降本增速」。

我们实测了Unsloth所带来的训练增益,对Llama3-8B进行QLoRA训练,最少仅需7.75GB显存,这意味着我们可以在一张1080Ti上训练Llama3-8B,进一步降低了大模型训练的硬件门槛。开启Unsloth后,Llama3-8B的训练速度可提升44.35%,训练时间可减少30.72%,显存占用可减少42.58%。更详细的测试设置可参考第三节。

Firefly项目链接:

https://github.com/yangjianxin1/Firefly

Unsloth项目链接:

https://github.com/unslothai/unsloth

02

Unsloth简介

Unsloth是一个开源的大模型训练加速项目,使用OpenAI的Triton对模型的计算过程进行重写,大幅提升模型的训练速度,降低训练中的显存占用。Unsloth能够保证重写后的模型计算的一致性,实现中不存在近似计算,模型训练的精度损失为零。Unsloth支持绝大多数主流的GPU设备,包括V100, T4, Titan V, RTX 20, 30, 40x, A100, H100, L40等,支持对LoRA和QLoRA的训练加速和高效显存管理,支持Flash Attention。

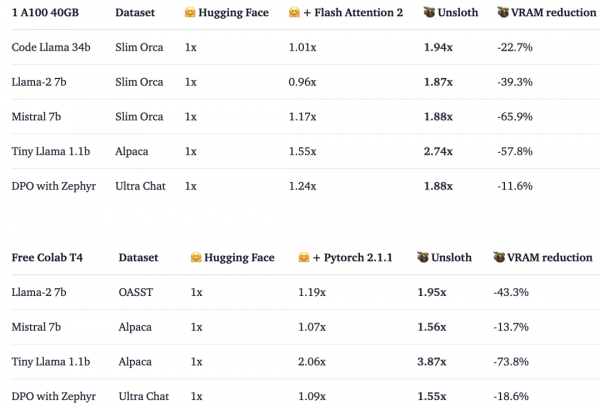

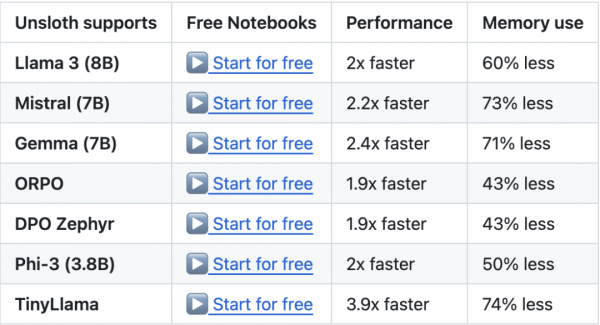

Unsloth对大模型的训练提升如下图所示。在一张A100上,使用QLoRA对不同的模型进行训练,Llama2-7B的训练速度是原来的1.87倍,显存占用减少39.3%,Mistral-7B的训练速度是原来的1.88倍,显存占用减少65.9%。在无精度损失的前提下,Unsloth对大模型训练具有显著的「降本增速」作用,可谓是「免费的午餐」。

更重要的是,Unsloth与HuggingFace生态兼容,可以很容易将其与transformers、peft、trl等代码库进行结合,以实现模型的SFT与DPO,仅需修改模型的加载方式即可,无需对此前的训练代码进行过多的修改。Demo如下所示。

from unsloth import FastLanguageModel

import torchfrom trl

import SFTTrainerfrom transformers

import TrainingArguments

from datasets import load_datasetmax_seq_length = 2048

# Supports RoPE Scaling interally, so choose any!

# Get LAION dataseturl = "https://huggingface.co/datasets/laion/OIG/resolve/main/unified_chip2.jsonl"dataset = load_dataset("json", data_files = {"train" : url}, split = "train")# 4bit pre quantized models we support for 4x faster downloading + no OOMs.fourbit_models = ["unsloth/mistral-7b-bnb-4bit","unsloth/mistral-7b-instruct-v0.2-bnb-4bit","unsloth/llama-2-7b-bnb-4bit","unsloth/gemma-7b-bnb-4bit","unsloth/gemma-7b-it-bnb-4bit",

# Instruct version of Gemma 7b"unsloth/gemma-2b-bnb-4bit","unsloth/gemma-2b-it-bnb-4bit",

# Instruct version of Gemma 2b"unsloth/llama-3-8b-bnb-4bit",

# [NEW] 15 Trillion token Llama-3"unsloth/Phi-3-mini-4k-instruct-bnb-4bit",]

# More models at https://huggingface.co/unslothmodel, tokenizer = FastLanguageModel.from_pretrained(model_name = "unsloth/llama-3-8b-bnb-4bit",max_seq_length = max_seq_length,dtype = None,load_in_4bit = True,)# Do model patching and add fast LoRA weightsmodel = FastLanguageModel.get_peft_model(model,r = 16,target_modules = ["q_proj", "k_proj", "v_proj", "o_proj","gate_proj", "up_proj", "down_proj",],lora_alpha = 16,lora_dropout = 0,

# Supports any, but = 0 is optimizedbias = "none",

# Supports any, but = "none" is optimized# [NEW] "unsloth" uses 30% less VRAM, fits 2x larger batch sizes!use_gradient_checkpointing = "unsloth",

# True or "unsloth" for very long contextrandom_state = 3407,max_seq_length = max_seq_length,use_rslora = False, # We support rank stabilized LoRAloftq_config = None, # And LoftQ)trainer = SFTTrainer(model = model,train_dataset = dataset,dataset_text_field = "text",max_seq_length = max_seq_length,tokenizer = tokenizer,args = TrainingArguments(per_device_train_batch_size = 2,gradient_accumulation_steps = 4,warmup_steps = 10,max_steps = 60,fp16 = not torch.cuda.is_bf16_supported(),bf16 = torch.cuda.is_bf16_supported(),logging_steps = 1,output_dir = "outputs",optim = "adamw_8bit",seed = 3407,),)trainer.train()

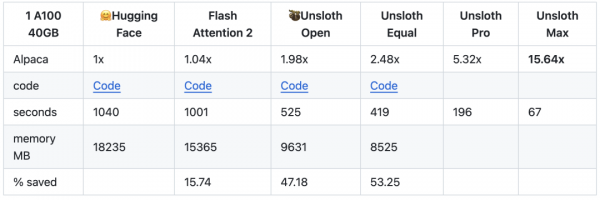

尚未开源的Unsloth Pro与Max版本,有着更强劲的训练效率的提升。

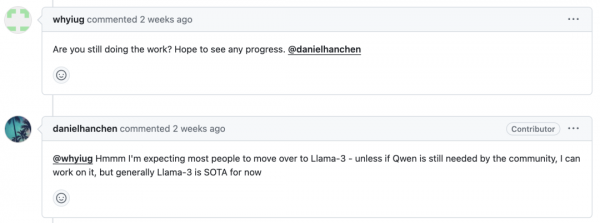

目前开源版本的Unsloth,仅支持单机单卡训练,且仅支持Llama2、Llama3、Mistral、Gemma、Zephyr、TinyLlama、Phi-3等模型。遗憾的是,Qwen2并不在Unsloth的支持列表中,该需求在Unsloth的issue中也被频繁提及。

Unsloth官方在短期内暂时没有支持Qwen2的计划,更多的是建议用户将Qwen2的权重进行Llama化,然后采用Llama的训练方式。但对Qwen2的权重进行Llama化后,模型性能有显著的下降。对于该问题,Firefly项目组也正在进行尝试,希望能够使Unsloth原生支持Qwen2,目前处于测试阶段,敬请期待。

03

Unsloth实践 & 测试

拉取Firefly代码库:

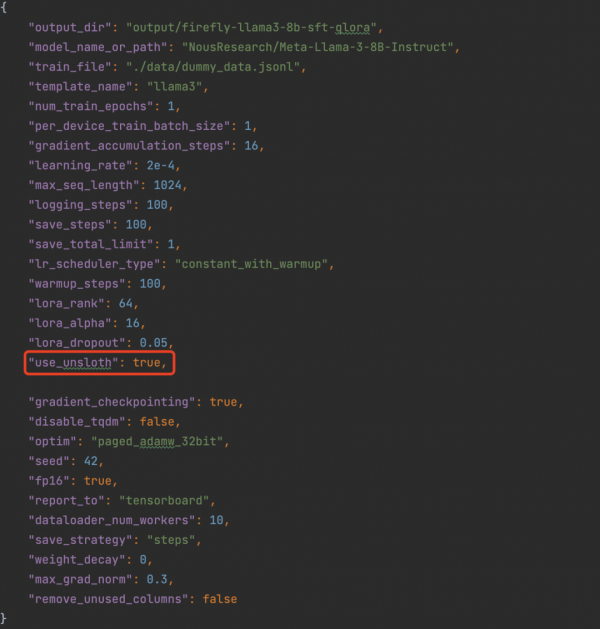

git clone https://github.com/yangjianxin1/Firefly.git在Firefly中启动Unsloth训练Llama3,仅需在训练配置文件中将use_unsloth设为true即可,use_unsloth默认为False。

pip install git+https://github.com/unslothai/unsloth.git

pip install transformers==4.37

pip install bitsandbytes==0.43.1

pip install peft==0.10.0

pip install torch==2.2.2

pip install xformers==0.0.25.post1

python train.py --train_args_file train_args/sft/qlora/llama3-8b-sft-qlora.json

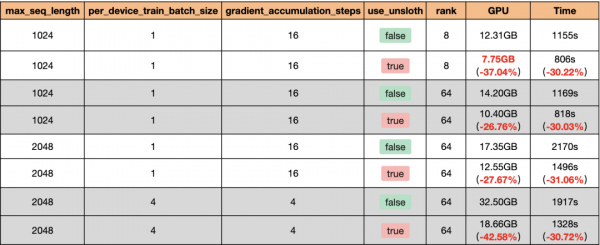

我们在一张V100上对Llama3-8B进行QLoRA训练,使用相同的数据集训练50步,开启gradient_checkpointing,每条数据均padding至max_seq_length,在所有linear层均插入adapter,由于V100不支持Flash Attention,所以本测试未开启Flash Attention。Unsloth所带来的训练增益如下表所示。

结合QLoRA与Unsloth训练Llama3-8B,最少仅需7.75GB显存,开启Unsloth后,Llama3-8B的训练速度可提升44.35%,训练时间可减少30.72%,显存占用可减少42.58%。当max_seq_length或者per_device_train_batch_size增大时,Unsloth节省显存的优势更加明显。

从上述结果来看,Unsloth对于训练加速和节省显存的效果非常显著,我们也正在对Unsloth支持Qwen2的工作进行尝试。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。