为什么“AI盲”问题普遍存在?

时至今日,公众、政策制定者、记者乃至大批非AI技术人员对于AI的理解都处于相当糟糕的水平。但最令人感兴趣的是,正如最近几天社交媒体上相关文章所言,非AI研究人员群体对此普遍抱持着相当统一的不屑态度,甚至根据现有深度学习方法的局限性及其对免费/低质量训练数据的依赖对AI表现出全盘否定的立场。为什么公众当中普遍存在“AI盲”问题?我们又该如何帮助大家更好地理解现代深度学习的发展现状?

几年之前,对于虚拟现实技术的任何批评之声,都被视为记者群体对于这项技术缺乏基本的尊重,甚至可以上纲上线到相关工作人员的个人修养存在缺陷。只要唱了反调,以打击与挖苦为主的报复性邮件就会不断涌来,并强调该名记者制宪对VR技术最基本的理解。无论作者投入多少年时间进行VR技术探索,还是各大受人尊敬的巨头级企业内的VR技术专家也曾提出过完全相同的问题,对VR的批评之声都会引发广泛的舆论反扑。

究其原因,硅谷非凡的洗脑能力(或者说扭曲现实的能力)使得人们相信虚拟现实终于迎来了发展的临界点。更具体地讲,在一年之内电视机就会全面消失,每个家庭都会为每一位家庭成员购置专属VR设备。

以技术为核心的扭曲现实之力绝对是个值得关注的重要议题,而且事实已经证明,其完全能够说服特定领域之外的其他技术人员放弃怀疑心态甚至是自己已经具有专业知识与常识——无论市场营销部门放出什么风声,他们都愿意照单全收。没错,企业巨头想让他们怎样思考,他们就会怎样思考。

讽刺的是,就在几年之前,很多评论作者还在积极对任何质疑VR技术的人们予以抨击;但现在,他们则强调自己一直很清楚VR只是一种小众技术。

社交媒体也一直在扭曲现实世界中的最新技术,而这种持续不断的洗脑也让媒体、政策制定者、权威人士乃至公众彻底陷入迷茫。目前,很多人开始警告称这种洗脑行为很可能彻底破坏民主这一西方社会的核心根基。

现实证据证明,社交媒体的规模都不像您想象的那么可观、速度没那么快、影响力没那么大,而且也并不可能全面取代传统媒体。然而,如果有人胆敢质疑社交媒体的重要作用,可以肯定的是,他们显然并不了解技术宣传的力量所在。

作为新时代的宠儿,如今享受这一最高礼遇的技术变成了深度学习,或者说“AI”。是的,这就是大众眼中新的神。

围绕AI技术,公众的基本理解主要可以归结为三大阵营:第一,全知全能的超人思维机器可能随时接管世界并拯救全人类;第二,无论看似多么友善无害,全知全能的超人思维机器都将彻底改变我们的生活,甚至摧毁整个人类社会;第三,AI其实只是一种有限且可靠性低下的技术,其有时候能够产生准确度超出预期的结果,但它的理论基础仅仅基于统计相关性,而并未包含实际推理中所必需的因果模型。

问题在于,虽然身处AI最前沿的技术人员已经反复强调第三种才是正确的理解,但前两种“臆想”似乎已经深深扎根于这个时代的文化基因当中——特别是第一种。

只要一说起AI,人们想到的似乎都是这项新兴技术将带领我们走向更加光明、更加安全、更加可靠且更加幸福的未来——这种全面接管世界的思维,也成了新闻媒体的主要宣传方向。

事实上,根据GDELT项目对全球65种语言网络新闻报道的监测,与AI相关的内容在过去两年中翻了一番。

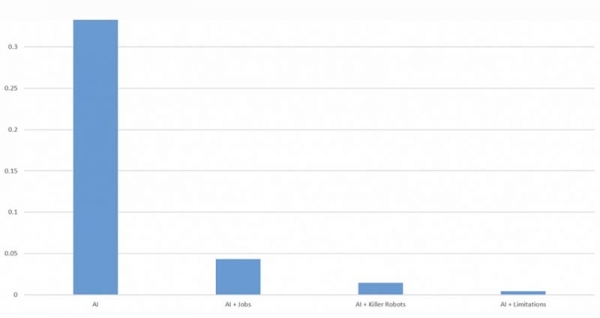

下图所示为GDELT项目对全球网络媒体报道当中,提及“人工智能”或“深度学习”关键词的内容百分比。作为对照组的,则分别为AI对就业的影响、利用AI技术构建的自主武器以及AI技术局限性。

GDELT项目对全球网络新闻中AI相关主题内容进行占比比较

很明显,关于AI议题的整体讨论(往往更倾向于营销炒作与夸大宣传,且态度一般都很积极)已经大大超过对于AI负面状况的关注,特别是局限性问题几乎很少被提及。

绝大多数技术媒体都没有建立生产级AI系统的实际经验,因此尽管实际应用AI方案的企业不断提醒称报道内容太过夸张,但却根本无济于事。

同样的,非AI技术人员在稍稍接触AI领域之后很快发现,利用几行代码加少量训练样本构建出的典型“hello world”级深度学习应用程序确实拥有不错的运行效果。这进一步带来了错误的假设,即解决当前准确性与生产级要求之间的差距并不是什么了不得的挑战。在他们看来,多准备些示例数据并加载至算法当中,就能轻松解决问题。

但问题在于,新闻从业者、政策制定者、权威人士乃至普通公众普遍属于“AI盲”水平,因此无法在是否该将更多深度学习方案引入日常生活作出明智的决定。

对他们来说,AI就像是一场盛大的魔术与狂欢,这样的思维又被各大主要AI企业的营销机器进一步放大。他们吹嘘自己的算法拥有超人类的能力表现,同时从来不提极为严苛、甚至需要以手动方式量身定制的实验室条件。在实现理想结果之前,算法到底经历了多少次失败?我们永远不会在报道中看到这方面数字。

企业通过宣传自己的成功来保持这种幻想,同时在很大程度上隐瞒自己的失败。另一方面,由于媒体与政策制定者对于AI技术知之甚少,他们甚至不知道到底该问哪些问题。

很明显,当Facebook宣传其反恐AI算法时,新闻报道当中强调的永远是该算法如何准确识别出99%的恐怖主义内容。但实际上,细心的读者会发现Facebook在描述中已经表明其删除的99%内容都是原有黑名单加简单过滤器的发现。换言之,AI根本就没有发挥什么关键性作用,真正在起效的仍然是黑名单加过滤器——但这二位没有任何话题性可言。

通过一个又一个“振奋人心”的AI成功故事,我们沉浸在不切实际的幻想当中;然而,现实中的AI尝试却往往以失败告终。当然,很少有记者真正了解AI,也不清楚Facebook到底在说些什么;他们不可能花时间追踪各大科技企业的所有公开声明、阅读学术出版物或者采访AI研究人员,因此也就不可能通过各种细节对抛出的结论加以分析。

最重要的是,Facebook公司至今仍然拒绝提供关于误报与漏报问题的基本数据,这意味着外部AI研究人员乃至政策制定者根本无法对其算法的准确性做出评估。一旦将这种漏洞百出的AI算法引入日常生活,势必给整个国家造成巨大的社会影响。

总而言之,我们太过年轻、有时天真的“AI盲”们每天都承受着媒体热烈的信息轰炸——他们赞扬AI的发展,连篇累牍地强调积极影响。而令人遗憾的是,AI自身存在的局限、潜在改进空间、准确的发展道路以及包含细节的客观对话则很少出现在人们的视野当中。

最后,我们整个人类社会正在努力建立一个能够全方位接纳AI方案的未来图景。很明显,距离对AI实际影响做出明智判断这一短期目标,我们也还有着漫长的道路要走。

唯一的问题在于,理性的话题到底能否在硅谷无缘强大的现实扭曲之力中得到应有的重视。

来源:Forbes

好文章,需要你的鼓励

苹果注重隐私的年龄验证方案可解决两大难题

美国多州和部分国家要求特定应用进行年龄验证,澳大利亚已禁止16岁以下用户使用社交媒体。新提案《应用商店问责法案》建议由苹果和谷歌负责统一验证用户年龄,而非各开发者单独验证。这将提升用户体验,用户只需向苹果或谷歌验证一次身份。凭借苹果在隐私保护方面的优势,该方案可扩展至Safari浏览器,为需要年龄验证的网站提供确认信息,而无需透露用户个人数据。

Meta AI团队首次破解多模态奖励模型评估难题,让AI既能看懂图片又能准确判断好坏

Meta AI首次发布多模态奖励评估基准MMRB2,专门评价AI同时处理文字和图像的能力。该基准包含四大任务类型共4000个专家标注样本,测试23个先进模型。结果显示最佳模型Gemini 3 Pro达75-80%准确率,仍低于人类90%水平。研究揭示AI评价存在视觉偏见等问题,为多模态AI发展提供重要参考标准。

Cursor通过收购Graphite继续扩张之路

AI编程助手Cursor背后的公司Anysphere宣布收购AI代码审查工具初创公司Graphite。据报道收购价远超Graphite今年早些时候B轮融资时2.9亿美元的估值。此次收购具有战略意义,将AI代码生成与AI代码审查工具相结合,可大幅提升从编写到交付的整体效率。Anysphere估值已达290亿美元,近期频繁收购,上月收购技术招聘公司,今年7月还收购AI客户关系管理初创公司Koala的团队。

快手推出Kling-Omni:一个AI模型搞定所有视频制作需求

快手推出的Kling-Omni是首个真正统一的AI视频制作系统,能够理解文字、图像、视频等多种输入方式,不仅可以生成视频,还能进行复杂编辑和推理。该系统通过三个核心模块的协作,实现了从创意理解到最终输出的全流程自动化,让普通用户也能制作专业水准的视频内容,代表了AI视频技术的重要突破。

联想问天 WR5220 G5服务器

联想问天 WA7880a G3服务器

苹果注重隐私的年龄验证方案可解决两大难题

Cursor通过收购Graphite继续扩张之路

ChatGPT新增个性化设置功能,用户可自定义聊天体验

Kuxiu S3固态电池充电宝替代多款充电器的全能解决方案

Waymo自动驾驶出租车遭遇交通灯故障停摆事件分析

智启未来,共筑开发者生态 AMD携手DataWhale、魔搭社区,共建ROCm开发者生态

千问C端事业群成立后首推平价AI眼镜:低至1999元,搭载千问AI助手

Aqara Hub M200为HomeKit带来Matter支持和新自动化选项

LG智能电视强制安装Copilot快捷方式引发用户不满

Palo Alto Networks与谷歌云签署数十亿美元AI合作协议

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功