谷歌:将利用TCAV技术解决人工智能及机器学习模型偏差

谷歌首席执行官Sundar Pichai表示,谷歌正在努力使旗下的人工智能和机器学习模型更加透明,以此抵御系统的偏差。

Pichai提及一系列人工智能增强技术(https://blog.google/technology/developers/io19-helpful-google- everyone /)以及将更多的机器学习模型放在设备上的举动,而对于开发人员和数据科学家而言他说的重点则在于TCAV。 TCAV是概念激活向量测试(Testing with Concept Activation Vectors)的英文缩写(https://ai.google/research/pubs/pub47077)。简而言之,TCAV是一种可解释性的方法,可用于了解神经网络模型用来预测的信号。

理论上,TCAV具有理解信号可能表现出偏差的能力(https://github.com/tensorflow/tcav),因为这些信号会强调男性是否是有别于女性,信号还会表现出其他的问题,如种族、收入和位置。计算机科学家利用TCAV就可以看到价值概念到底有多高的价值(https://arxiv.org/abs/1711.11279)。

偏差是人工智能里的一个重要概念,一些学者呼吁引进更多的自我监管和法例(https://www.zdnet.com/article/why-businesses-will-have-to-audit-algorithms-ai-and-account-for-risk/)。此外,诸如IBM一类的行业参与者也在推动更大的透明度和具有监控算法层的软件,以达到了解算法是如何产生偏见的目的(https://www.zdnet.com/article/ibm-launches-tools -to-detect-ai-fairness-bias-and-open-sources-some-code /)。而与此同时,一些企业也在向着可解释人工智能方向努力(https://www.zdnet.com/article/capital-one-ai-chief-sees-path- to-explainable-ai /)。对于谷歌来说,透明度很重要,因为谷歌的技术包括Duplex和下一代谷歌智能助理(https://www.zdnet.com/article/google-sees-next-gen-duplex- assistant-as-next-step-in-taking-over-your-tasks/ )。这些工具现在为用户执行任务时的功能越来越多。模型的透明度可能意味着对谷歌技术的更多信任和使用。

最关键的一点:透明度和防范偏差对于企业以及为我们提供大多数模型即服务的所有云提供商都至关重要(https://www.zdnet.com/article/top-cloud- providers -2019-aws-microsoft-azure-google-cloud-ibm-makes-hybrid-move-salesforce-dominates-saas/)。

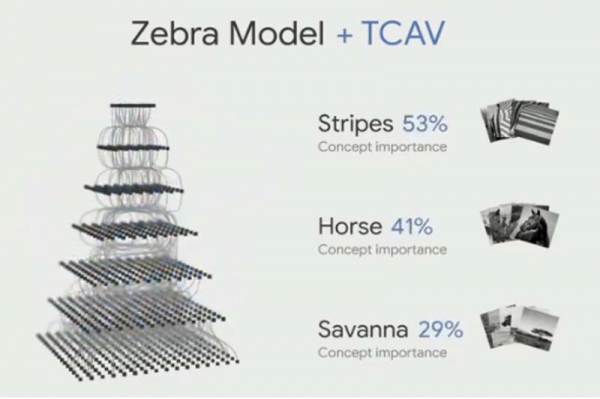

TCAV的使用不需要重新训练模型,TCAV做的是解剖模型即说明模型为何做出某种决定。例如,识别斑马的模型可以使用更高级别的概念来识别斑马。来看一个示例:

Pichai表示,“要为每个人建立一个更有帮助的谷歌就意味着解决偏差问题。你需要知道模型是如何工作的,并且清楚其中可能存在偏差。为此,我们将提高模型的透明度。”

他补充表示,谷歌的人工智能团队正在开发TCAV,这项技术可以允许模型使用更多的高级概念。TCAV的目标是将支撑模型的变量表现出来。“还有做很多的工作,但我们奉行的原则是打造适合所有人的人工智能。”Pichai表示。

由于谷歌能够将模型的大小缩小到可以驻留在设备上,谷歌现在正朝着降低延迟及使用联合学习等技术减少数据使用并增强用户隐私的方向努力。

好文章,需要你的鼓励

丰田升级SUV产品线,RAV4新增信息娱乐系统

丰田第六代RAV4搭载高通骁龙数字底盘平台,提供个性化、直观且无缝连接的驾驶体验。新车基于丰田Arene软件开发平台,推进软件定义汽车发展,配备紧急驾驶停止系统和突然加速抑制功能。车载多媒体系统支持个性化主屏幕定制和更准确的语音识别。通过与高通技术公司合作,利用先进AI技术增强用户体验,提供更智能、直观和安全的出行方案。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

可信开源软件现状报告:AI重塑技术栈基线

Chainguard发布可信开源软件季度报告,基于1800多个容器镜像项目和近5亿次构建的数据分析。报告显示:Python因AI需求成为最受欢迎的开源镜像;超半数生产环境运行在热门项目之外的长尾镜像上;98%的漏洞出现在非热门项目中,安全负担主要集中在不太显眼的技术栈部分;44%客户在生产环境中使用FIPS镜像以满足合规要求;Chainguard平均在20小时内修复关键漏洞。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SAP推出全新AI功能助力零售业数字化转型

Gmail推出个性化AI收件箱与智能搜索等多项新功能

CISA警告HPE OneView和微软Office漏洞正被活跃利用

谷歌削减Android开源代码发布频率至每年两次

高通CES 2026:扩展IE-IoT产品组合推进边缘AI发展

恩智浦发布S32N7处理器系列,加速AI驱动汽车发展

n8n自动化平台严重漏洞可让攻击者完全控制服务器

微软将在Copilot中直接集成购买按钮功能

Snowflake收购Observe拓展AI驱动监控能力

丰田升级SUV产品线,RAV4新增信息娱乐系统

可信开源软件现状报告:AI重塑技术栈基线

思科修复ISE安全漏洞,公开概念验证代码已发布

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功