极智芯 | 解读近存计算AI芯势力Groq LPU

当然,标题用了 "一语双关" 的手法,hhhh,Groq 的 LPU 是芯势力也是新势力。为啥这么说呢,说几个关键词可能会让大家更加感兴趣 ==> "推理效率较英伟达 GPU 提高 10 倍"、"近存计算"、"SRAM"。这里的整个 LPU 会 "充斥着" 近存计算、存算一体的面纱。

可能目前大家还对 Groq、对 Groq 的 LPU 不太了解,没事,我先来介绍一下 Groq。想火,"蹭热度" 可能是那个不太被推崇但又很常见的方式了,Groq 也喜欢蹭热度。在 Groq 的官网上就展示着喊话 OpenAI 奥特曼、Meta 扎克伯格、世界首富马斯克的帖子,希望这些巨头们不要只看英伟达,可以多关注一下 Groq 的 LPU。公然在自家官网上这么喊话,应该比较少见吧,感兴趣的朋友可以去看看。

Groq 当然是做 AI 芯片的公司,直接对标的就是 NVIDIA,这种定位基本就跟咱们一众国产 AI 芯片厂商类似了,对于国产 AI 芯感兴趣的朋友可以翻看一下我之前分享的解读内容《极智芯中国芯 | 全网最全解读国产AI算力产品矩阵系列》。Groq 就是致力于加速生成式 AI 的推理加速,是专门面向生成式 AI 的算法部署以达到实时推理的目标,下面是 Groq 愿景的原话:

Groq is on a mission to set the standard for GenAI inference speed, helping real-time AI applications come to life today.

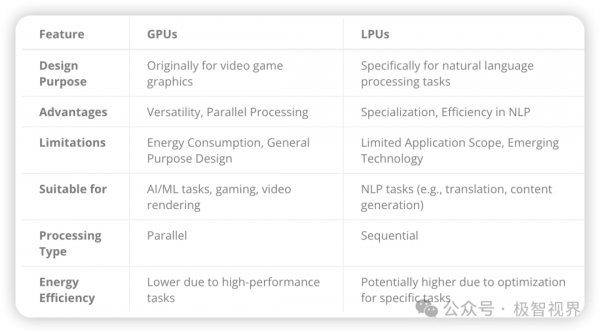

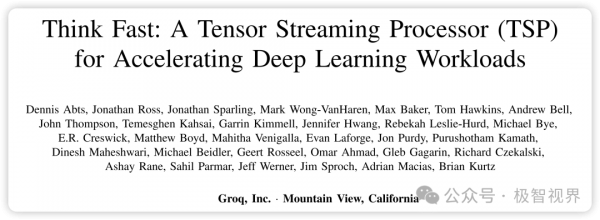

Groq,你要说它新吧,它其实还真不新,Groq 成立于 2016 年,其创始团队主要来自 Google 的 TPU,所以在 Grop 的 LPU 上肯定是会有一些 TPU 的影子。其实 Google 的 TPU 也是一种近存计算 AI 芯片,而这里的 LPU 当然也会是近存计算芯片,因为 Grop 本身就是一家近存计算芯片公司,区别只是 LPU 按目前大模型的计算特点反馈到硬件上,将硬件做成了更加适配现在大模型计算特性的样子,所以 LPU 是会比 TPU 更加特定域的 AI 芯片,所以也就有了 Groq 愿景中的 "for GenAI inference speed",这里可以解读为 "Only for GenAI inference speed"。当然这可不是像某些 AI 芯片厂商那样在 "强蹭" 大模型的热度,而是 Groq LPU 确实太 "特定域" 了,只是对于生成式 AI、对于大模型的推理加速做的特别好。而要是你再说得大一点,比如说 LPU 对于 AI 推理加速性能好,那可真的未必,毕竟近存计算其实对于 AI 的另一个大头 - 卷积神经网络的密集型计算并不友好,它的优势主要就是在内存带宽上。这样讲下来应该会形成一个概念:"LPU 的好并不是全部的好",下面展示了 LPUs 对比 GPUs 的一些特点、优劣和适用场景。

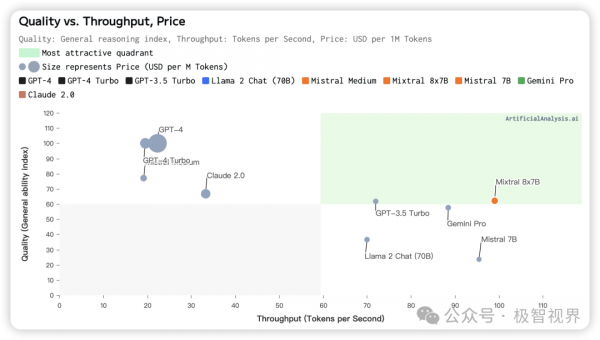

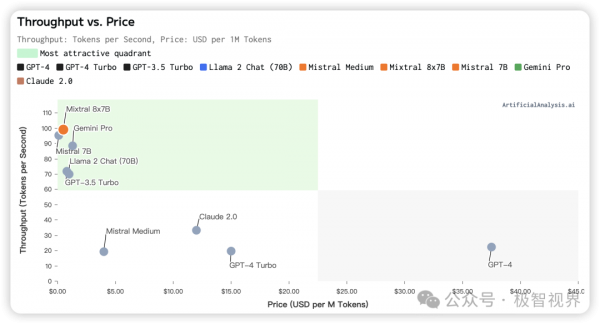

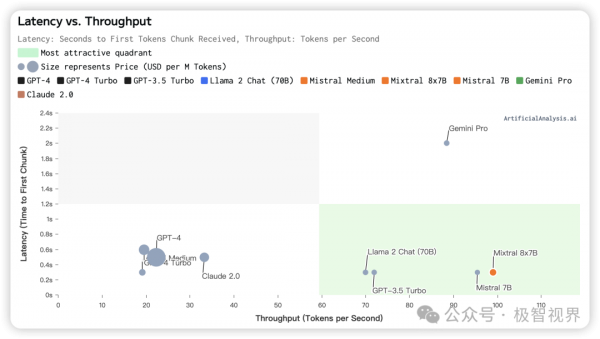

所以 LPU 相对于 GPU 来说,其实目标十分明确,主要想抓的就是 LLM 的契机,GPU 得益于其强大且数量庞大的计算核心 CUDA Core + Tensor Core 而在并行计算的各种任务中表现出色,而 LPU 得益于其遥遥领先的内存带宽水平而在 NLP + LLM 推理中表现突出。具体来说,Groq 的 LPU 能够以每秒超过 100 tokens 的推理速度来处理像 Llama-2 70B 这样的大语言模型,另外 LPU 对于现在很火的 Mixtral、Gemini 等大语言模型,也都有着超高的吞吐。而这些在 GPU 上就很难做到了,特别是考虑同样计算密集和价格的情况下,LPU 的表现尤为突出。

下面展示了 LPU 本身的 "Quality vs. Throughput, Price" 、"Throughput vs. Price" 以及 "Latency vs. Throughput",其实都是为了展示 LPU 在 LLM 上的卓越性能。

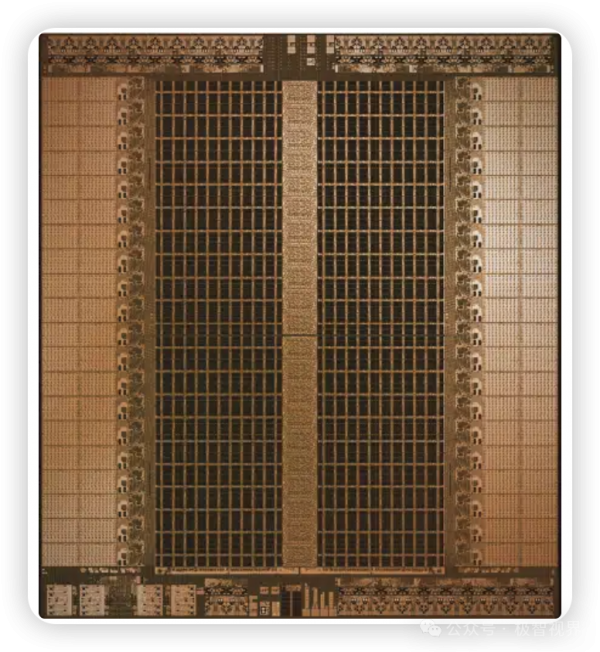

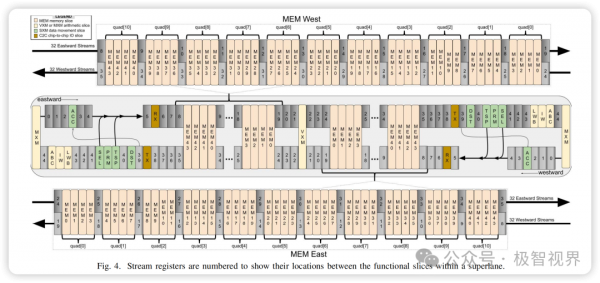

了解了 LPU 在 LLM 中的强悍性能之后,往底层来看一下 LPU 的架构,下面展示了 LPU 一个简单的架构图。

前面说到正是由于 Groq 的创始团队来自于 Google TPU,所以 LPU 的架构设计肯定离不开 TPU 的脉动阵列架构,实际也确实如此。介绍一下脉动阵列是怎么处理矩阵计算的,为了执行矩阵操作,将参数从 HBM 内存加载到矩阵乘法单元中,在每次执行乘法运算时,所得结果都会直接传递给下一个乘法累加器,输出是数据和参数之间所有乘法结果的总和,而在在矩阵乘法过程中,不需要再次访问内存了。下面展示了脉动阵列的计算 Pipeline 动画演示。

关于 LPU 架构设计更加具体的介绍,可以去翻翻 Groq 在 2020 年和 2021 年的下面两篇论文。

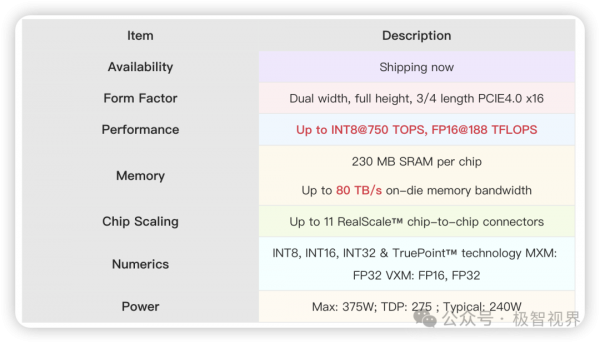

在了解了 LPU 的性能和架构之后,接着上升到产品级别,来看一下 LPU 这块卡的 "庐山真面目"。

下面整理了这张卡的主要特性参数,

整个性能参数表达的强烈信息就是:算力数据不错 (只能说不错,不能说很顶,参考 NVIDIA H100 稀疏算力 INT8@2000TOS),卡内内存带宽超高 (得益于近存计算,这个 80 TB/s 的带宽数据是好几倍于 H100 一倍的存在,但是需要注意的是卡内,LPU 卡间互联还是采用 x16 PCIE4.0,这肯定比不上 NVIDIA 的 NvLink)。

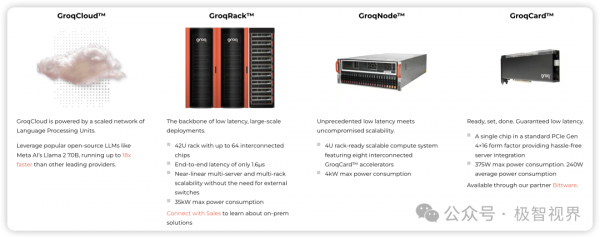

熟悉 AI 芯片产品矩阵的朋友应该会了解,在板卡之上,还会有服务器、云之类的算力产品形式,Grop 也类似,特别是云,基本是大模型时代算力很巴适的提供方式了。

好了,以上分享了 解读近存计算AI芯势力Groq LPU,希望我的分享能对你的学习有一点帮助。

好文章,需要你的鼓励

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

荷兰公司DuRoBo在CES 2026展示新款电子阅读器Krono,采用智能手机外观设计并内置AI助手。该设备定位为"电子纸专注中心",支持阅读、思考和音乐播放。配备智能转盘便于操作,AI助手Libby可回答问题并支持深度思考。搭载Android 15系统,可访问谷歌应用商店。售价239.99欧元,本月发货。

AWS推出AI图像编辑新突破:用说话就能精准移动图片中的物体!

这项由香港中文大学和AWS团队联合开发的研究推出了TALK2MOVE系统,实现了用自然语言精准操作图片中物体的位置、角度和大小。该系统采用强化学习训练方式,通过空间感知奖励机制和智能步骤采样技术,在移动、旋转、缩放三类操作上的准确率显著超越现有方法,同时大幅降低了对昂贵训练数据的依赖,为AI图像编辑领域带来重要突破。

OpenAI推出ChatGPT Health医疗问答功能

OpenAI预览了即将推出的ChatGPT Health功能,可帮助用户获取医疗信息。该功能能解释化验结果、制定运动计划、推荐就医问题等。用户可通过B.well平台导入健康记录,与Apple Health等健康应用集成。OpenAI将单独存储医疗数据,采用专用加密和隔离机制保护隐私。功能基于HealthBench数据集开发,包含超过48000个医生编写的评估标准。目前通过等待名单限量测试。

斯坦福大学等联合发布:AI助手在企业政策执行上竟然“偏科“得如此严重

斯坦福大学等知名机构联合研究发现,企业AI助手在执行组织政策时存在严重"偏科"问题:处理允许请求时成功率超95%,但拒绝违规请求时仅13-40%。研究团队开发的COMPASS评估框架通过8个行业5920个测试问题,揭示了AI助手普遍缺乏"拒绝技能"的问题,并提出了针对性训练解决方案。