OpenAI和Google接连两天的大动作,都想让AI助手成“精” 原创

看过昨天OpenAI的春季发布后,不难猜到,在今天的谷歌I/O大会上,必然会有关于AI助手的介绍。

毕竟,抢在谷歌I/O大会前发布GPT-4o的Altman,已经显示出了十足的针对性,凭借Altman的手段,自然也有着十足的把握做到精准打击,将这场“红蓝对抗”进行到底。

果不其然,大会上,谷歌CEO Pichai请来了DeepMind创始人Demis,谷歌全新的AI助手Project Astra正是由首次登台谷歌I/O大会的Demis揭开的神秘面纱。

什么是Project Astra?

Project Astra是一个由谷歌Gemini作为基础引擎的实时、多模态通用人工智能助手,相当于是Google Assistant的继任者。

与Siri、Alexa等以往我们使用的AI助手相同的是,你依然可以用语音与它进行交互;不同的是,借助生成式AI独有的特性,它现在拥有了更好的理解能力、可以干更多事情,更重要的是,这次它还有了视觉识别能力,让AI助手得以睁眼看世界。

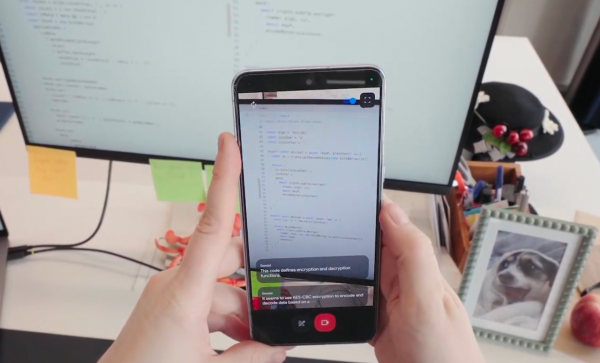

在大会上谷歌的视频演示中,着重演示的正是这一AI助手的视觉智能。

在演示视频中,一位谷歌工程师拿着打开摄像头的手机,让Gemini识别空间中能发出声音的物体、识别显示器屏幕上显示的代码的功能,甚至通过户外街景识别演示者现在所在地址。

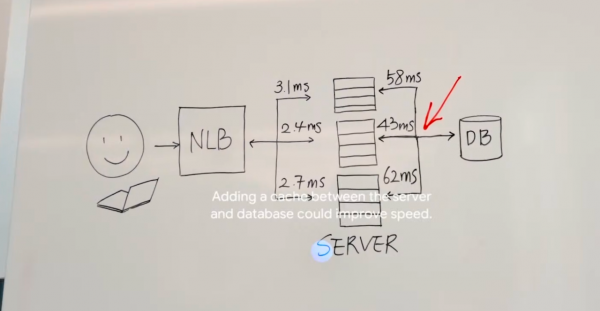

除了将AI助手应用到手机上,谷歌还将AI助手应用到了AR眼镜上,当这位工程师将搭载这一AI助手的智能眼镜对准黑板上设计的系统并提出如何改善这一系统时,AI助手甚至能给出系统设计的改善建议。

这是谷歌在AI助手上展示出的视觉智能,在Gemini加持下,这样的AI助手在交互能力上已经得到了极大的增强。

不过,在实际交互的自然度上,这样的AI助手依然与昨天OpenAI GPT-4o展示出的效果形成了不小的差距。

OpenAI“截胡”成功

就在谷歌I/O大会前一天,OpenAI召开了一场声势浩大的春季发布会,GPT-4o是这次春发的主角,部署在手机上的AI助手则是这次发布会重点演示的功能。

从OpenAI发布会上演示的AI助手能力来看,无论是在演示内容的亲民程度、交互过程的自然度,还是这一AI助手多模态能力上,演示效果都要更好。

这是因为OpenAI将GPT-4o装载到手机上时,不仅加入了视觉智能,还让这个AI助手能够实时响应(官方给出的平均响应延时是320毫秒),可以被随时打断,甚至还能理解人类的情绪。

在视觉智能方面能力演示过程中,OpenAI在纸上写了一道数学方程让AI助手一步一步解题,像极了一位小学老师。

而当你和GPT-4o打“视频电话”时,它又可以识别你的面部表情,理解你的情绪,知道你现在看起来是开心还是难过,活脱就是一个human being。

不难发现,在如今大模型技术加持下,谷歌和OpenAI都在试图将原来粗糙不堪的AI助手进行回炉再造,想让AI助手能够像真人一样与我们自然交互。

而从前后两个发布会视频演示结果来看,以大模型作为基础引擎的AI助手,也确实让我们明显感受到了,现在的AI助手与此前的Siri、Alexa有了明显的代际差。

实际上,在生成式AI、大模型技术发展如火如荼的当下,苹果也在试图让Siri脱胎换骨,此前彭博社就曾援引知情人士消息报道称,苹果正与OpenAI和谷歌分别在谈合作,想要将他们的大模型用到iOS 18操作系统中。

至于这样的AI助手是否能让Siri再次翻红,成为AI手机的杀手级应用,接下来,就看苹果能否再次为AI助手顺利“附魔”了。

好文章,需要你的鼓励

伊斯法罕大学研究团队揭秘:AI教育应用如何在数字化教学时代赢得用户青睐

伊斯法罕大学研究团队通过分析Google Play商店21款AI教育应用的用户评论,发现作业辅导类应用获得超80%正面评价,而语言学习和管理系统类应用表现较差。用户赞赏AI工具的快速响应和个性化指导,但抱怨收费过高、准确性不稳定等问题。研究建议开发者关注自适应个性化,政策制定者建立相关规范,未来发展方向为混合AI-人类模型。

Google发布Gemini 3 Flash并将其设为默认模型

谷歌发布基于Gemini 3的快速低成本模型Flash,并将其设为Gemini应用和AI搜索的默认模型。新模型在多项基准测试中表现优异,在MMMU-Pro多模态推理测试中得分81.2%超越所有竞品。该模型已向全球用户开放,并通过Vertex AI和API向企业及开发者提供服务。定价为每百万输入token 0.5美元,输出token 3美元,速度比2.5 Pro快三倍且更节省token用量。

伊利诺伊大学香槟分校团队揭秘:如何在数据海洋中精准找到“最对胃口“的训练素材

这项由伊利诺伊大学香槟分校等四所院校联合完成的研究,提出了名为DaSH的层次化数据选择方法。该方法突破了传统数据选择只关注单个样本的局限,通过建模数据的天然层次结构,实现了更智能高效的数据集选择。在两个公开基准测试中,DaSH相比现有方法提升了高达26.2%的准确率,同时大幅减少了所需的探索步数。

英特尔酷睿Ultra第三代,如何推动AI PC规模化落地?

Google发布Gemini 3 Flash并将其设为默认模型

# 思科自研AI模型正式应用于产品,首先赋能身份安全服务

超大规模云厂商在2025年是解决了电力问题还是重新思考了问题?

# 英伟达成为唯一能免费提供AI模型的厂商

Retell AI推出自动化质检系统,解决语音智能体人工审核瓶颈

# 法国生物科技公司发布全球首个生物学通用AI模型

# JEDEC开发减少引脚数的HBM4标准以提升容量

# Ewigbyte光学归档存储技术及战略解析

2025年:可穿戴设备全面转向AI技术

# Oracle领衔科技巨头5000亿美元AI数据中心租赁狂潮

新农人:西云数据如何绘制智慧农牧“全景图”

DeepSeek之后,中国人形机器人以“群体智能”再次掀起技术浪潮

QwQ-32B模型成本地部署福音,通义App可第一时间体验

入局智驾的印奇,看到了怎样的未来?

成本打到6万以下,手把手教你用4路锐炫显卡+至强W跑DeepSeek

千里科技亮相吉利AI智能科技发布会,共启“AI+车”新纪元

天翼云CPU实例部署DeepSeek-R1模型最佳实践

京东云与宝德计算战略签约,共绘分布式存储与智算新未来

全球AI顶会AAAI 2025 在美开幕,产学研联手的“中国队”表现亮眼

蚂蚁数科提出创新跨域微调框架ScaleOT入选全球AI顶会AAAI 2025

国产软件再破记录!阿里云PolarDB数据库登顶TPC-C双榜第一