不急于求成的雷鸟创新,想造出“年轻人的第一台AR眼镜” 原创

10月28日,在今年的秋季新品发布会上,雷鸟创新正式对外发布了雷鸟Air 3系列产品。

这是在雷鸟创新在今年陆续完成5亿元融资、XR光学和整机两大总部落地计划公布后,雷鸟对外发布的又一款新品。

值得注意的是,雷鸟此次发布的雷鸟Air 3用上了与TCL联合研发的孔雀光学引擎、与视涯联合研发的第五代Micro-OLED方案,还在画质调校、扬声器设计上下了大功夫。

雷鸟创新创始人兼CEO李宏伟在发布会上称,雷鸟创新希望借助这代产品,开创全民AR时代。

为此,雷鸟创新不仅将这代产品定价到了1699元,还发布了针对索尼屏幕进行了重新色彩调校优化的雷鸟Air 2三周年冠军版,并将这款产品定价到了1399元。

AR行业的歧途和正道

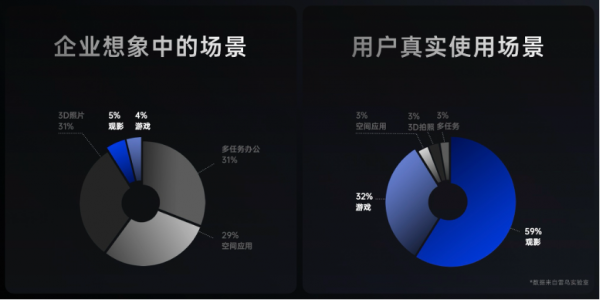

“大家都想将AR眼镜变成下一代计算平台,但91%的分体式AR眼镜用户主要使用AR眼镜来做两件事——观影和游戏。”

当前市场上大量AR公司在用户使用9%的场景里投入了90%的研发精力,李宏伟认为,现在的AR行业正在“误入歧途”。

“雷鸟Air 3的定位十分清晰,即抛弃其他一切伪需求场景,专注于用户的观影和游戏体验,打造影音AR眼镜的下一代天花板。”李宏伟在发布会上如是说。

在李宏伟看来,当前的AR眼镜尚未成熟到可以完全取代手机的地步,离真正成为主流智能终端还有一段路要走。

因此,雷鸟创新一方面持续在最前沿的光波导技术上进行突破,以实现更高的显示效果和更轻便的佩戴体验。

实际上,前不久Meta对外发布并引起高度关注的AR眼镜Orion,用的也正是光波导技术路线。

此外,这代产品沿用了对观影体验更友好的BirdBath光学方案,并针对关键技术细节进行了优化,具体而言:

在画质上,雷鸟Air 3搭载了雷鸟创新与TCL联合研发的全新孔雀显示引擎,在光路系统上率先实现了多层高精度AR镀膜,有效减少杂光干扰,带来更纯净的画面。

Air 3实现了14mm*7mm的超大Eyebox面积,可适配93%的瞳距人群,使不同头型的用户都可以获得一致的清晰观影体验。

这代产品还搭载了雷鸟创新与视涯共同首发的第五代Micro-OLED,相比上一代产品,第五代Micro-OLED在降低功耗的同时,显著提升了显示效果,并实现了硬件级的抗疲劳保护,为长时间观影提供了专业护眼保障。

据雷鸟创新官方数据显示,雷鸟Air3能实现145% sRGB色域覆盖,650nits的入眼亮度和200000:1的对比度,使高光和暗部细节呈现更为丰富。

在护眼技术上,Air 3首次将高端手机的护眼科技引入AR眼镜领域,实现了双重护眼。雷鸟Air 3不仅延续了上一代的硬件防蓝光技术,还支持3840Hz的PWM高频调光,有效缓解用眼疲劳,并通过南德TUV防蓝光和抗疲劳双重认证。

在音质上,Air 3搭载了独家的双单元背靠背音频结构,声压级为行业平均水平的2.5倍,让眼镜音质表现达到新的高度,实现更为震撼的听觉体验。

全民AR时代要来了?

作为被视为科技感十足的硬件品类,如何推动这一品类在消费市场普及,让AR眼镜真正成为一种生活方式,是AR厂商需要考虑的问题。

作为国内核心玩家,雷鸟创新同样希望推动这一产品在国内普及开来。

为此,雷鸟创新将雷鸟Air 3定价到了2000元以内——1699 元。

李宏伟称,“雷鸟创新希望雷鸟Air 3的推出可以像电动汽车行业中的Model 3,依托行业领导者的地位,通过技术迭代和产业链联动,不断降低成本、提高品质,从而让价格触及更多消费者的可承受范围。”

实际上,此次雷鸟创新在新品上的定价策略背后,有赖于雷鸟创新核心部件和显示技术的自主研发,以及与供应链伙伴的深度合作。

雷鸟创新对产业链的深度整合,让雷鸟Air 3有了进一步进行市场下沉的可能。

此外,雷鸟创新还发布了定价1399元的雷鸟Air 2三周年冠军版,李宏伟称,雷鸟创新是希望这款产品可以成为“年轻人的第一台AR眼镜”。

聚焦用户最关心的“观影+游戏”体验,以高质量的显示和音效体验打破传统界限,为用户提供极致的影音享受,是雷鸟创新当下做AR眼镜的产品策略,也是李宏伟对当下AR行业的判断。

那么,不急于求成的雷鸟创新,能否打造出“年轻人的第一台AR眼镜”?

好文章,需要你的鼓励

Monte Carlo推出AI智能体全栈可观测性工具

大数据可观测性初创公司Monte Carlo Data推出全新Agent Observability产品,为AI应用提供全方位数据和AI可观测性。该工具帮助团队检测、分类和修复生产环境中AI应用的可靠性问题,防止代价高昂的"幻觉"现象,避免客户信任度下降和系统宕机。新产品采用大语言模型作为评判器的技术,能够同时监控AI数据输入和输出,提供统一的AI可观测性解决方案。

Meta与特拉维夫大学联手打造VideoJAM:让AI生成的视频动起来不再是奢望

Meta与特拉维夫大学联合研发的VideoJAM技术,通过让AI同时学习外观和运动信息,显著解决了当前视频生成模型中动作不连贯、违反物理定律的核心问题。该技术仅需添加两个线性层就能大幅提升运动质量,在多项测试中超越包括Sora在内的商业模型,为AI视频生成的实用化应用奠定了重要基础。

大规模npm攻击毒害180亿下载量软件包

网络安全公司Aikido披露了迄今最大规模的npm供应链攻击事件。攻击者通过钓鱼邮件获取维护者账户凭证,向18个热门JavaScript包注入恶意代码,这些包每周下载量超过26亿次。恶意代码专门劫持加密货币交易,监控浏览器API接口将资金转移至攻击者地址。受影响的包括chalk、debug等广泛使用的开发工具库。虽然攻击在5分钟内被发现并及时公开,但专家警告此类上游攻击极具破坏性,可能与朝鲜黑客组织相关。

上海AI实验室重磅发布:让AI看图“说人话“的神奇训练法,解决多模态AI与人类价值观对齐难题

上海AI实验室发布OmniAlign-V研究,首次系统性解决多模态大语言模型人性化对话问题。该研究创建了包含20万高质量样本的训练数据集和MM-AlignBench评测基准,通过创新的数据生成和质量管控方法,让AI在保持技术能力的同时显著提升人性化交互水平,为AI价值观对齐提供了可行技术路径。

VAST Data收购Red Stapler加速超大规模云服务布局

Claude新文件创建功能存在深层安全风险

苹果iPhone 17发布会最"令人惊叹"的部分?AI几乎没被提及

Empromptu推出98%精准度AI应用构建平台

每位IT领导者必须回答的9个云战略关键问题

Cirata发布Symphony平台助力企业数据管理

Together AI推出自助式GPU基础设施服务

Monte Carlo推出AI智能体全栈可观测性工具

大规模npm攻击毒害180亿下载量软件包

AI发展的幕后支柱:HDD如何助力中国及亚太地区的数字愿景

字节跳动发布 Seedream 4.0 图像创作模型,豆包、即梦可免费体验

2025年第十七届厦门国际动漫节“金海豚奖”游戏产业赛道征集

对标Ray-Ban Meta,现货发售的雷鸟V3能否卖出百万销量?

不急于求成的雷鸟创新,想造出“年轻人的第一台AR眼镜”

Meta Connect 2024,Meta 推出 Orion AR 眼镜、Quest 3S VR头显、Ray-Ban智能眼镜

雷鸟创新宣布完成多轮融资,2024年总融资金额超过5亿元

抢先苹果Vision Pro,雷鸟创新正式上线AI空间照片转换功能

布局2.2亿MAU市场,雷鸟创新携手谷歌发布全球首款AR版的Google TV

Vuforia 洞察 —— 来自 AR 领先者的观点

一年三轮融资!雷鸟创新完成新一轮亿元级融资

FFALCON雷鸟春季新品发布会亮点揭秘:鹤7 24款电视与Q8/U8显示器齐亮相

雷鸟X2 Lite亮相CES 2024:首发骁龙AR1平台,支持大模型语音助手