年度提问:创业还是创收,如何帮AI产品适配市场? 原创

这样大规模的投资,除了因为生成式AI已经成为全球科技发展的下一项关键技术,更重要的是,生成式AI烧钱速度已经不亚于半导体产业。

据此前国盛证券预测数据显示,GPT-3训练一次的成本约为140万美元,对于一些更大的LLM模型,训练成本介于200万美元至1200万美元之间。

面对如此烧钱的生成式AI,如何让这样的产品和项目适配市场,就成了推动这项技术早日完成商业闭环,推动市场成熟的关键。

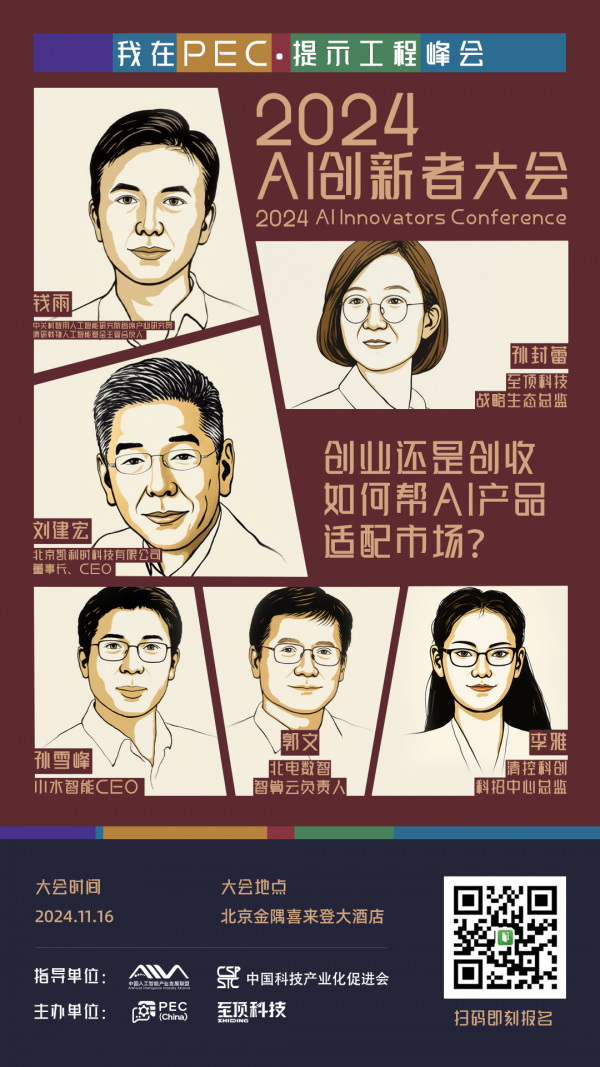

11月16日(本周六),在即将召开的2024 AI创新者大会暨PEC·提示工程峰会上,我们邀请到了中关村智用人工智能研究院首席产业研究员、清研载物人工智能基金主管合伙人钱雨、北京凯利时科技有限公司董事长、CEO刘建宏、小水智能CEO孙雪峰、北电数智智算云负责人郭文、清控科创科招中心总监李雅几位AI领域投资人、创业者和产研专家。

由至顶科技战略生态总监孙封蕾与这几位专家进行一场深度对谈,一起聊一聊——创业还是创收,如何帮AI产品适配市场?

好文章,需要你的鼓励

7个家庭AI技巧让智能聊天机器人相形见绌

家庭智能设备中的AI技术正在发挥惊人作用,包括摄像头的深度物体和活动识别、升级版语音助手如Alexa Plus/Gemini,以及能够节省开支的机器学习功能。这些应用涵盖包裹识别、声音监测、智能恒温器学习日常习惯、宠物行为识别、对话式语音控制、用水监测和漏水检测,以及视频事件摘要等七大功能,为用户提供更智能便捷的家居体验。

ByteDance联手顶尖学府重新定义AI思考:当机器学会分层理解世界

ByteDance等机构联合提出DLCM模型,通过学习语义边界动态分配计算资源,将AI从统一令牌处理转向层次化概念推理。该模型引入压缩感知缩放定律,在12项零样本测试中平均提升2.69%准确率,为构建更智能高效的AI系统开辟新路径。

Mac成为企业环境中最可持续设备的原因调查显示

MacPaw最新调查显示,自M1芯片发布五年来,Mac设备在企业中的使用寿命显著延长。近半数受访企业的Mac使用3-5年仍保持良好性能,这得益于M系列芯片出色的稳定性和能效表现。IT团队正转向自动化管理工具和AI辅助workflow来应对人手不足的挑战。虽然设备更耐用减少了硬件更换频率,但IT部门面临的安全威胁和管理复杂性持续增加,需要更简化的软件更新流程。

香港中文大学团队突破:让AI有了“超级记忆“,多步推理能力飙升!

香港中文大学团队突破AI记忆瓶颈,提出HGMEM超图记忆机制。该技术让AI具备类似人类的联想思维,能将分散信息整合成高阶理解。通过动态记忆演化和智能检索,显著提升了复杂推理能力,在长文本理解任务中全面超越现有方法,为AI向"知识理解者"转变开辟新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机

Xreal发布新款AR眼镜和电源集线器,革新工作娱乐体验

纳瓦尔Flow 2扫地机器人问世:配备AI识别技术能找到丢失物品

7个家庭AI技巧让智能聊天机器人相形见绌

Mac成为企业环境中最可持续设备的原因调查显示

首次独居必备的10款实用智能设备推荐

OpenAI重组团队开发语音AI硬件产品,2026年推出新模型

AI重塑工作格局:Mercor如何连接人才与智能体训练

科技巨头在股价飙升中套现160亿美元

联想问天 WR5215 G5服务器重磅发布:以能效和性能树立单路服务器新标准

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功