夸克"C计划"揭秘:上线“类豆包”AI对话助手,成为豆包劲敌? 原创

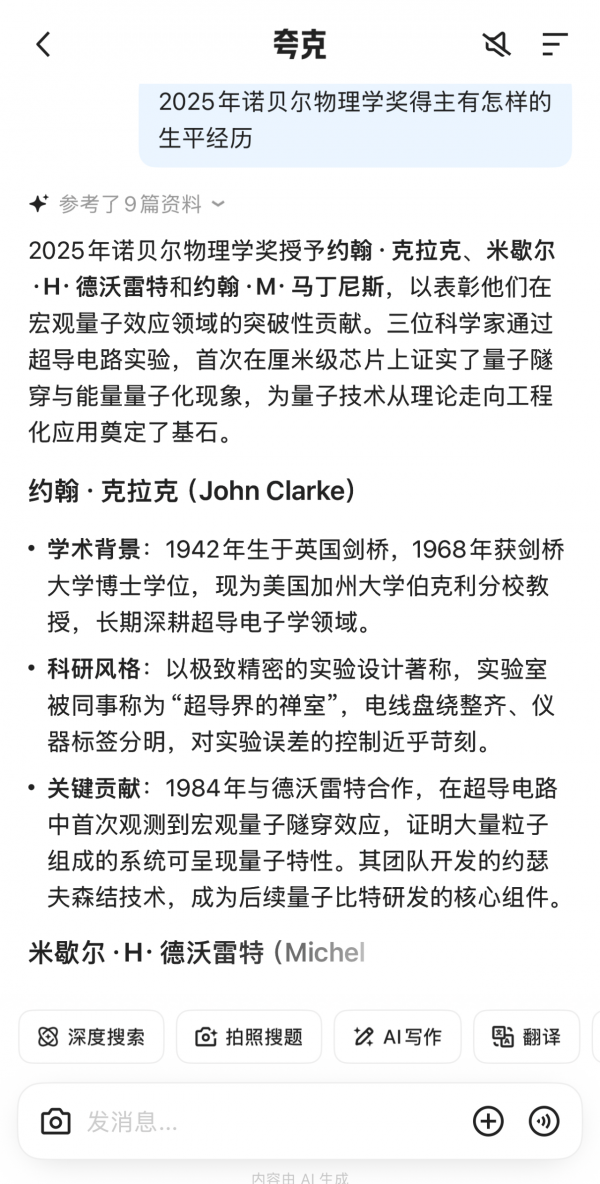

10月23日,阿里旗下AI旗舰应用夸克上线对话助手,这一采用Qwen最新闭源模型的对话助手的上线更新,让夸克实现了AI搜索与对话的深度融合。

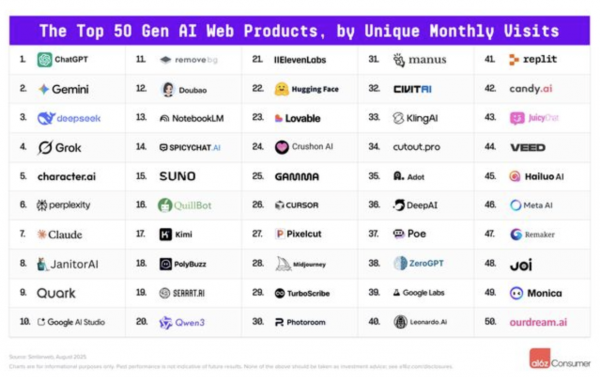

2025年是大模型重构用户体验的一年,在这一年里,国内头部AI团队也迎来了高光时刻,从2025年8月全球知名风险投资机构a16z基于过去两年多月度访问和月活用户发布的《全球Top 100生成式AI消费应用榜单》来看,在网页端和移动端TOP 50榜单中,分别有11款和22款国内产品上榜。

夸克在网页端和移动端两个榜单中均榜上有名,不过,在此之前,夸克更多是以AI搜索能力著称,相较而言,豆包则是以AI对话能力著称的AI应用。

然而,就在前不久,有媒体援引知情人士消息报道称,夸克内部正在推进一项代号为“C计划”的AI业务,这项计划由夸克核心团队主导,通义实验室也有参与,这项计划与对话式AI应用布局有关,且近日就会有应用成果落地。

如此来看,夸克此次上线的AI对话助手,正是此前业界猜测的“C计划”。

那么,夸克AI对话助手上线对于行业有怎样的影响呢?

在ChatGPT问世后,对话式AI开始形成潮流,并有与主流搜索应用结合的趋势,作为OpenAI的资方之一,微软就曾在自己的搜索引擎中引入ChatGPT,尝试将生成式AI与搜索结合,再与谷歌一争高下。

从过去两年技术发展趋势来看,微软并没能挑战谷歌在搜索领域的江湖地位,但整个行业却发生了两个变化:

第一,AI搜索开始兴起,包括谷歌、百度、夸克等搜索引擎,都开始基于生成式AI技术,优化搜索引擎,提升搜索能力;

第二,对话式AI成为区别于AI搜索的另一条被用户逐渐习惯的人机交互形式,越来越多的对话式AI应用开始兴起,在国内,豆包就成了一个标志性产品。

也是在此时、在迈入生成式AI时代时,一个问题悄然出现——用户在获取信息和解决复杂问题时,经常需要在两类应用间切换:

第一类是AI搜索引擎,用户需要基于此类应用获取即时、可验证的客观信息;

第二类是AI聊天助手,用户需要与此类应用进行深入探讨、内容创作和多轮答疑。

夸克此次的产品更新,正是为了打破这种割裂的局面。

在夸克上线AI对话助手后,用户在同一个App内,既能基于搜索引擎功能获取即使、客观信息,也与AI进行“深入”对话获取创作灵感和专业知识。

据悉,此次上线的AI对话助手还能依托夸克AI搜索的实时检索能力,对高质量信息源进行多链路的核验与追溯。

这有效地解决了独立AI助手普遍存在的“信息幻觉”问题,确保了答案的准确性和可靠性,让结果“有源可查”。

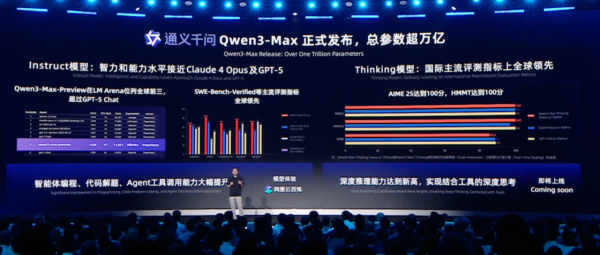

此外,作为夸克背后的通用基础大模型,Qwen最新的闭源模型也为夸克对话助手提供强大动力。

就在上个月,在2025云栖大会上,阿里正式对外发布了Qwen3-Max,这一模型性能超越GPT-5和Claude Opus 4,跻身全球前三。

据悉,为了确保生成内容的专业度,夸克算法团队已经与通义实验室成立了联合研发小组,专注于搜索推理与可信生成。

此前业界曾有猜测,夸克“C计划”是否会再造一个“豆包”来与字节竞争?

现在来看,夸克的选择是“融合”——构建一个更通用的超级AI应用。

好文章,需要你的鼓励

手机里的NPU越来越强,为什么AI体验还在原地踏步?

尽管芯片厂商不断推出性能更强的神经处理单元,声称比上代产品快30-40%,但大多数AI功能仍依赖云端处理。专家指出,云端AI模型拥有数千亿参数,而手机NPU只能处理约30亿参数的模型。本地AI处理虽然在隐私保护和可靠性方面具有优势,但受限于内存容量和处理能力,目前主要应用于特定场景。业界正致力于优化模型压缩技术,实现云端与本地AI的混合处理模式。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

如何使用现有基础设施让数据做好AI准备

Hammerspace通过现有NVMe存储最大化GPU使用率。随着AI计算在混合云和多云环境中扩展,基础设施团队面临着加速洞察时间同时最大化GPU投资的压力。Hammerspace Tier 0将GPU服务器集群内的本地NVMe存储转换为超高速共享存储层,性能比传统网络存储提升10倍,减少检查点时间,提高GPU使用率,改善推理响应时间,无需额外存储系统,节省数百万美元成本。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容

押注AI智能体,奇奇科技跨越十年的“换挡”与远航

联想天禧AI及创新终端设备在2025 AIE博览会获两项大奖,引领个人AI体验创新

豆包手机助手调整部分AI能力 呼吁保障用户AI使用权

私有化云端:私有云和主权云的崛起