Nature子刊发表!基于昇思MindSpore打造的AI+科学计算新成果PeRCNN面世

近日,华为与中国人民大学高瓴人工智能学院孙浩教授团队合作,基于昇思MindSpore AI框架提出了物理编码递归卷积神经网络(Physics-encoded Recurrent Convolutional Neural Network,PeRCNN),该成果已在《Nature》子刊《Nature Machine Intelligence》上发表,相关代码已在开源社区Gitee的MindSpore Flow代码仓开源[1]。

PeRCN相较于物理信息神经网络、ConvLSTM、PDE-NET等方法,模型泛化性和抗噪性明显提升,长期推理精度提升了10倍以上,在航空航天、船舶制造、气象预报等领域拥有广阔的应用前景。

PDE方程在对物理系统的建模中占据着中心地位,但在流行病学、气象科学、流体力学和生物学等等领域中,很多的底层PDE仍未被完全发掘出来。而对于那些已知的PDE方程,比如Navier-Stokes方程,对这些方程进行精确数值计算需要巨大的算力,阻碍了数值仿真在大规模时空系统上的应用。目前,机器学习的进步提供了一种PDE求解和反演的新思路。

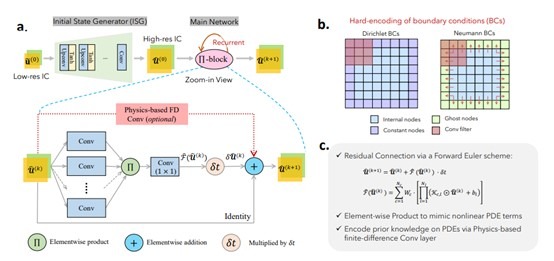

PerCNN的模型架构

已有的数据驱动的模型依赖于大数据[2],这在大多数的科学问题上很难满足,同时还存在解释性的问题。物理约束的神经网络(PINNs)[3]虽然做到了利用先验知识去约束模型的训练从而减少对数据的依赖,但是PINN基于损失函数的软约束限制了最终结果的准确性。如何在缺少有效数据的情形下,得到具有高精度、鲁棒性、可解释性和泛化性的结果,仍是学界努力的方向。

因此,华为与孙浩教授团队合作,利用昇腾AI澎湃算力、依托昇思MindSpore AI框架开发了物理编码递归卷积神经网络[4],实现了对非线性PDE的精确逼近。

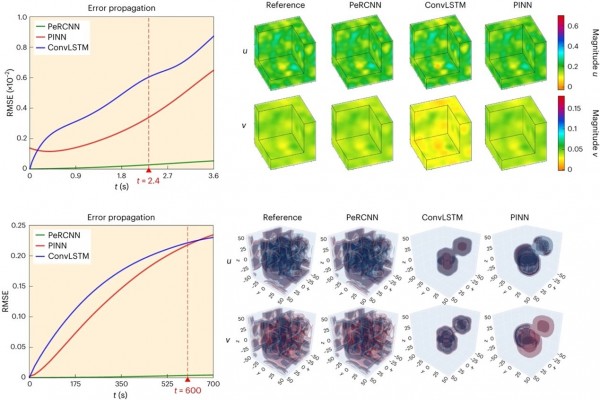

PeRCNN在反应扩散方程的应用,长期演化上优于ConvLSTM\PINN等方法

PeRCNN神经网络强制编码物理结构,基于结合部分物理先验设计的π-卷积模块,通过特征图之间的元素乘积实现非线性逼近。该物理编码机制保证模型根据我们的先验知识严格服从给定的物理方程。所提出的方法可以应用于有关PDE系统的各种问题,包括数据驱动建模和PDE的发现,并可以保证准确性和泛用性。

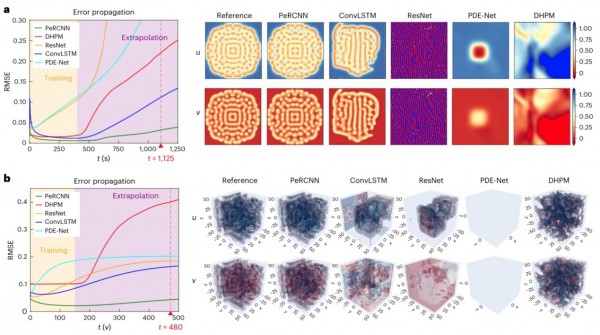

PeRCNN在预测和外推的性能上也优于ConvLSTM/ResNet/PDE-Net/DHPM等方法

PeRCNN的另一个独特优势是其可解释性,这源自π-卷积的乘法形式。通过符号计算,可以从学习到的模型中进一步提取底层的基础物理学表达式。这让PeRCNN能够作为一项有效的工具帮助人们从不完善和高噪声的数据中准确可靠地发现潜在的物理规律。

流体力学、气象、海洋等学科中,存在湍流、激波等强非线性现象,传统数值方法的求解需要大量计算资源,当前AI已经在飞行器流场、中期天气预报等问题中展现出极大的潜力,PeRCNN具备高精度、泛化性强和抗噪性强等特点,将有望在这些领域突破传统计算瓶颈,加速工业仿真和设计,成为AI+科学计算领域的新利器!

[1]https://gitee.com/mindspore/mindscience/tree/master/MindFlow/applications/data_mechanism_fusion/PeRCNN

[2]Yann LeCun, Yoshua Bengio, and Geoffrey Hinton. Deep learning. Nature, 521(7553):436–444, 2015.

[3]Maziar Raissi, Paris Perdikaris, and George E Karniadakis. Physics-informed neural networks: A deep learning framework for solving forward and inverse problems involving nonlinear partial differential equations. Journal of Computational Physics, 378:686–707, 2019.

[4]Chengping Rao, Pu Ren, Qi Wang, Oral Buyukozturk, Hao Sun*, Yang Liu*. Encoding physics to learn reaction-diffusion processes. Nature Machine Intelligence, 2023, DOI: 10.1038/s42256-023-00685-7

来源:至顶网人工智能频道

好文章,需要你的鼓励

CIO对2026年AI发展的五大预测

2025年,企业技术高管面临巨大压力,需要帮助企业从持续的AI投入中获得回报。大多数高管取得了进展,完善了项目优先级排序方法。然而,CIO仍面临AI相关问题。支离破裂的AI监管环境和宏观经济阻力将继续推动技术高管保持谨慎态度。随着AI采用增长的影响不断显现,一些CIO预期明年将带来劳动力策略变化。

Anthropic最新CJE技术:让AI评判AI不再瞎猜,终结LLM评估乱象

这篇论文提出了CJE(因果法官评估)框架,解决了当前LLM评估中的三大致命问题:AI法官偏好倒置、置信区间失效和离线策略评估失败。通过AutoCal-R校准、SIMCal-W权重稳定和OUA不确定性推理,CJE仅用5%的专家标签就达到了99%的排名准确率,成本降低14倍,为AI评估提供了科学可靠的解决方案。

云成本管理变得更加便捷

FinOps基金会周四更新了其FinOps开放成本和使用规范云成本管理工具,新版本1.3更好地支持多供应商工作流。该版本新增了合同承诺和协商协议数据集,增加了跨工作负载成本分摊跟踪列,以及云支出和使用报告时效性和完整性的元数据可见性。随着云和AI采用推动企业IT预算增长,技术供应商正在关注将成本与价值联系起来的努力。大型企业通常使用三到四家云供应商,小企业可能使用两家,同时还有数据中心、SaaS和许可等服务。

NVIDIA团队让立体视觉AI实现“真正“实时运行:速度提升10倍却不牺牲精度

NVIDIA团队开发出Fast-FoundationStereo系统,成功解决了立体视觉AI在速度与精度之间的两难选择。通过分而治之的策略,该系统实现了超过10倍的速度提升同时保持高精度,包括知识蒸馏压缩特征提取、神经架构搜索优化成本过滤,以及结构化剪枝精简视差细化。此外,研究团队还构建了包含140万对真实图像的自动伪标注数据集,为立体视觉的实时应用开辟了新道路。

昇思MindSpore 2.3全新发布 | 昇思人工智能框架峰会2024圆满举办

中国光谷·多模态人工智能大会暨多模态人工智能产业联合体第三次全体会议圆满召开

Nature子刊发表!基于昇思MindSpore打造的AI+科学计算新成果PeRCNN面世

WAIC2023最高荣誉SAIL奖揭晓!昇思MindSpore使能大模型、AI4S打造流体仿真重器

人工智能框架生态峰会2023·昇思MindSpore科学智能专题论坛顺利举办

人工智能框架生态峰会MindSpore TechDay成功举办,一起昇思,无尽创新

人工智能框架生态峰会2023顺利举办,助力产教融合,使能千百行业

人工智能框架生态峰会2023丨软通动力成为昇思MindSpore开源社区理事会首批成员单位

基于昇思AI框架的全模态大模型“紫东.太初2.0”正式发布

昇思MindSpore与产学界共同探索大模型&科学智能原生创新