阿里云周靖人:发布通义千问2.5,坚持做开源大模型 原创

2023年4月,通义千问正式面世,阿里的大模型征程就此进入大众视野。

在过去一年里,阿里云通义千问对内经历了多次产品升级和迭代,对外经历了百模大战和持续开源。

时隔一年后,5月9日,阿里云在北京召开AI智领者峰会,大会上,阿里云CTO周靖人正式发布了通义千问2.5版本,与此同时,“通义千问APP”正式更名为“通义APP”。

在这一年,全球不需要大量基础大模型成为共识,有竞争力的基础大模型开始收敛到10家以内,对于阿里云来说,如何围绕基础大模型和开源大模型打造出更完善的生态就成了一个关键问题。

总结过去一年发展历程,周靖人在大会上指出,“从2022年9月发布通义系列模型以来,如今我们的API日调用量已经过亿。”

在这个过程中,阿里云通义系列大模型已经服务了包括新浪微博、中国一汽、完美世界、蓝凌科技在内的9万家企业用户。

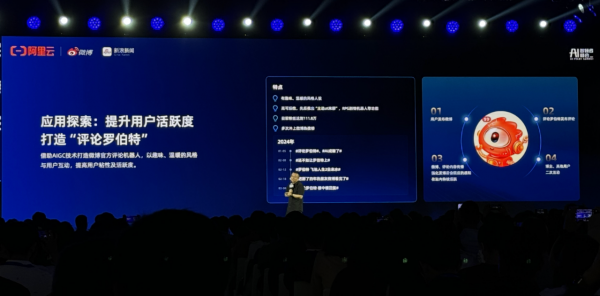

其中,作为阿里云通义千问最早的用户,微博目前已经将大模型技术应用到了AI评论、AI明星陪聊、虚拟角色帐号、星座大模型、信息流广告创意生成等场景,据微博COO、新浪移动CEO王巍透露,借助AIGC技术,微博打造了官方评论机器人“评论罗伯特”。

如今,“评论罗伯特”拥有超百万粉丝,已经成了百万粉丝博主。

作为刚刚因电动汽车发布爆红全网的小米,同样是阿里云通义大模型的用户。

据悉,小米的人工智能助手小爱同学基于阿里云通义大模型在强化其在图片生成、图片理解等方面的多模态AI生成能力,并在小米汽车、音箱、手机等多类硬件产品中落地应用。

小米集团小爱总经理王刚指出,“通过使用大模型技术,小爱同学活跃用户次日留存率提升了10%,中长尾问答类问题的回答满意度从30%-40%提升到了80%。”

大会上,阿里云正式对外发布了通义千问2.5,全新的通义千问2.5在各方面性能上进行了一系列升级:

在文档处理能力方面,通义千问2.5单次可处理多达1000万字的长文档,可以同时解析100份不同格式的文档;

在音视频理解能力方面,通义千问2.5可以精准高效地进行音视频文件的识别理解、摘要总结、多语言翻译,可同时上传处理50个音视频文件;

在智能编码能力方面,通义千问2.5集成了通义灵码,可以帮助用户随时随地在手机上写代码、读代码、学习编程技能。

发布会现场,周靖人还将通义千问2.5与自家的通义千问2.1版本和GPT-4 Turbo进行了性能对比。

从大会上的对比数据可以看到,相较此前的通义千问2.1版本,通义千问2.5的理解能力、逻辑推理、指令遵循、代码能力分别提升了9%、16%、19%、10%;而在OpenCompass的测评结果中,通义千问2.5的得分也已经追平GPT-4 Turbo。

在这次大会上,阿里云还对通义大模型进行了品牌升级,“通义千问APP”正式更名为“通义APP”,通义APP集成通义大模型全栈能力,并免费为所有用户提供服务。

作为开源大模型的坚实拥趸,自2023年8月以来,阿里云陆续开源了十数款模型,据官方公布数据显示,目前通义开源模型下载量已经超过了700万。

也是在这场发布会上,阿里云官方表示,通义千问最新开源的1100亿参数模型在多个基准测评收获最佳成绩,超越Meta的Llama-3-70。

据悉,目前阿里云通义系列模型参数规模横跨5亿到1100亿,小尺寸模型有0.5B、1.8B、4B、7B、14B参数规模,可用于手机、PC等端侧设备部署;大尺寸模型有72B、110B参数规模,能支持企业、科研级应用。

此外,阿里云还开源了视觉理解模型Qwen-VL、音频理解模型Qwen-Audio、代码模型CodeQwen1.5-7B、混合专家模型Qwen1.5-MoE。

此外,作为阿里云构建的模型开源社区——魔搭(ModelScope)已经拥有模型数量超过4500个,用户规模超过500万。

周靖人在大会上表示,“今天我们可以很自豪地讲,阿里云是全球唯一一家既在持续做(大)模型开发,又做大量(大)模型开源的公司。”

好文章,需要你的鼓励

SynLogic:香港科技大学与MiniMax联合开发的逻辑推理数据集,让AI更懂得思考

来自香港科技大学和MiniMax的研究团队开发了SynLogic,一个可合成35种逻辑推理任务的框架与数据集,填补了AI逻辑训练资源缺口。研究表明,在SynLogic上进行强化学习训练显著提升了模型逻辑推理能力,32B模型在BBEH测试中超越了DeepSeek-R1-Distill模型6个百分点。更值得注意的是,将SynLogic与数学和编程数据混合训练不仅提高了这些领域的学习效率,还增强了模型的泛化能力,表明逻辑推理是构建通用AI推理能力的重要基础。

大型语言模型的一步生成能力:揭秘人工智能“一口气“说故事的秘密 - AIRI与Skoltech研究成果

这项研究揭示了大型语言模型的惊人能力:只需两个特殊训练的向量,冻结的语言模型就能在一次计算中生成数百个准确词汇,而非传统的逐词生成。研究者发现,这种能力要求特定的输入排列方式,且生成速度比自回归方法快约279倍。这一发现不仅展示了语言模型未被充分探索的并行生成潜力,还为快速文本重建开辟了新方向。

深度解析:腾讯混元团队《先走后跑》——利用强化学习实现大模型简洁推理的新突破

腾讯混元团队提出的"ConciseR"是一种通过两阶段强化学习实现大模型简洁推理的新方法。研究遵循"先走后跑"原则,先确保模型具备准确推理能力,再优化输出简洁性。第一阶段通过改进的群体相对策略优化(GRPO++)提升推理能力,第二阶段通过长度感知的群体相对策略优化(L-GRPO)减少输出长度。实验结果显示,该方法在AIME、MATH-500等多个基准测试中既减少了输出长度(平均20%以上),又保持或提高了准确率,展现出高效率-高准确率的理想平衡。

压缩还是行动?实测告诉你压缩后的大语言模型是否真能胜任Agent任务

这项由香港科技大学团队开展的研究首次全面评估了压缩对大语言模型Agent能力的影响。研究发现,虽然4位量化能较好地保留工作流生成和工具使用能力(仅下降1%-3%),但在实际应用中性能下降达10%-15%。团队提出的ACBench基准测试横跨工具使用、工作流生成、长文本理解和实际应用四大能力,评估了不同压缩方法对15种模型的影响。结果显示,AWQ量化效果最佳,蒸馏模型在Agent任务上表现不佳,大型模型对压缩更具韧性。研究还提出ERank等创新分析方法,为实际部署提供了切实指导。

现在的AI已经有可能超越人类,INTUITOR系统让AI获得自我评估能力

百度2025 Q1财报深度解读:智能云表现强劲,萝卜快跑已拓展全球 李彦宏详解AI战略:AI-first战略使百度保持领先地位

重新思考数据中心架构,推进AI的规模化落地

DeepMind CEO哈萨比斯:AGI将在2030后到来,年轻人要更重视怎么学习而非学什么专业,梵高画作震撼人心是因为他的人生

大模型应该怎么用?我们大多数人都错了,微软最新研究:大模型对话次数越多,性能越差

英伟达发布Q1财报,黄仁勋:有没有美国芯片,中国AI都会高速发展

五大机器人团队谈:人形机器人的卡点和破局之道

从 0.1% 到无穷大:不断扩大的 GPT 模型如何在未知化学宇宙中变革药物发现的未来

Mistral AI 推出代理框架以争夺企业市场

对抗性 AI:金融网络安全的新前沿

Sardina 向 SUSE Enterprise Storage 用户抛出诱饵

Nvidia 超预期Q1业绩,营收同比增长 69%